Elastic Stack-Features

Von Sicherheit auf Enterprise-Niveau und entwicklerfreundlichen APIs über Machine Learning bis hin zu Graph-Analytics bietet der Elastic Stack zahlreiche Features (ein Teil davon wurde bisher als „X‑Pack“ angeboten), mit denen Sie alle Arten und Mengen von Daten ingestieren, speichern, analysieren, durchsuchen und visualisieren können.

Verwaltung und Betrieb

Skalierbarkeit und Resilienz

Monitoring

Management

Alerting

Stack-Security

Bereitstellung

Ingestieren und Anreichern

Datenquellen

Datenanreicherung

Module und Integrationen

Datenspeicher

Flexibilität

Security

Suchen und Analysieren

Volltextsuche

Machine Learning

Erkunden und visualisieren

Visualisierungen

Teilen und zusammenarbeiten

Elastic Maps

Elastic Metrics

Elastic Uptime

Elastic Security

Verwaltung und Betrieb

Verwaltung und Betrieb

Skalierbarkeit und Resilienz

Elasticsearch arbeitet in einer verteilten Umgebung, die von Grund auf so entwickelt wurde, dass Sie sich keine Sorgen um Ihre Daten machen müssen. Unsere Cluster wachsen mit Ihren Anforderungen – Sie können einfach weitere Knoten hinzufügen.

Clustering und Hochverfügbarkeit

Ein Cluster ist eine Sammlung von einem oder mehreren Knoten (Servern), die zusammen Ihre Daten enthalten und föderierte Indexierungs- und Suchfunktionen über alle Knoten bereitstellen. Elasticsearch-Cluster verwenden primäre und Replikat-Shards, um Failoverfunktionen bereitzustellen, wenn ein Knoten ausfällt. Wenn eine primäre Shard ausfällt, übernimmt ein Replikat ihre Aufgaben.

Informationen zu Clustering und HVAutomatische Knotenwiederherstellung

Wenn ein Knoten den Cluster aus irgendeinem Grund verlässt (absichtlich oder unbeabsichtigt), reagiert der Master-Knoten, indem er den Knoten durch ein Replikat ersetzt und die Shards neu ausbalanciert. Diese Aktionen schützen den Cluster vor Datenverlusten, indem sichergestellt wird, dass jede Shard so bald wie möglich vollständig repliziert wird.

Informationen zur KnotenzuordnungAutomatisches Daten-Rebalancing

Der Master-Knoten in Ihrem Elasticsearch-Cluster entscheidet automatisch, welche Shards zu welchen Knoten zugeordnet werden, und wann Shards zwischen Knoten verschoben werden, um die Balance im Cluster zu erhalten.

Informationen zum automatischen Daten-RebalancingHorizontale Skalierbarkeit

Wenn Ihre Auslastung wächst, skaliert Elasticsearch mit Ihnen. Fügen Sie weitere Daten und Anwendungsfälle hinzu, und wenn die Ressourcen knapp werden, können Sie einfach einen weiteren Knoten zu Ihrem Cluster hinzufügen, um Kapazität und Zuverlässigkeit zu verbessern. Wenn Sie weitere Knoten zu einem Cluster hinzufügen, werden die Replikat-Shards automatisch zugeordnet, um Sie auf die Zukunft vorzubereiten.

Informationen zur horizontalen SkalierbarkeitRack-Awareness

Wenn Sie nutzerdefinierte Knotenattribute als Awareness-Attribute verwenden, kann Elasticsearch Ihre physische Hardwarekonfiguration bei der Zuweisung von Shards berücksichtigen. Wenn Elasticsearch weiß, welche Knoten sich auf demselben physischen Server, im gleichen Rack oder in derselben Zone befinden, können die primäre Shard und ihre Replikate so verteilt werden, dass das Risiko für den Verlust aller Shard-Kopien bei einem Ausfall minimiert wird.

Informationen zu Allocation AwarenessCluster-übergreifende Replikation (CCR)

Mit der Cluster-übergreifenden Replikation (Cross-Cluster Replication, CCR) können Sie Indizes aus Remote-Clustern in einen lokalen Cluster replizieren. Diese Funktion eignet sich für zahlreiche Anwendungsfälle in Produktionsumgebungen.

Informationen zu CCRDisaster recovery: Wenn ein primärer Cluster ausfällt, springt ein sekundärer Cluster als Hot-Backup ein.

Geografische Nähe: Leseanfragen können lokal beantwortet werden, wodurch die Netzwerklatenz reduziert wird.

Rechenzentrumsübergreifende Replikation

Die rechenzentrumsübergreifende Replikation ist schon seit einiger Zeit eine Anforderung für missionskritische Anwendungen in Elasticsearch und wurde bisher zum Teil mit externen Technologien umgesetzt. Mit der rechenzentrumsübergreifenden Replikation in Elasticsearch sind keine zusätzlichen Technologien erforderlich, um Daten über Rechenzentren, Geografien oder Elasticsearch-Cluster hinweg zu replizieren.

Informationen zur rechenzentrumsübergreifenden ReplikationVerwaltung und Betrieb

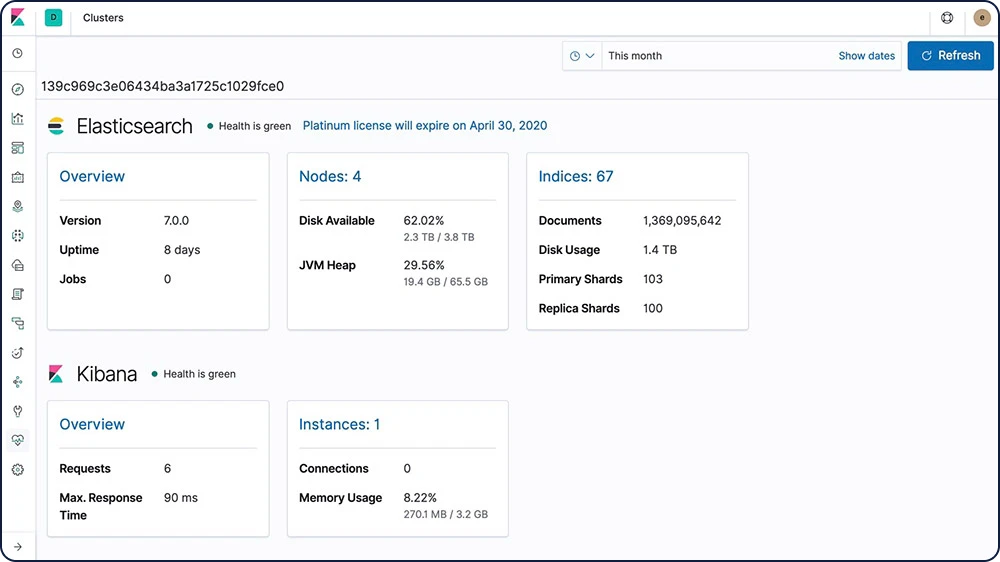

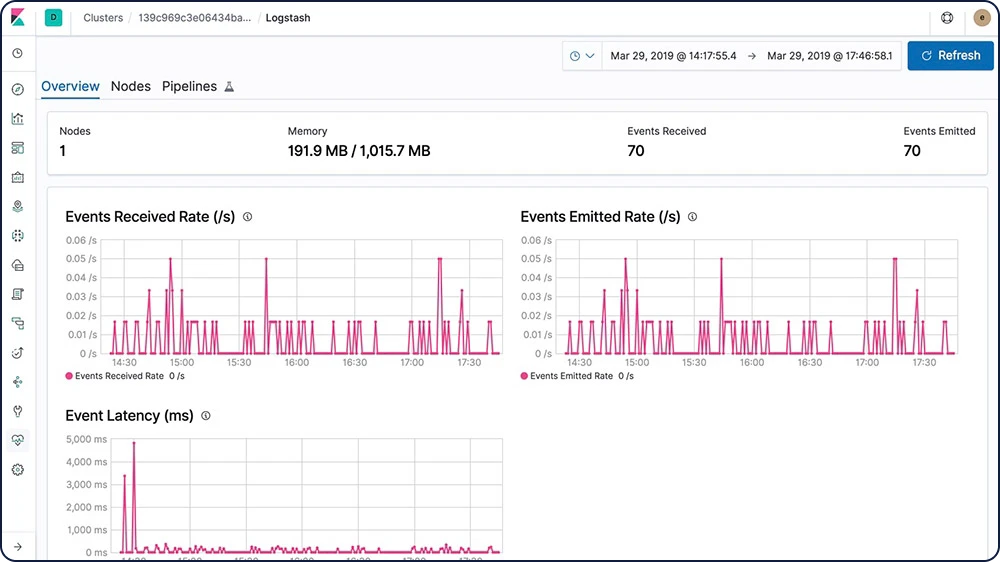

Monitoring

Mit den Monitoring-Features des Elastic Stack wissen Sie stets, wie es um Ihr Elastic Stack-Deployment steht. Behalten Sie die Leistungsdaten im Blick, um sicherzustellen, dass Sie Ihren Stack optimal nutzen.

Full-Stack-Überwachung

Mit den Monitoring-Funktionen des Elastic Stack erhalten Sie Einblicke in den Betrieb von Elasticsearch, Logstash und Kibana. Sämtliche Monitoring-Metriken werden in Elasticsearch gespeichert und können somit mühelos in Kibana visualisiert werden.

Informationen zum Monitoring im Elastic Stack

Multi-Stack-Monitoring

Mit einem zentralisierten Monitoring-Cluster können Sie den Zustand und die Performance mehrerer Elastic Stack-Deployments von einem einzigen Ort aus aufzeichnen, verfolgen und vergleichen.

Informationen zum Multi-Stack-MonitoringKonfigurierbare Aufbewahrungsrichtlinie

Mit dem Elastic Stack können Sie festlegen, wie lange Sie Ihre Überwachungsdaten aufbewahren möchten. Die Standardfrist sind sieben Tage, aber Sie können jeden beliebigen Wert festlegen.

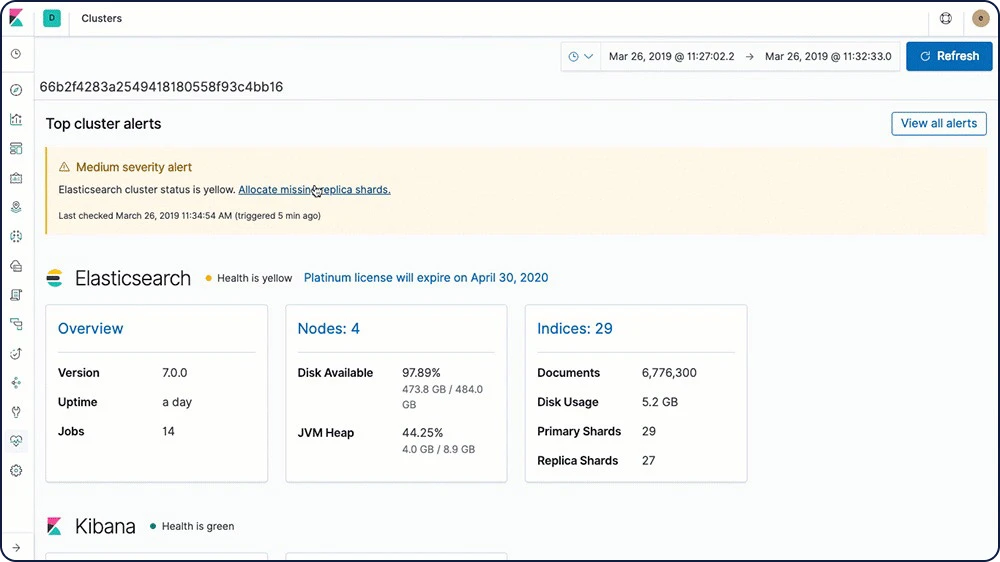

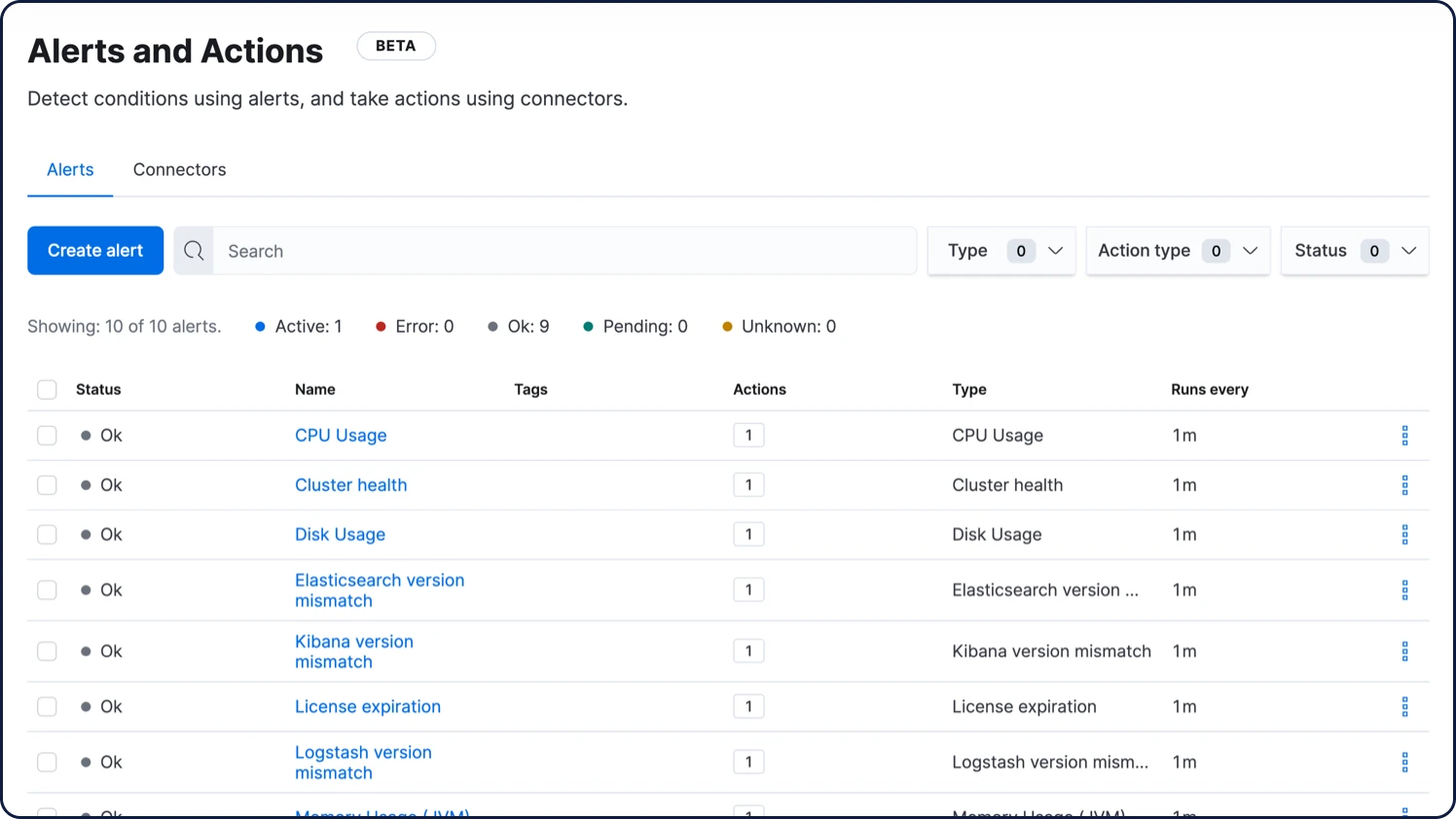

Informationen zu AufbewahrungsrichtlinienAutomatische Warnmeldungen bei Problemen mit dem Stack

Mit den Alerting-Features des Elastic Stack werden Sie automatisch benachrichtigt, wenn sich etwas in Elasticsearch, Kibana und Logstash in Ihrem Cluster verändert, sei es der Zustand von Clustern, der Ablauf von Lizenzen oder andere Metriken.

Informationen zu Elastic Stack-Alerts

Verwaltung und Betrieb

Management

Der Elastic Stack enthält eine Vielzahl an Managementtools, UIs und APIs, mit denen Sie volle Kontrolle über Ihre Daten, Nutzer, Clustervorgänge und mehr erhalten.

Index-Lifecycle-Management

Mit dem Index-Lifecycle-Management (ILM) können die Nutzer:innen Richtlinien definieren und automatisieren, um festzulegen, wie lange ein Index in jeder der vier Phasen verbleibt, und welche Aktionen für den Index in jeder Phase ausgeführt werden. Auf diese Weise lassen sich die Betriebskosten besser planen, da die Daten in verschiedenen Ressourcenebenen abgelegt werden können.

Informationen zu ILM„Heiß“: Daten werden aktiv aktualisiert und abgefragt

„Warm“: Daten werden nicht mehr aktualisiert, aber noch abgefragt

„Kalt“/„Eingefroren“: Daten werden nicht mehr aktualisiert und nur selten abgefragt (Suche ist möglich, sie ist aber langsamer)

Löschen: Wird nicht mehr benötigt

Daten-Tiers

Daten-Tiers bieten eine formalisierte Möglichkeit, Daten auf „heiße“, „warme“ und „kalte“ Knoten aufzuteilen. Dabei kommt ein Knotenrollenattribut zum Einsatz, das automatisch die Index-Lifecycle-Management-Richtlinie für Ihre Knoten definiert. Durch die Zuweisung von „Heiß“-, „Warm“- und „Kalt“-Rollen zu Knoten lässt sich der Prozess der Umschichtung von Daten von teurem Speicherplatz mit hoher Performance auf Speicherplatzoptionen mit geringeren Kosten und geringerer Performance vereinfachen und automatisieren, ohne dass darunter die Möglichkeit leidet, Daten abzufragen und Erkenntnisse zu gewinnen.

Informationen zu Daten-Tiers- „Heiß“: Daten werden aktiv aktualisiert und häufig abgefragt und dazu auf der Instanz mit der besten Performance gespeichert

„Warm“: Daten werden seltener abgefragt und daher auf Instanzen mit einer geringeren Performance gespeichert

„Kalt“: Daten werden nur noch gelesen und selten abgefragt und daher in durchsuchbaren Snapshots gespeichert, was deutliche Kosteneinsparungen ermöglicht, ohne die Performance zu beeinträchtigen

Snapshot und Wiederherstellung

Ein Snapshot ist eine Sicherung aus einem aktiven Elasticsearch-Cluster. Snapshots können entweder für einzelne Indizes oder für ein gesamtes Cluster erstellt und in einem Repository in einem freigegebenen Dateisystem gespeichert werden. Außerdem sind Plugins verfügbar, mit denen Sie Remote-Repositorys unterstützen können.

Informationen zu Snapshots und WiederherstellungDurchsuchbare Snapshots

Mit durchsuchbaren Snapshots erhalten Sie die Möglichkeit, Daten in Ihren Snapshots direkt abzufragen – in einem Bruchteil der Zeit, die eine herkömmliche Wiederherstellung von Daten aus einem Snapshot benötigen würde. Möglich gemacht wird dies dadurch, dass nur die Teile des jeweiligen Snapshot-Index gelesen werden, die für die Erfüllung der Anfrage notwendig sind. Zusammen mit der Daten-Tier für „kalte“ Daten können durchsuchbare Snapshots Ihre Datenspeicherkosten deutlich reduzieren, da die Replikat-Shards unter vollständiger Erhaltung der Durchsuchbarkeit in Objektspeichersystemen wie Amazon S3, Azure Storage oder Google Cloud Storage gesichert werden.

Informationen zu durchsuchbaren SnapshotsSnapshot-Lifecycle-Management

Als im Hintergrund laufende Snapshot-Manager bieten API-Administratoren für Snapshot-Lifecycle-Management(SLM) die Möglichkeit zu definieren, in welcher Abfolge die Snapshots eines Elasticsearch-Clusters angelegt werden sollen. Dank einer dedizierten Benutzeroberfläche können Nutzer:innen mit SLM Aufbewahrungseinstellungen für SLM-Richtlinien konfigurieren und Snapshots automatisch anlegen und löschen lassen sowie die Häufigkeit der Snapshot-Erstellung einrichten. So kann sichergestellt werden, dass Cluster-Backups ausreichend häufig erstellt werden, um die Einhaltung der Kunden-SLAs zu gewährleisten.

Informationen zu SLMSnapshot-basierte Peer-Wiederherstellungen

Mit dieser Funktion kann Elasticsearch Replikate wiederherstellen und primäre Shards aus einem aktuellen Snapshot verschieben, wenn Daten verfügbar sind. So werden die Betriebskosten für Cluster reduziert, die in einer Umgebung ausgeführt werden, in der die Kosten für die Übertragung von Daten zwischen Knoten höher sind als die Kosten für die Wiederherstellung von Daten auf der Basis eines Snapshots.

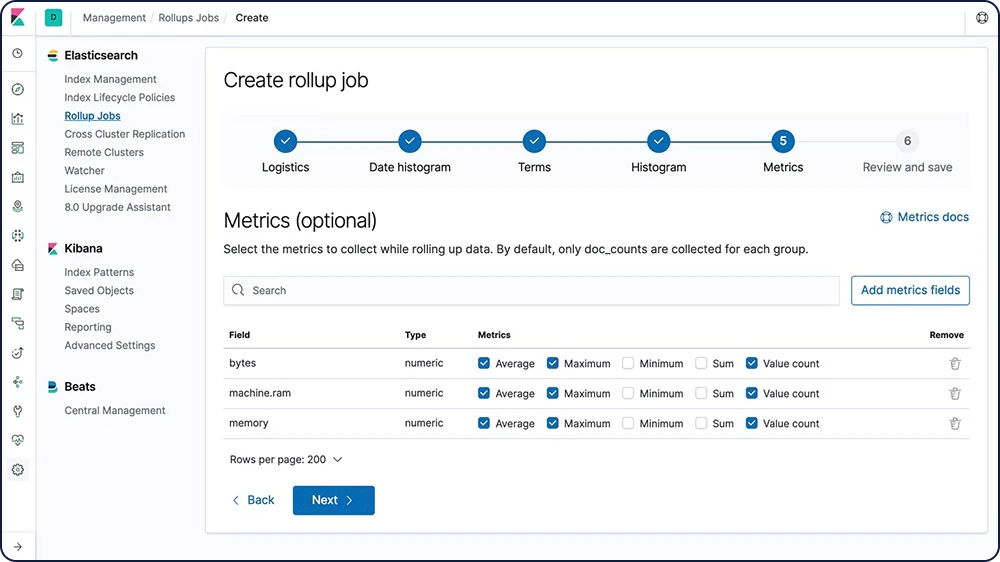

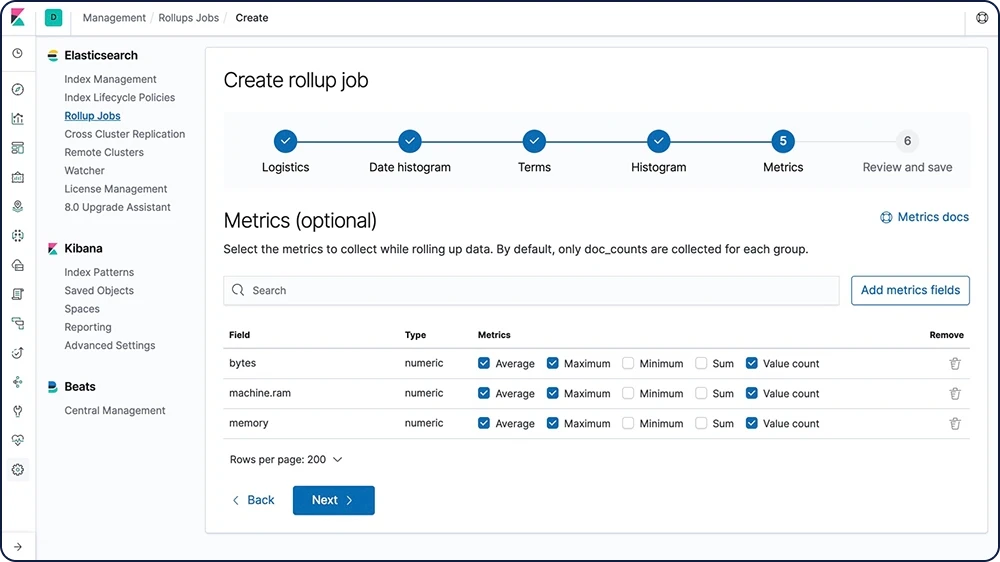

Informationen zu Snapshot-basierten Peer-WiederherstellungenDaten-Rollups

Verlaufsdaten sind oft extrem hilfreich für die Analyse, werden allerdings oft nicht aufbewahrt, weil es kostspielig ist, riesige Datenmengen zu archivieren. Die Aufbewahrungsfristen werden daher eher aus finanziellen Gründen begrenzt als durch die Nützlichkeit umfassender Verlaufsdaten. Mit der Rollup-Funktion können Sie Verlaufsdaten zusammenfassen und speichern, um sie weiterhin für Analysen zu können, jedoch zu einem Bruchteil der Speicherungskosten für Rohdaten.

Informationen zu Rollups

Datenstreams

Datenstreams sind eine bequeme und skalierbare Möglichkeit, kontinuierlich generierte Zeitreihendaten zu ingestieren, zu suchen und zu verwalten.

Mehr über Datenstreams erfahrenCLI-Tools

Elasticsearch stellt eine Vielzahl von Tools bereit, mit denen Sie in der Befehlszeile Sicherheitsfunktionen konfigurieren und andere Aufgaben ausführen können.

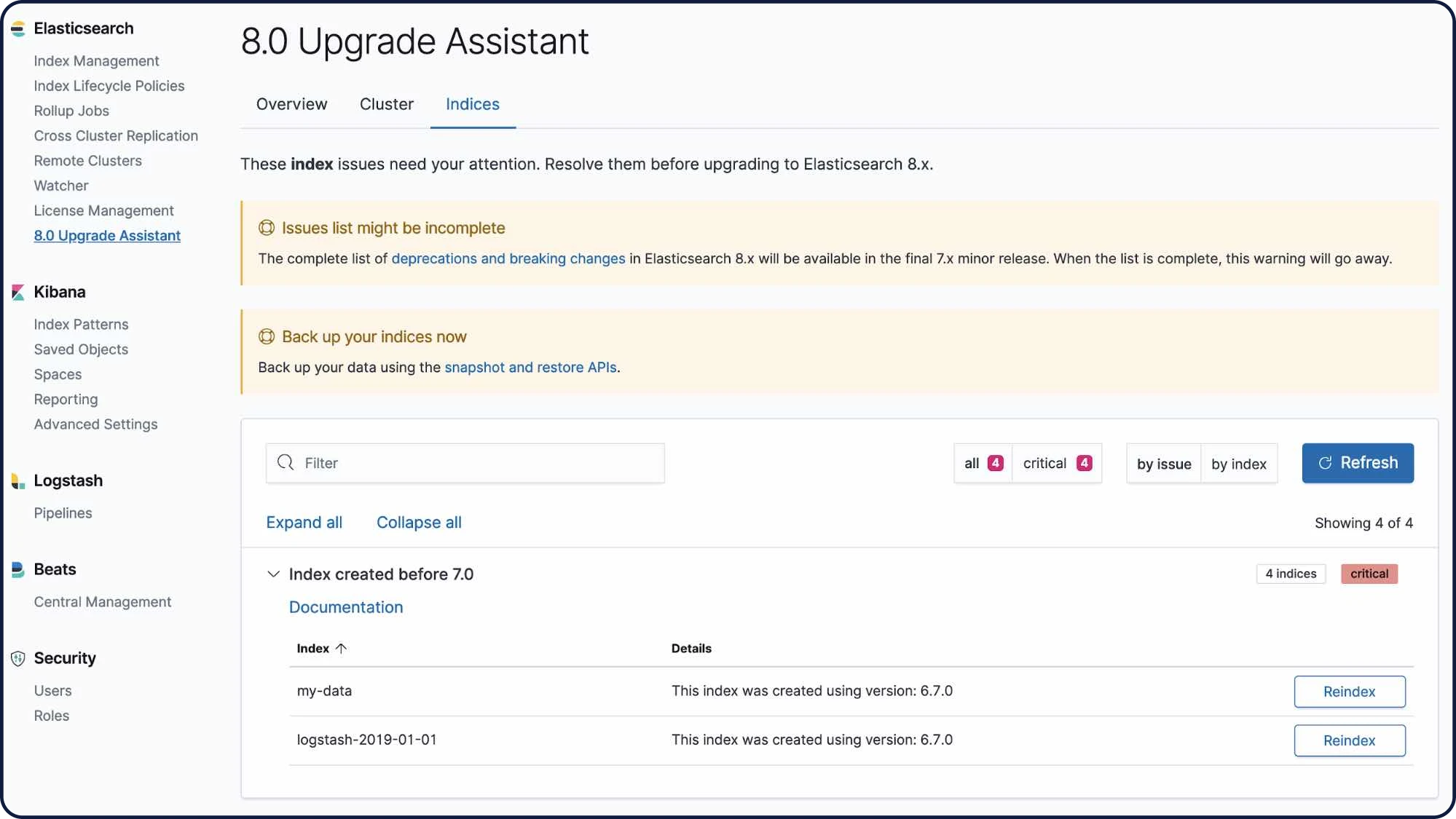

Informationen zu den verschiedenen CLI-ToolsUpgrade-Assistant-Benutzeroberfläche

Mit der Upgrade-Assistant-Benutzeroberfläche können Sie Ihr Upgrade auf die neueste Version von Elastic Stack vorbereiten. In der Benutzeroberfläche identifiziert der Assistent die veralteten Einstellungen in Ihrem Cluster und Ihren Indizes und unterstützt Sie beim Beheben von Problemen, einschließlich der erneuten Erstellung von Indizes.

Informationen zum Upgrade Assistant

Upgrade Assistant-API

Mit der Upgrade Assistant-API können Sie den Upgradestatus Ihres Elasticsearch-Clusters überprüfen und Indizes neu indizieren, die in der vorherigen Hauptversion erstellt wurden. Der Assistent hilft Ihnen dabei, Ihre Umgebung auf die nächste Hauptversion von Elasticsearch vorzubereiten.

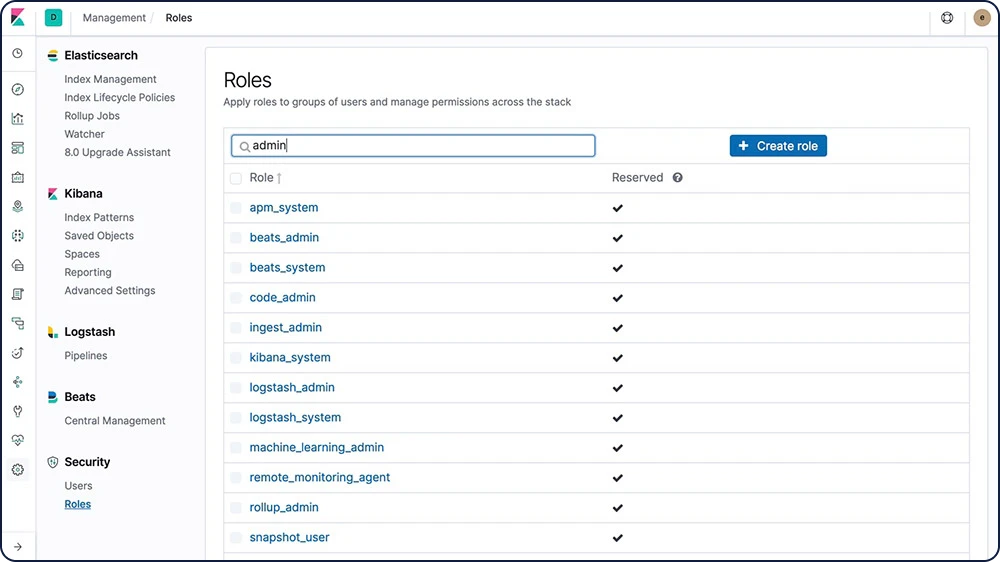

Weitere Infos zur Upgrade Assistant-APINutzer- und Rollenverwaltung

Sie können Nutzer:innen und Rollen mit der API oder mit den Managementfunktionen in Kibana erstellen und verwalten.

Weitere Infos zur Nutzer- und Rollenverwaltung

Transformationen

Transformationen sind zweidimensionale Datenstrukturen in Tabellenform, die indizierte Daten „leichter verdaulich“ machen. Transformationen führen Aggregationen aus, die Ihre Daten in einen neuen, Entity-zentrierten Index überführen. Durch Transformieren und Zusammenfassen Ihrer Daten können Sie sie auf unterschiedliche Weise visualisieren und analysieren und sie auch als Quelle für andere Machine-Learning-Analysen bereitstellen.

Informationen zu TransformationenVerwaltung und Betrieb

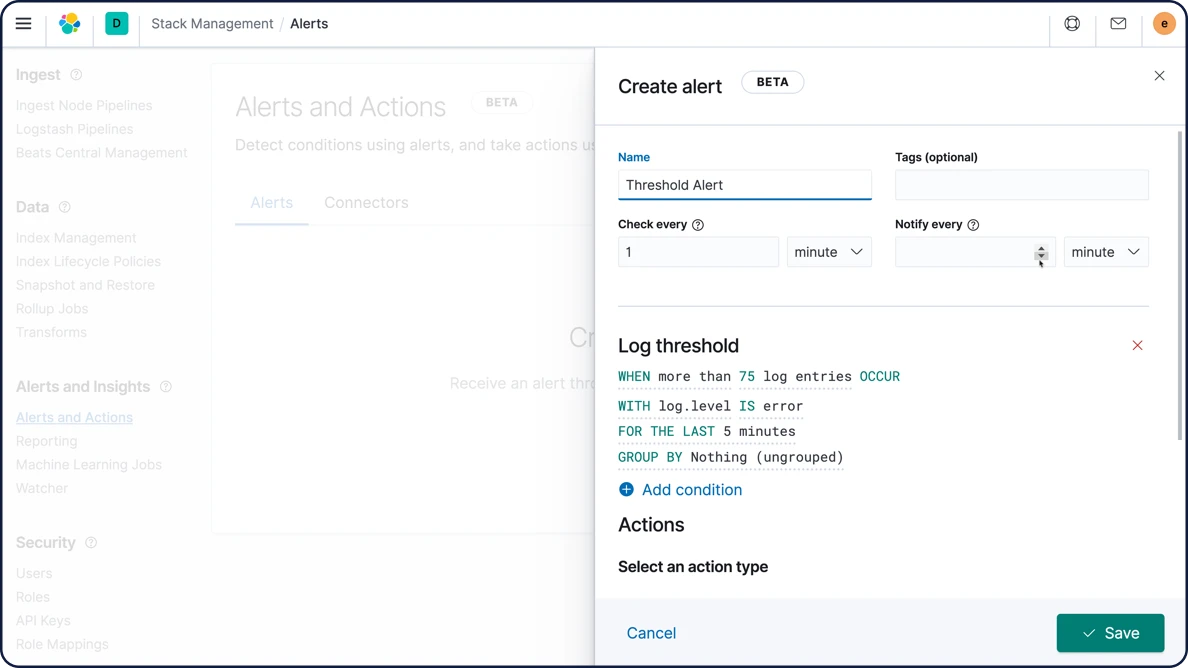

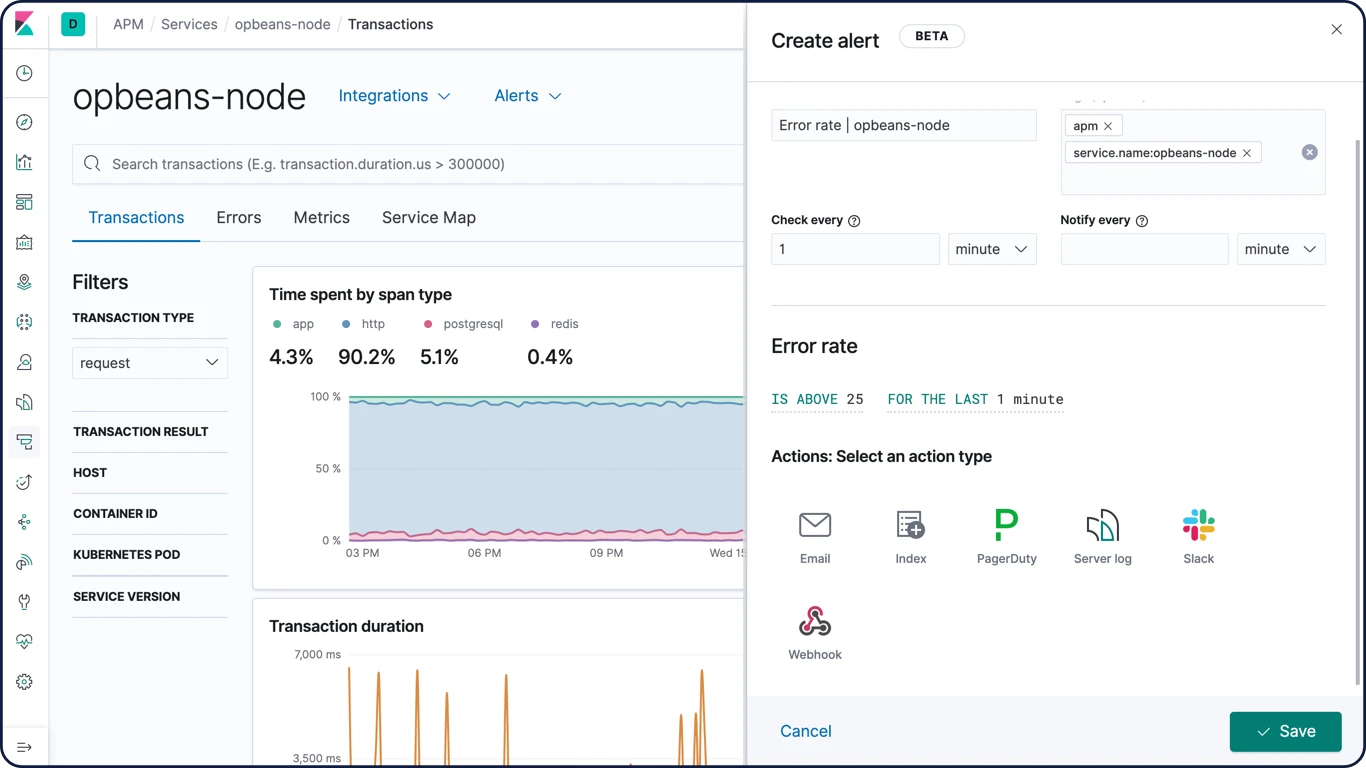

Alerting

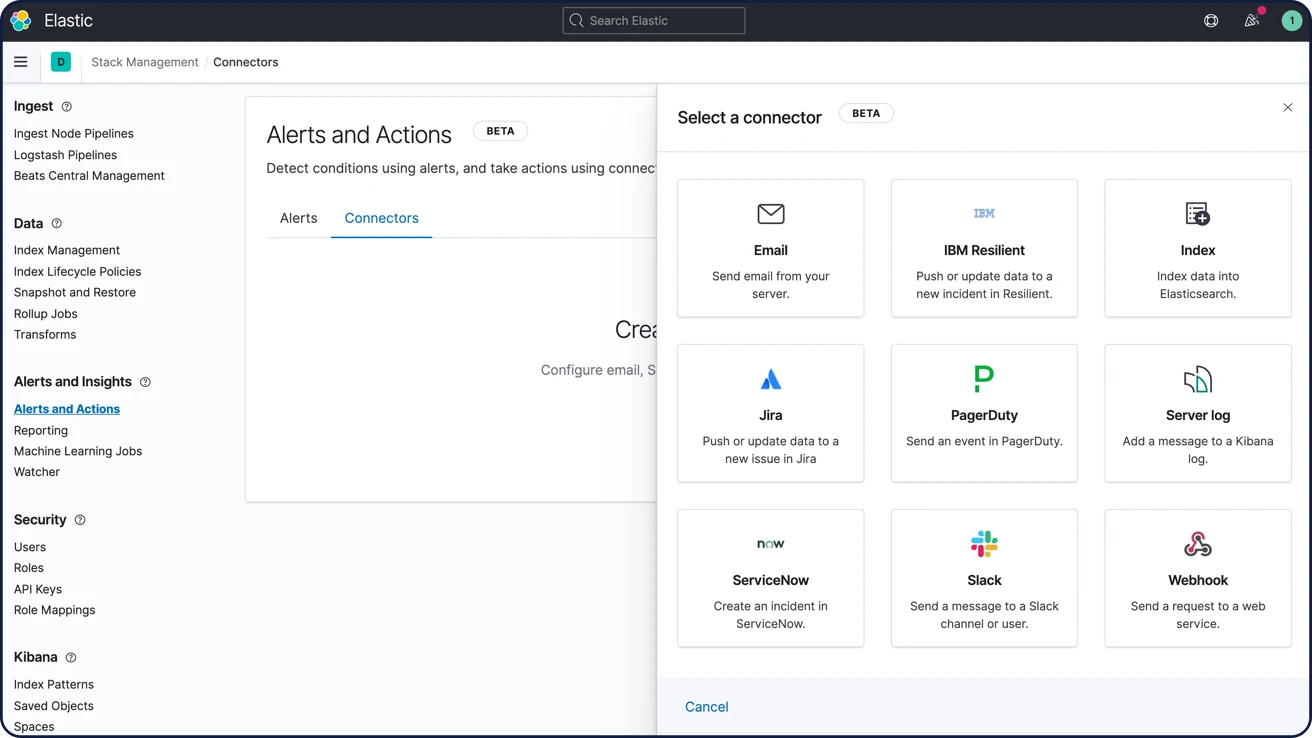

Mit unseren Alerting-Features erhalten Sie den vollen Leistungsumfang der Elasticsearch-Abfragesprache, um relevante Änderungen in Ihren Daten identifizieren zu können. Mit anderen Worten: Für alles, was Sie in Elasticsearch abfragen können, kann auch ein Alert eingerichtet werden.

Hochverfügbares und skalierbares Alerting

Es gibt gute Gründe, warum Unternehmen jeder Größe für Ihr Alerting auf den Elastic Stack setzen. Daten aus beliebigen Quellen und in beliebigen Formaten werden zuverlässig und sicher ingestiert, und Analysten können wichtige Daten in Echtzeit durchsuchen, analysieren und visualisieren, jeweils mit benutzerdefiniertem und zuverlässigem Alerting.

Informationen zum AlertingBenachrichtigungen per E‑Mail, Webhooks, IBM Resilient, Jira, Microsoft Teams, PagerDuty, ServiceNow, Slack und xMatters

Sie können Alerts mit vorkonfigurierten Integrationen für E‑Mail, IBM Resilient, Jira, Microsoft Teams, PagerDuty, ServiceNow, Slack und xMatters verknüpfen. Mittels Webhook-Ausgabe sind auch Integrationen für jedes andere Drittanbietersystem möglich.

Informationen zu Benachrichtigungsoptionen

Warn-Benutzeroberfläche

Übernehmen Sie die Kontrolle über Ihre Alerts, indem Sie sie über eine zentrale Benutzeroberfläche einsehen, erstellen und verwalten. Lassen Sie sich in Echtzeit informieren, welche Alerts aktiv sind und welche Maßnahmen ergriffen wurden.

Informationen zum Konfigurieren von Alerts in Kibana

Alerting-Unterdrückung und Rauschreduzierung

Snooze-Alerting-Regeln, um Benachrichtigungen und Aktionen für eine benutzerdefinierte Dauer zu unterdrücken. Sie werden nie eine Aktion verpassen, weil Sie vergessen haben, eine Regel zu aktivieren, während Sie unerwartet aufgetretene Probleme oder bekannte Betriebsausfallzeiten behandeln.

Informationen zur Alerting-Unterdrückung und RauschreduzierungAlerts zur Schwellenwertsuche mit Discover

Die Schwellenwertregelsuche mit Discover basiert auf Elasticsearch-Abfragen – sie analysiert in einem bestimmten Zeitintervall, ob bei Dokumenten mit den angegebenen Kriterien ein Schwellenwert erreicht wurde, und löst gegebenenfalls einen Alert aus. Die Nutzer:innen können eine Aktion erstellen und zuweisen, wenn eine Benachrichtigung ausgegeben werden soll, oder festlegen, dass automatisch ein Incident erstellt wird.

Informationen zu Alerts zur Schwellenwertsuche mit DiscoverVerwaltung und Betrieb

Stack-Security

Die Security-Features des Elastic Stack sorgen dafür, dass nur die richtigen Personen Zugriff erhalten. Mit diesen Funktionen können IT-, Operations- und Entwicklungsteams Nutzer:innen verwalten und Angriffe abwehren – und Führungskräfte und Kunden haben die Gewissheit, dass die im Elastic Stack gespeicherten Daten sicher und geschützt sind.

Sichere Einstellungen

Es gibt Einstellungen, die besonders sicherheitsrelevant sind und bei denen es nicht ausreicht, die Werte allein über Dateisystemberechtigungen zu schützen. In diesen Fällen bieten die Elastic Stack-Komponenten Schlüsselspeicher, die dabei helfen, den unerlaubten Zugriff auf sicherheitsrelevante Cluster-Einstellungen zu verhindern. Für zusätzliche Sicherheit können die Schlüsselspeicher für Elasticsearch und Logstash optional mit einem Passwort geschützt werden.

Informationen zu sicheren EinstellungenVerschlüsselte Kommunikationen

Sie können netzwerkbasierte Angriffe auf die Daten in Elasticsearch-Knoten abwehren, indem Sie den Datenverkehr mit SSL/TLS verschlüsseln, Zertifikate für die Knotenauthentifizierung verwenden, usw.

Informationen zur verschlüsselten KommunikationUnterstützung für Verschlüsselung inaktiver Daten

Der Elastic Stack implementiert zwar keine Verschlüsselung für ruhende Daten, aber wir empfehlen trotzdem, eine Verschlüsselung auf Laufwerksebene für alle Hostcomputer zu konfigurieren. Auch die in den Snapshot-Zielen gespeicherten inaktiven Daten müssen verschlüsselt werden.

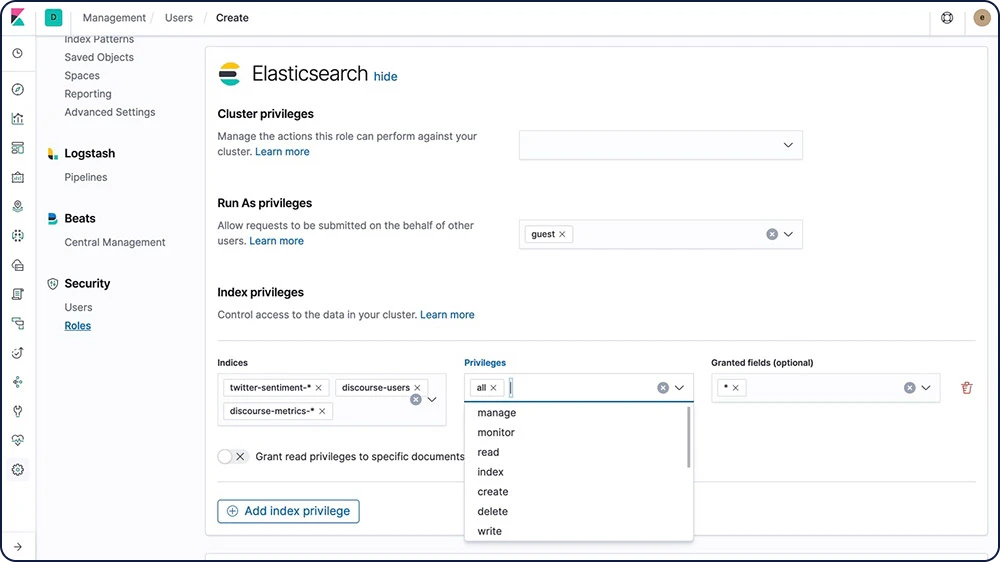

Rollenbasierte Zugriffssteuerung (RBAC)

Mit der rollenbasierten Zugriffssteuerung (RBAC) können Sie Nutzer:innen autorisieren, indem Sie Privilegien zu Rollen und Rollen zu Nutzer:innen oder Gruppen zuweisen.

Informationen zur rollenbasierten Zugriffssteuerung (RBAC)

Attributbasierte Zugriffssteuerung (ABAC)

Die Sicherheitsfunktionen des Elastic Stack stellen außerdem einen Mechanismus für die attributbasierte Zugriffssteuerung bereit, mit dem Sie Attribute verwenden können, um den Zugriff auf Dokumente in Suchabfragen und Aggregationen einzuschränken. Außerdem können Sie eine Zugriffsrichtlinie in einer Rollendefinition implementieren, um festzulegen, dass die Nutzer:innen ein Dokument nur lesen dürfen, wenn sie alle erforderlichen Attribute haben.

Informationen zur attributbasierten Zugriffssteuerung (ABAC)Steuerung des anonymen Zugriffs (für öffentliches Teilen)

Sie können jetzt spezialisierte Links erstellen, mit denen jeder auch ohne Abfrage von Anmeldeinformationen auf ein Asset zugreifen kann – ob Karte, Dashboard oder praktisch irgendein in Kibana gespeichertes Objekt.

Informationen zum anonymen ZugriffSicherheit auf Feld- und Dokumentenebene

Mit der Sicherheit auf Feldebene können Sie einschränken, auf welche Felder die Nutzer:innen Lesezugriff haben. Insbesondere können Sie einschränken, welche Felder für dokumentbasierte Lese-APIs verfügbar sind.

Informationen zur Sicherheit auf FeldebeneMit der Sicherheit auf Dokumentebene können Sie einschränken, auf welche Dokumente die Nutzer:innen Lesezugriff haben. Insbesondere können Sie einschränken, welche Dokumente für dokumentbasierte Lese-APIs verfügbar sind.

Informationen zur Sicherheit auf DokumentebeneAudit-Logging

Aktivieren Sie die Auditing-Funktionen, um sicherheitsrelevante Ereignisse wie Authentifizierungsfehler und abgelehnte Verbindungen im Blick zu behalten. Loggen Sie diese Ereignisse, um Ihren Cluster auf verdächtige Aktivitäten zu überwachen und bei einem Angriff Beweise sammeln zu können.

Informationen zum Audit-LoggingIP-Filterung

Sie können die IP-Filterung auf Anwendungs-Clients, Knoten-Clients oder Transport-Clients sowie auf andere Knoten anwenden, die versuchen, dem Cluster beizutreten. Wenn die IP-Adresse eines Knotens in der Negativliste enthalten ist, erlauben die Elasticsearch-Sicherheitsfunktionen zwar eine Verbindung mit Elasticsearch, aber diese wird sofort geschlossen und es werden keine Anfragen verarbeitet.

IP-Adresse oder -Bereich

xpack.security.transport.filter.allow: "192.168.0.1" xpack.security.transport.filter.deny: "192.168.0.0/24"

Whitelist

xpack.security.transport.filter.allow: [ "192.168.0.1", "192.168.0.2", "192.168.0.3", "192.168.0.4" ] xpack.security.transport.filter.deny: _all

IPv6

xpack.security.transport.filter.allow: "2001:0db8:1234::/48" xpack.security.transport.filter.deny: "1234:0db8:85a3:0000:0000:8a2e:0370:7334"

Hostname

xpack.security.transport.filter.allow: localhost xpack.security.transport.filter.deny: '*.google.com'Informationen zur IP-Filterung

Security-Realms

Die Sicherheitsfunktionen des Elastic Stack authentifizieren Nutzer:innen mithilfe von Realms und einem oder mehreren Token-basierten Authentifizierungsdiensten. Realms werden verwendet, um Nutzer:innen auf Basis von Authentifizierungs-Tokens aufzulösen und zu authentifizieren. Die Sicherheitsfunktionen stellen eine Reihe von integrierten Realms bereit.

Informationen zu Security-RealmsSingle Sign-On (SSO)

Der Elastic Stack unterstützt Single Sign-on (SSO) in Kibana mit SAML und verwendet Elasticsearch als Backend-Dienst. Mit der SAML-Authentifizierung können sich die Nutzer:innen mit einem externen Identitätsanbieter wie etwa Okta oder Auth0 bei Kibana anmelden.

Informationen zu SSOIntegration für Drittanbieter-Sicherheitssysteme

Falls Sie ein Authentifizierungssystem verwenden, das nicht mit den vorkonfigurierten Sicherheitsfunktionen des Elastic Stack unterstützt wird, können Sie einen nutzerdefinierten Realm für die Authentifizierung Ihrer Nutzer:innen erstellen.

Informationen zu externen SicherheitsintegrationenFIPS 140-2-Modus

Elasticsearch bietet einen FIPS 140-2-kompatiblen Modus, der in einer entsprechenden JVM ausgeführt werden kann. Die Einhaltung der Verfahrensstandards wird durch von FIPS genehmigte und von NIST empfohlene Verschlüsselungsalgorithmen sichergestellt.

Informationen zur FIPS-140‑2-KompatibilitätSection 508

Wenn Ihr Elastic Stack-Deployment die Compliance-Anforderungen von Section 508 erfüllen muss, dann sind Sie mit unseren Sicherheitsfunktionen auf der sicheren Seite.

Informationen zu Compliance-AnforderungenStandards (GDPR)

Es besteht eine hohe Wahrscheinlichkeit, dass Ihre Daten nach den DSGVO-Richtlinien als personenbezogene Daten klassifiziert sind. Erfahren Sie, wie Sie die Funktionen des Elastic Stack – von der rollenbasierten Zugriffssteuerung bis hin zur Datenverschlüsselung – nutzen können, damit Ihre Elasticsearch-Daten die Datenschutz- und Datenverarbeitungsanforderungen der DSGVO erfüllen.

Verwaltung und Betrieb

Bereitstellung

Öffentliche Cloud, private Cloud oder irgendwo dazwischen – wir machen Ihnen die Nutzung und Verwaltung des Elastic Stack einfach.

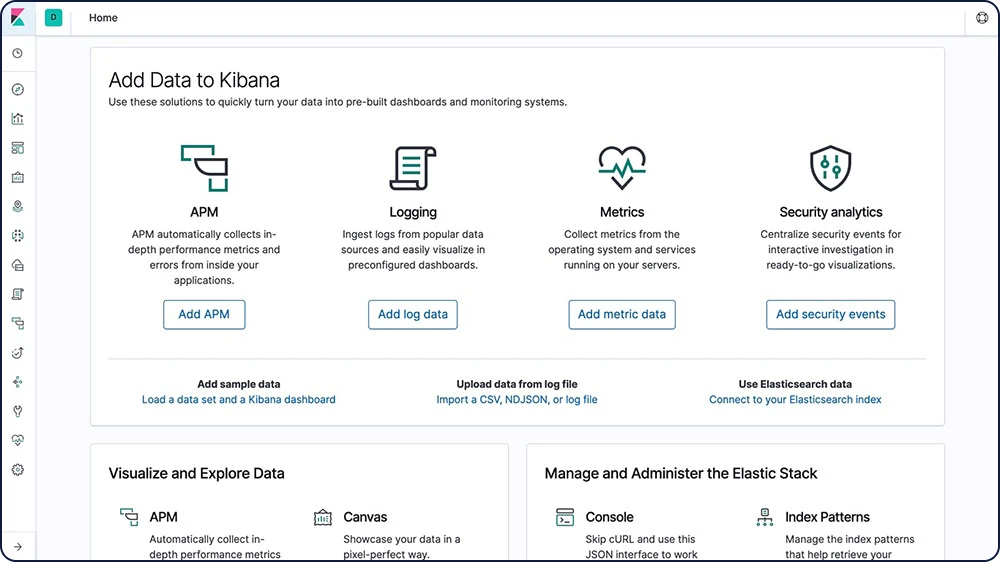

Herunterladen und installieren

Der Einstieg war noch nie so einfach. Sie können Elasticsearch und Kibana als Archiv oder mit einem Paket-Manager herunterladen und installieren. Fangen Sie im Handumdrehen damit an, Daten zu indexieren, zu analysieren und zu visualisieren. Mit der Standarddistribution können Sie außerdem in einem kostenlosen 30-tägigen Test „Platinum“-Funktionen wie Machine Learning, Sicherheit, Graph-Analytics und vieles mehr ausprobieren.

Elastic Stack herunterladenElastic Cloud

Elastic Cloud ist unsere wachsende Familie von SaaS-Angeboten, die Ihnen beim Bereitstellen, Verwalten und Skalieren von Elastic-Produkten und -Lösungen helfen. Ob eine benutzerfreundliche gehostete und verwaltete Elasticsearch-Benutzeroberfläche oder leistungsfähige Suchlösungen – Elastic Cloud ist das Sprungbrett für die einfache Nutzung der Vorteile von Elastic. Testen Sie unsere Elastic Cloud-Produkte 14 Tage lang kostenlos – keine Kreditkarte erforderlich.

Erste Schritte mit Elastic CloudElastic Cloud Enterprise

Mit Elastic Cloud Enterprise (ECE) können Sie Elasticsearch und Kibana in beliebiger Größe und auf jeder Infrastruktur bereitstellen und in einer einzigen Konsole verwalten. Sie können frei auswählen, wo Sie Elasticsearch und Kibana ausführen möchten: auf physischer Hardware, in einer virtuellen Umgebung, in einer privaten Cloud, im privaten Bereich innerhalb einer öffentlichen Cloud oder einfach nur in einer öffentlichen Cloud (zum Beispiel Google, Azure, AWS). Wir unterstützen alle Optionen.

Probieren Sie ECE 30 Tage lang kostenlos ausElastic Cloud auf Kubernetes

Elastic Cloud auf Kubernetes basiert auf dem Kubernetes-Operator-Muster und erweitert die grundlegenden Orchestrierungsfunktionen von Kubernetes, um die Einrichtung und die Verwaltung von Elasticsearch und Kibana auf Kubernetes zu unterstützen. Mit Elastic Cloud auf Kubernetes können Sie sämtliche Prozesse rund um die Bereitstellung, Aktualisierung, Snapshot-Erstellung, Skalierung, Hochverfügbarkeit, Sicherheit und mehr für die Ausführung von Elasticsearch in Kubernetes vereinfachen.

Stellen Sie Elastic Cloud auf Kubernetes bereitHelm Charts

Mit den offiziellen Helm Charts für Elasticsearch und Kibana steht Ihr Deployment innerhalb weniger Minuten.

Weitere Infos zu den offiziellen Elastic Helm ChartsDocker-Containerisierung

Mit den offiziellen Containern aus dem Docker Hub können Sie Elasticsearch und Kibana mühelos in Docker ausführen.

Elastic Stack in Docker ausführenVerwaltung und Betrieb

Clients

Mit dem Elastic Stack können Sie selbst bestimmen, wie Sie mit Ihren Daten arbeiten möchten. Mit den RESTful APIs, Sprach-Clients, robuster DSL und mehr (sogar SQL) sind wir flexibel genug, um Sie in jeder Lage zu unterstützen.

REST-API

Elasticsearch stellt eine umfangreiche und leistungsstarke JSON-basierte REST-API bereit, die Sie für die Interaktion mit Ihrem Cluster verwenden können.

Informationen zur REST-APIÜberprüfen Sie Integrität, Status und Statistiken Ihrer Cluster, Knoten und Indizes.

Verwalten Sie Ihre Cluster, Knoten, Indexdaten und Metadaten.

Führen Sie CRUD(Create, Read, Update, and Delete)- und Suchvorgänge für Ihre Indizes aus.

Nutzen Sie erweiterte Suchfunktionen wie Paginierung, Sortierung, Filter, Skripting, Aggregationen und vieles mehr.

Sprachclients

Elasticsearch verwendet standardmäßige RESTful APIs und JSON. Außerdem entwickeln und pflegen wir Clients in vielen anderen Sprachen, wie Java, Python, .NET, SQL und PHP. Dazu ist unsere Community fleißig dabei, weitere Clients zu entwickeln. Sie sind nutzerfreundlich, intuitiv und setzen – ganz im Stil von Elasticsearch – Ihrem Ideenreichtum keine Grenzen.

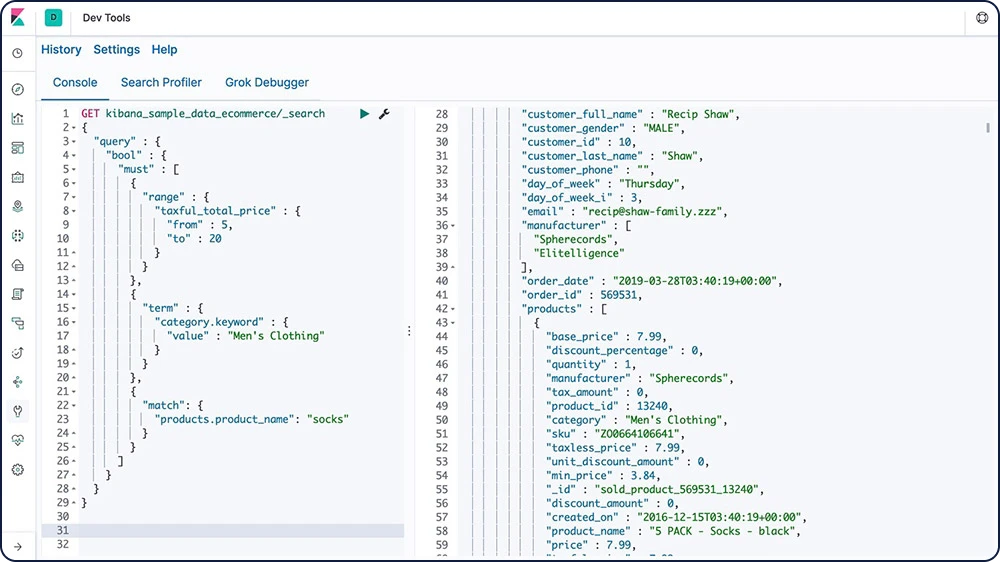

Entdecken Sie die verfügbaren SprachclientsConsole

Console ist eines der Entwickler-Tools in Kibana. Hier können Sie Anfragen zusammenstellen, mit einer cURL-ähnlichen Syntax an Elasticsearch senden und die Antworten auf Ihre Anfragen anzeigen.

Informationen zu Console

Elasticsearch DSL

Elasticsearch stellt eine komplette Abfrage-DSL (domain-specific language, domänenspezifische Sprache) auf JSON-Basis bereit, mit der Sie Abfragen definieren können. Die Abfrage-DSL stellt leistungsstarke Suchoptionen für die Volltextsuche bereit, inklusive Begriffs- und Satzabgleich, Fuzziness, Platzhalter, regulärer Ausdrücke, verschachtelter Abfragen, Geo-Abfragen und mehr.

Informationen zu Elasticsearch DSLGET /de/_search

{

"query": {

"match" : {

"message" : {

"query" : "this is a test",

"operator" : "and"

}

}

}

}

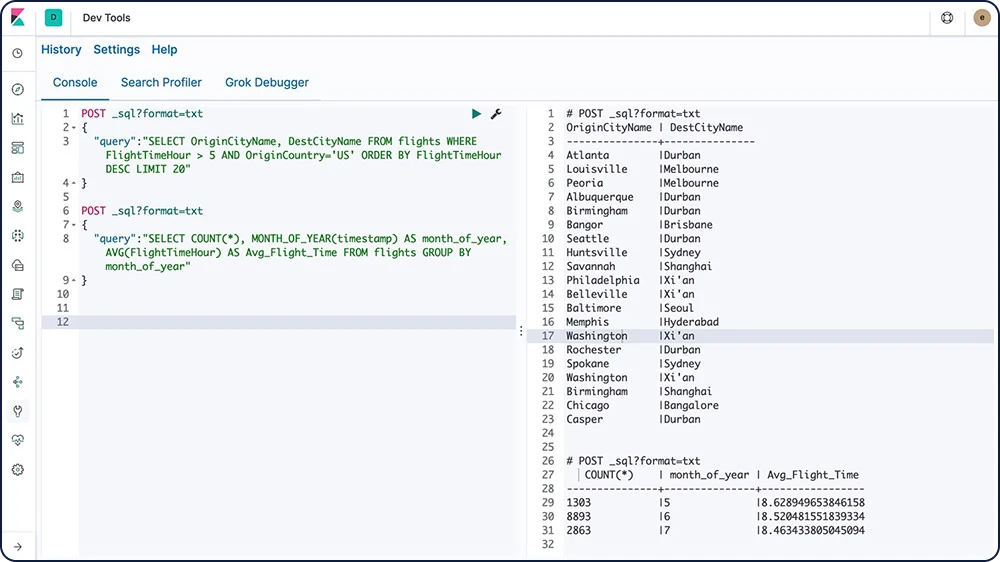

Elasticsearch SQL

Elasticsearch SQL ist ein Feature, mit dem Sie SQL-ähnliche Abfragen in Echtzeit an Elasticsearch stellen können. Egal ob über die REST-Schnittstelle, in der Befehlszeile oder per JDBC, jeder Client kann SQL verwenden, um Daten nativ in Elasticsearch zu suchen und zu aggregieren.

Informationen zu Elasticsearch SQL

Event Query Language (EQL)

EQL (Event Query Language) wurde speziell für die Abfrage spezifischer Ereignisabfolgen entwickelt und ist damit ideal für Security-Analytics-Anwendungsfälle geeignet.

Informationen zu EQLJDBC-Client

Der Elasticsearch SQL JDBC ist ein leistungsstarker JDBC-Treiber für Elasticsearch mit vollem Funktionsumfang. Dieser Type-4-Treiber ist ein plattformunabhängiger, eigenständiger, reiner Java-Treiber, der sich direkt mit der Datenbank verbindet und JDBC-Aufrufe in Elasticsearch SQL konvertiert.

Informationen zum JDBC-ClientODBC-Client

Der Elasticsearch SQL ODBC-Treiber ist ein 3.80 ODBC-Treiber für Elasticsearch mit vollem Funktionsumfang. Dieser Core-Treiber stellt alle Funktionen bereit, die in der Elasticsearch SQL ODBC API verfügbar sind, und wandelt ODBC-Aufrufe in Elasticsearch SQL um.

Informationen zum ODBC-ClientTableau-Connector für Elasticsearch

Mit dem Tableau-Connector für Elasticsearch können Nutzer:innen von Tableau Desktop und Tableau Server einfach und schnell auf Daten in Elasticsearch zugreifen.

Tableau-Connector herunterladenIngestieren und Anreichern

Ingestieren und Anreichern

Datenquellen

Egal welche Art von Daten Sie verwenden, Beats eignen sich hervorragend für deren Erfassung. Sie werden auf Ihren Servern oder in Ihren Containern installiert oder als Funktionen bereitgestellt und zentralisieren Ihre Daten in Elasticsearch. Wenn Sie zusätzliche Verarbeitungsleistung benötigen, können Beats Ihre Daten auch zur Umwandlung und zum Parsing an Logstash senden.

Betriebssysteme

Mit Auditbeat können Sie Ihre Linux-Audit-Framework-Daten erfassen und die Integrität Ihrer Dateien überwachen. Die entsprechenden Ereignisse werden in Echtzeit zur weiteren Analyse an den Rest des Elastic Stack gesendet.

Mit Winlogbeat behalten Sie den Überblick über Ihre Windows-basierte Infrastruktur. Winlogbeat streamt Windows-Ereignisprotokolle in Echtzeit und ressourcenschonend an Elasticsearch und Logstash.

Informationen zu WinlogbeatWebserver und Proxys

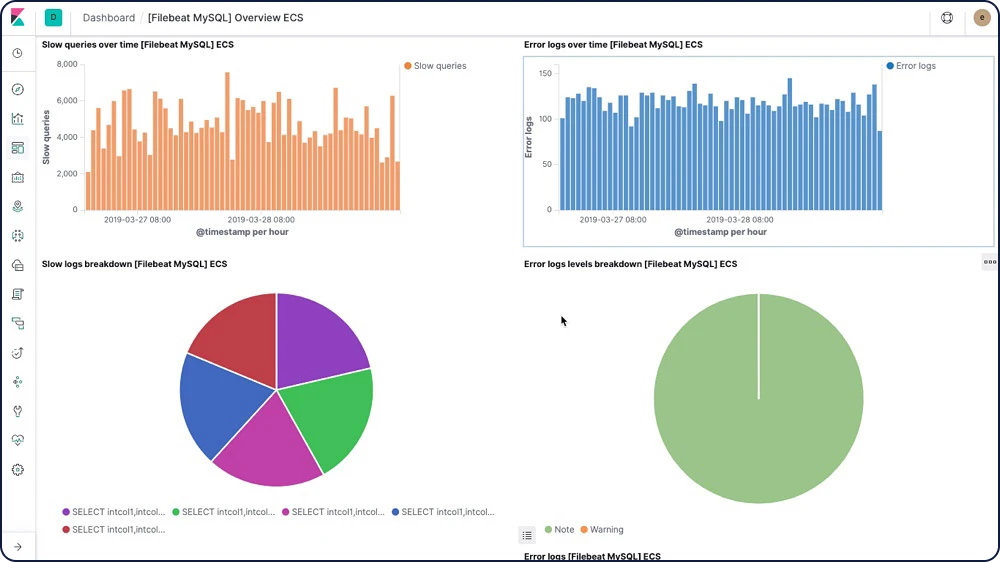

Mit Filebeat und Metricbeat können Sie Ihre Web- und Proxyserver auf vielerlei Arten überwachen, unter anderem mit Modulen und vorkonfigurierten Dashboards für NGINX, Apache, HAProxy und IIS.

Datenspeicher und Warteschlangen

Filebeat und Metricbeat enthalten interne Module zur Vereinfachung der Erfassung, Analyse und Visualisierung allgemeiner Log-Formate und Systemmetriken aus Datenspeichern, Datenbanken und Warteschlangensystemen wie MySQL, MongoDB, PostgreSQL, Microsoft SQL und mehr.

Cloud-Dienste

Mit einer zentralen Ansicht behalten Sie den Überblick über die Performance und Verfügbarkeit einer breiten Palette von Cloud-Diensten von Amazon Web Services, Google Cloud und Microsoft Azure und können so Ihre Daten effizient analysieren. Darüber hinaus hilft Ihnen Functionbeat dabei, Ihre Serverless-Cloud-Architektur anhand von Kinesis-, SQS- und CloudWatch-Logdaten ohne viel Aufwand zu überwachen.

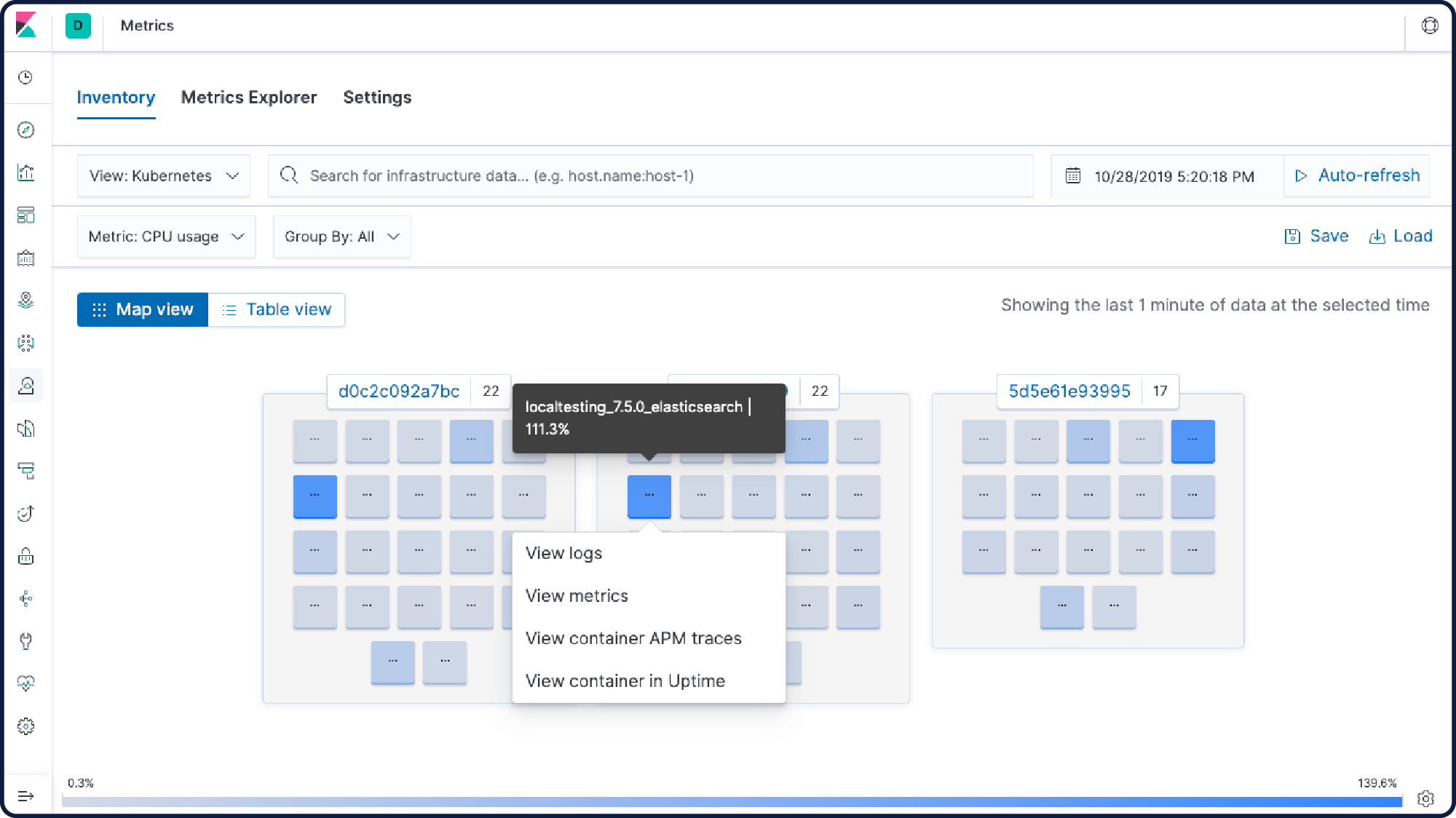

Container und Orchestrierung

Ob Überwachung Ihrer Anwendungs-Logs oder Ihrer Kubernetes-Metriken oder Leistungsanalyse Ihrer Docker-Container – mit der für Infrastrukturoperationen optimierten App können Sie all Ihre Daten einfach und schnell visualisieren und durchsuchen.

Das Autodiscover-Feature in Metricbeat und Filebeat hält Sie über Veränderungen in Ihrer Umgebung auf dem Laufenden.

Mit Docker- und Kubernetes-API-Hooks können Sie das Hinzufügen von Modulen und Logpfaden automatisieren und Ihre Monitoring-Einstellungen dynamisch anpassen lassen.

Netzwerkdaten

Netzwerkinformationen wie HTTP, DNS und SIP helfen Ihnen, wichtige Aspekte, wie Anwendungslatenz und ‑fehler, Reaktionszeiten, SLA-Performance, Nutzerzugriffsmuster und Trends, zu überwachen. Diese Daten geben Aufschluss darüber, wie die Daten durch das Netzwerk fließen.

Security-Daten

Der Schlüssel zum Erkennen von Bedrohungen kann überall liegen. Deshalb ist es auch so wichtig, dass Sie jederzeit genau wissen, was in Ihrer Umgebung vor sich geht. Agent und Beats ingestieren Security-Daten aus einer Unzahl kommerzieller und OSS-Quellen und ermöglichen so eine umfassende Datenüberwachung und Bedrohungserkennung.

Verfügbarkeitsdaten

Egal ob Sie einen Dienst auf demselben Host oder über das Internet testen – mit Heartbeat können Sie im Handumdrehen Daten zu Verfügbarkeit und Reaktionszeiten abrufen.

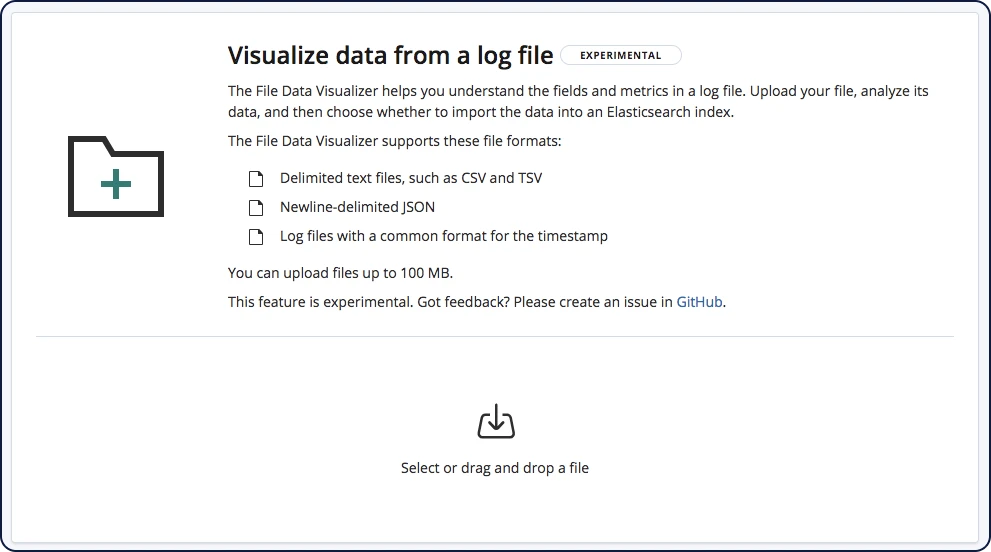

Dateiimport

Mit dem File Data Visualizer können Sie CSV-, NDJSON- oder Log-Dateien in einen Elasticsearch-Index hochladen. File Data Visualizer verwendet die File Structure API, um das Dateiformat und die Feldzuordnungen zu identifizieren. Anschließend können Sie die Daten auswählen und in einen Index importieren.

Ingestieren und Anreichern

Datenanreicherung

Mit einer Vielzahl von Analyzern, Tokenizern, Filtern und Anreicherungsoptionen zur Indexzeit wandelt der Elastic Stack Ihre Rohdaten in wertvolle Informationen um.

Prozessoren

Verwenden Sie einen Ingest-Knoten, um Dokumente vor der eigentlichen Indexierung vorzuverarbeiten. Der Ingest-Knoten akzeptiert Bulk- und Indexanfragen, wendet Transformationen an und übergibt die Dokumente anschließend zurück an den Index oder die Bulk-APIs. Der Ingest-Knoten stellt mehr als 25 verschiedene Prozessoren bereit, darunter u. a. „append“, „convert“, „date“, „dissect“, „drop“, „fail“, „grok“, „join“, „remove“, „set“, „split“, „sort“ und „trim“.

Analyzers

Bei der Analyse wird Text, zum Beispiel der Text einer E-Mail, in Token oder Begriffe konvertiert, die anschließend zum invertierten Index hinzugefügt werden, um sie durchsuchbar zu machen. Für die Analyse wird entweder ein integrierter oder ein nutzerdefinierter Analyzer verwendet werden, der pro Index mit einer Kombination aus Tokenizern und Filtern definiert wird.

Beispiel: Standard-Analyzer (Standard)

Eingabe: "The 2 QUICK Brown-Foxes jumped over the lazy dog's bone."

Ausgabe: the 2 quick brown foxes jumped over the lazy dog's bone

Tokenizer

Ein Tokenizer empfängt einen Stream von Zeichen, unterteilt ihn in einzelne Token (normalerweise Wörter) und gibt einen Token-Stream aus. Der Tokenizer ist außerdem dafür verantwortlich, die Reihenfolge oder Position der einzelnen Begriffe (für Suchen nach Sätzen oder der Nähe von Wörtern zueinander) sowie die Zeichen-Offsets für Anfang und Ende des ursprünglichen Worts zu speichern, das der Begriff abbildet (zum Hervorheben von Such-Snippets). Elasticsearch enthält eine Reihe von integrierten Tokenizern, mit denen Sie nutzerdefinierte Analyzer erstellen können.

Beispiel: Leerzeichen-Tokenizer

Eingabe: "The 2 QUICK Brown-Foxes jumped over the lazy dog's bone."

Ausgabe: The 2 QUICK Brown-Foxes jumped over the lazy dog's bone.

Filter

Token-Filter nehmen einen Stream von Tokens von einem Tokenizer entgegen und können Token modifizieren (z. B. in Kleinbuchstaben umwandeln), Token löschen (z. B. Trennwörter entfernen) oder Token hinzufügen (z. B. Synonyme). Elasticsearch enthält eine Reihe von vorkonfigurierten Token-Filtern, mit denen Sie nutzerdefinierte Analyzer erstellen können.

Zeichenfilter werden verwendet, um den Zeichenstream zu verarbeiten, bevor er an den Tokenizer übergeben wird. Ein Zeichenfilter erhält den Ausgangstext als Zeichenstream und kann Zeichen hinzufügen, entfernen oder verändern, um den Stream zu transformieren. Elasticsearch enthält eine Reihe von vorkonfigurierten Zeichenfiltern, mit denen Sie nutzerdefinierte Analyzer erstellen können.

Informationen zu ZeichenfilternSprachanalyse

Suchen Sie in Ihrer eigenen Sprache. Elasticsearch bietet mehr als 30 verschiedene Sprach-Analyzer an, darunter auch viele Sprachen mit nicht-lateinischem Alphabet wie etwa Russisch, Arabisch und Chinesisch.

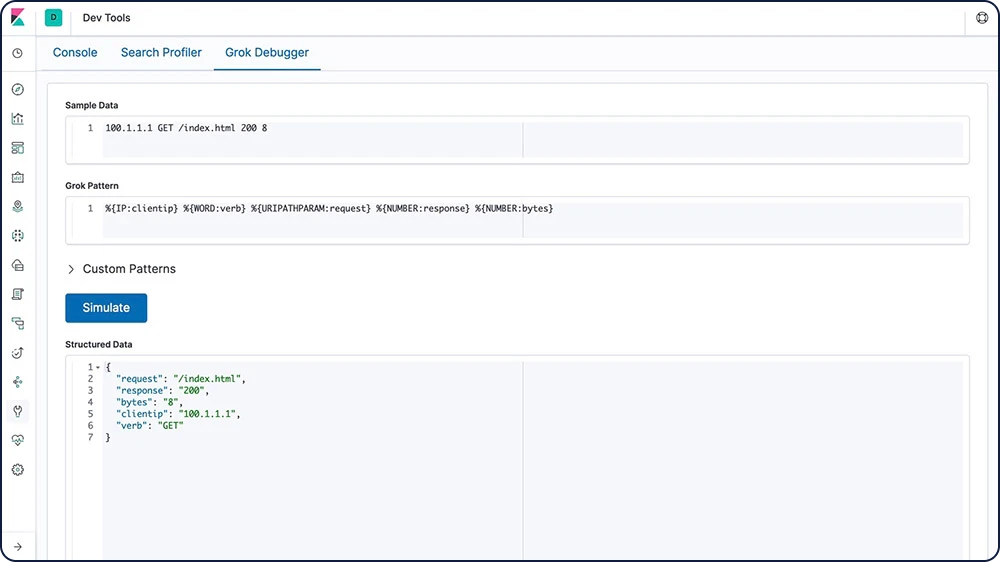

Grok

Ein Grok-Muster funktioniert wie ein regulärer Ausdruck und unterstützt wiederverwendbare Alias-Ausdrücke. Mit Grok können Sie strukturierte Felder aus einem einzelnen Textfeld in einem Dokument extrahieren. Dieses Tool eignet sich perfekt für Syslog-Logs, Webserver-Logs wie etwa von Apache, MySQL-Logs und andere Log-Formate, die eher für Menschen als für eine automatische Analyse geschrieben werden.

Feldtransformation

Mit Datafeeds können Sie Skripts hinzufügen, um Ihre Daten vor der Analyse zu transformieren. Datafeeds enthalten eine optionale Eigenschaft „script_fields“, mit der Sie Skripts angeben können, um nutzerdefinierte Ausdrücke auszuwerten und Skriptfelder zurückzugeben. Mit dieser Funktion können Sie eine Vielzahl an Transformationen ausführen.

Numerische Felder hinzufügen

Zeichenfolgen verketten, abschneiden und transformieren

Token ersetzen

Abgleich und Verkettung mit regulären Ausdrücken

Zeichenfolgen nach Domain-Name aufteilen

„geo_point“-Daten transformieren

Externe Suchen

Reichern Sie Ihre Daten beim Ingestieren mit Logstash-Plugins für externe Suchen an. Ergänzen Sie Logeinträge um zusätzlichen Kontext mit Informationen wie den Standorten von Client-IPs, DNS-Suchergebnissen oder sogar Daten aus benachbarten Logeinträgen. Logstash stellt eine Vielzahl von Such-Plugins bereit.

Match-Anreicherungsprozessor

Mit dem Match-Anreicherungsprozessor können Nutzer:innen während des Ingestierens Daten-Lookups ausführen und den Index ermitteln, aus dem angereicherte Daten geholt werden sollen. Das hilft Beats-Nutzer:innen, die ihren Daten ein paar Elemente hinzufügen müssen – statt zwischen Beats und Logstash hin- und herwechseln zu müssen, können die Nutzer:innen direkt in der Ingestion-Pipeline nachsehen. Außerdem hilft der Prozessor dabei, Daten zu normalisieren und so zu besseren Analytics-Ergebnissen und gängigeren Abfragen zu kommen.

Geo-Match-Anreicherungsprozessor

Der Geo-Match-Anreicherungsprozessor ist eine nützliche und praktische Möglichkeit, die Suche und Aggregation zu verbessern, indem die Geodaten der Nutzer:innen genutzt werden, ohne dass Abfragen oder Aggregationen mittels Geokoordinaten definiert werden müssen. Wie auch schon beim Match-Anreicherungsprozessor können Nutzer:innen während des Ingestierens Daten-Lookups ausführen und den optimalen Index ermitteln, aus dem angereicherte Daten geholt werden sollen.

Ingestieren und Anreichern

Module und Integrationen

Clients und APIs

Elasticsearch verwendet standardmäßige RESTful APIs und JSON. Außerdem entwickeln und pflegen wir Clients in vielen anderen Sprachen, wie Java, Python, .NET, SQL und PHP. Dazu ist unsere Community fleißig dabei, weitere Clients zu entwickeln. Sie sind nutzerfreundlich, intuitiv und setzen – ganz im Stil von Elasticsearch – Ihrem Ideenreichtum keine Grenzen.

Ingest-Knoten

Elasticsearch stellt eine Vielzahl von Knoten bereit, unter anderem einen speziellen Knoten für die Dateningestion. Ingest-Knoten können Vorverarbeitungs-Pipelines ausführen, die aus einem oder mehreren Ingest-Prozessoren bestehen. Je nachdem, welche Art von Operation die Ingest-Prozessoren ausführen, und welche Ressourcen benötigt werden, kann es sinnvoll sein, spezielle Ingest-Knoten für bestimmte Aufgaben einzurichten.

Elastic Agent

Elastic Agent ist ein einzelner, zentraler Agent, der auf Hosts oder in Containern bereitgestellt werden kann und Daten erfasst und sie an den Elastic Stack sendet. Mit seiner Hilfe können Hosts in die Lage versetzt werden, Logdaten, Metriken und andere Datentypen zu überwachen. Hosts mit einem Elastic Agent können die Endpoint Security-Integration nutzen, um sich auf sicherheitsrelevante Ereignisse überwachen zu lassen. Die so erfassten Security-Daten lassen sich dann über die Kibana-Anwendung Elastic Security näher untersuchen.

Beats

Beats sind Open-Source-Datenshipper, die Sie als Agents auf Ihren Servern installieren, um Betriebsdaten an Elasticsearch oder Logstash zu senden. Elastic stellt Beats bereit, mit denen Sie eine Vielzahl gängiger Logs, Metriken und anderer Datentypen erfassen können.

Auditbeat für Linux-Audit-Logs

Filebeat für Log-Dateien

Functionbeat für Cloud-Daten

Heartbeat für Verfügbarkeitsdaten

Journalbeat für systemd-Journals

Metricbeat für Infrastrukturmetriken

Packetbeat für den Netzwerkverkehr

Winlogbeat für Windows-Ereignis-Logs

Community-Shipper

Falls Sie einen sehr speziellen Anwendungsfall lösen müssen, ermutigen wir Sie dazu, einen Community Beat zu erstellen. Wir haben eine Infrastruktur eingerichtet, um den Prozess zu vereinfachen. Die komplett in Go geschriebene libbeat-Bibliothek stellt die API bereit, die sämtliche Beats verwenden, um ihre Daten nach Elasticsearch zu übertragen, die Eingabeoptionen zu konfigurieren, Logging zu implementieren, und vieles mehr.

Unter den mehr als 100 von der Community beigesteuerten Beats befinden sich Agents für Cloudwatch-Logdaten und ‑Metriken, GitHub-Aktivitäten, Kafka-Themen, MySQL, MongoDB Prometheus, Apache, Twitter und vieles, vieles mehr.

Informationen zu verfügbaren Community-BeatsLogstash

Logstash ist eine Open-Source-Datensammlungsengine mit Pipelining-Funktionen in Echtzeit. Logstash kann Daten aus verschiedenen Quellen dynamisch kombinieren und die Daten für Ziele Ihrer Wahl normalisieren. Bereinigen und demokratisieren Sie Ihre Daten für verschiedenste erweiterte Downstream-Analyse und Visualisierungs-Anwendungsfälle.

Logstash-Plugins

Sie können Ihre eigenen Eingabe-, Codec-, Filter- oder Ausgabe-Plugins zu Logstash hinzufügen. Die Plugins können unabhängig vom Logstash-Core entwickelt und bereitgestellt werden. Außerdem können Sie Ihr eigenes Java-Plugin für Logstash schreiben.

Elasticsearch-Hadoop

Elasticsearch für Apache-Hadoop (Elasticsearch-Hadoop oder ES-Hadoop) ist eine kostenlose und offene kleine Bibliothek, die eigenständig und autark ist und die Interaktion zwischen Hadoop-Aufträgen und Elasticsearch ermöglicht. Sie können sie nutzen, um mühelos eingebettete dynamische Suchanwendungen zu entwickeln, die Ihre Hadoop-Daten bereitstellen, oder um mithilfe von Volltextsuche, Geodatenabfragen und Aggregationen im Handumdrehen tiefgehende Analysen durchzuführen.

Plugins und Integrationen

Elasticsearch ist eine kostenlose und offene sprachagnostische Anwendung und kann daher problemlos mit Plugins und Integrationen erweitert werden. Plugins ermöglichen die individuelle Ergänzung der Kernfunktionen von Elasticsearch, während Integrationen externe Tools oder Module sind, die den Umgang mit Elasticsearch erleichtern.

API Extension Plugins

Alerting-Plugins

Analyse-Plugins

Discovery-Plugins

Ingestions-Plugins

Management-Plugins

Mapper-Plugins

Sicherheits-Plugins

Plugins für Snapshot und Repository-Wiederherstellung

Speicher-Plugins

Ingestieren und Anreichern

Management

Verwalten Sie Ihre Aufnahmemethoden an zentralisierten Orten in Kibana.

Fleet

Fleet stellt eine webbasierte Benutzeroberfläche in Kibana bereit, über die Integrationen für verbreitete Dienste und Plattformen hinzugefügt und verwaltet werden können. Zusätzlich bietet Fleet auch die Möglichkeit, eine ganze Flotte von Elastic Agents zu verwalten. Mit unseren Integrationen können Sie einfach und schnell neue Datenquellen hinzufügen, und sie enthalten „out of the box“ Dashboards, Visualisierungen, Pipelines und mehr, um strukturierte Felder aus Logs zu extrahieren.

Zentralisiertes Logstash-Pipeline-Management

Mit der Pipeline-Management-Benutzeroberfläche in Kibana können Sie mehrere Logstash-Instanzen steuern. Aktivieren Sie dazu in Logstash einfach das Konfigurations-Management und registrieren Sie Logstash für die Nutzung der zentral verwalteten Pipeline-Konfigurationen.

Datenspeicher

Datenspeicher

Flexibilität

Der Elastic Stack ist eine leistungsstarke Lösung, die sich für praktisch jeden Anwendungsfall eignet. Und obwohl er hauptsächlich für die erweiterten Suchfunktionen bekannt ist, eignet er sich dank des flexiblen Designs optimal für verschiedenste Anforderungen, inklusive Dokumentspeicherung, Zeitreihenanalysen und Metriken und geodatenbasierter Suche.

Datentypen

Elasticsearch unterstützt eine Vielzahl verschiedener Datentypen für die Felder in einem Dokument, und jeder dieser Datentypen hat wiederum mehrere Untertypen. Auf diese Weise können Sie Ihre Daten unabhängig von der Art der Daten möglichst effizient und effektiv speichern, analysieren und verwenden. Elasticsearch ist unter anderem für die folgenden Datentypen optimiert:

Text

Formen

Zahlen

Vektoren

Histogramm

Zeitreihen (Datum/Uhrzeit)

Feldtyp „flattened“

Geopunkte/Geoformen

Unstrukturierte Daten (JSON)

Strukturierte Daten

Volltextsuche (invertierter Index)

Elasticsearch nutzt eine Datenstruktur namens invertierter Index, die extrem schnelle Volltextsuchen ermöglicht. Ein invertierter Index enthält eine Liste aller einzigartiger Wörter in beliebigen Dokumenten und für jedes Wort eine Liste der Dokumente, in denen es vorkommt. Um einen invertierten Index zu erstellen, teilen wir zunächst das Inhaltsfeld der einzelnen Dokumente in separate Wörter (auch Begriffe oder Tokens genannt) auf, erstellen eine sortierte Liste mit allen einzigartigen Begriffen und listen anschließend auf, in welchen Dokumenten die einzelnen Begriffe vorkommen.

Dokumentenspeicher (unstrukturiert)

Daten müssen nicht strukturiert sein, um von Elasticsearch ingestiert oder analysiert zu werden (allerdings kann die Leistung mit Strukturen verbessert werden). Dieses Design erleichtert den Einstieg und optimiert Elasticsearch als effektiven Dokumentenspeicher. Elasticsearch ist zwar keine NoSQL-Datenbank, bietet jedoch ähnliche Funktionen.

Zeitreihen/Analytics (Speicher im Spaltenformat)

Mit einem invertierten Index können Sie Suchbegriffe mit Abfragen schnell nachschlagen, aber für Sortier- und Aggregationsvorgänge brauchen wir ein anderes Datenzugriffsmuster. Anstatt den Begriff nachzuschlagen, um Dokumente zu finden, wollen wir Dokumente nachschlagen und die Begriffe in einem bestimmten Feld finden. Dokumentwerte sind die auf dem Laufwerk enthaltenen Datenstrukturen in Elasticsearch. Sie werden beim Indexieren des Dokuments erstellt und ermöglichen daher dieses Datenzugriffsmuster, bei dem die Suche nach Spalten erfolgt. Daher liefert Elasticsearch hervorragende Ergebnisse bei Zeitreihen- und Metrikanalysen.

Datenspeicher

Security

Elasticsearch bietet zahlreiche Methoden, mit denen Sie dafür sorgen können, dass Ihre Daten nicht in den falschen Händen landen.

Unterstützung für die Verschlüsselung inaktiver Daten

Der Elastic Stack implementiert zwar keine Verschlüsselung für ruhende Daten, aber wir empfehlen trotzdem, eine Verschlüsselung auf Laufwerksebene für alle Hostcomputer zu konfigurieren. In den Snapshot-Zielen muss ebenfalls sichergestellt werden, dass die ruhenden Daten verschlüsselt werden.

API für Sicherheit auf Feld- und Dokumentebene

Mit der Sicherheit auf Feldebene können Sie einschränken, auf welche Felder die Nutzer:innen Lesezugriff haben. Insbesondere können Sie einschränken, welche Felder für dokumentbasierte Lese-APIs verfügbar sind.

Mit der Sicherheit auf Dokumentebene können Sie einschränken, auf welche Dokumente die Nutzer:innen Lesezugriff haben. Insbesondere können Sie einschränken, welche Dokumente für dokumentbasierte Lese-APIs verfügbar sind.

Informationen zur Sicherheit auf DokumentebeneDatenspeicher

Management

Mit Elasticsearch können Sie Ihre Cluster und deren Knoten, Ihre Indizes und deren Shards sowie ganz besonders sämtliche enthaltenen Daten vollständig verwalten.

Clusterbasierte Indizes

Ein Cluster ist eine Sammlung von einem oder mehreren Knoten (Servern), die zusammen Ihre Daten enthalten und föderierte Indexierungs- und Suchfunktionen über alle Knoten bereitstellen. Diese Architektur erleichtert die horizontale Skalierung. Elasticsearch stellt eine umfangreiche und leistungsstarke REST-API und Benutzeroberflächen bereit, die Sie für die Verwaltung Ihrer Cluster verwenden können.

Datensnapshot und Wiederherstellung

Ein Snapshot ist eine Sicherung aus einem aktiven Elasticsearch-Cluster. Snapshots können entweder für einzelne Indizes oder für ein gesamtes Cluster erstellt und in einem Repository in einem freigegebenen Dateisystem gespeichert werden. Außerdem sind Plugins verfügbar, mit denen Sie Remote-Repositorys unterstützen können.

Source-only-Datensnapshots

Mit einem Source-Only-Repository können Sie extrem kleine Source-Only-Snapshots erstellen, die bis zu 50 % weniger Platz auf dem Laufwerk belegen. Source-only-Snapshots enthalten gespeicherte Felder und Index-Metadaten. Sie enthalten keine Index- oder Dokumentwertstrukturen und sind nach dem Wiederherstellen nicht durchsuchbar.

Rollup-Indizes

Verlaufsdaten sind oft extrem hilfreich für die Analyse, werden allerdings oft nicht aufbewahrt, weil es kostspielig ist, riesige Datenmengen zu archivieren. Die Aufbewahrungsfristen werden daher eher aus finanziellen Gründen begrenzt als durch die Nützlichkeit umfassender Verlaufsdaten. Mit der Rollup-Funktion können Sie Verlaufsdaten zusammenfassen und speichern, um sie weiterhin für Analysen zu können, jedoch zu einem Bruchteil der Speicherungskosten für Rohdaten.

Suchen und Analysieren

Suchen und Analysieren

Volltextsuche

Elasticsearch ist bekannt für die umfassenden Volltextsuchfunktionen und die Geschwindigkeit, die dabei an den Tag gelegt wird. Die Geschwindigkeit wird durch den invertierten Index ermöglicht, und die Leistungsfähigkeit ist das Ergebnis einer Kombination aus Relevanz-Scoring, einer hochentwickelten Abfrage-DSL und einer Vielzahl von Funktionen zum Ausbau der Suchfunktionen.

Invertierter Index

Elasticsearch nutzt eine Datenstruktur namens invertierter Index, die extrem schnelle Volltextsuchen ermöglicht. Ein invertierter Index enthält eine Liste aller einzigartiger Wörter in beliebigen Dokumenten und für jedes Wort eine Liste der Dokumente, in denen es vorkommt. Um einen invertierten Index zu erstellen, teilen wir zunächst das Inhaltsfeld der einzelnen Dokumente in separate Wörter (auch Begriffe oder Tokens genannt) auf, erstellen eine sortierte Liste mit allen einzigartigen Begriffen und listen anschließend auf, in welchen Dokumenten die einzelnen Begriffe vorkommen.

Laufzeitfelder

Ein Laufzeitfeld ist ein Feld, das zum Zeitpunkt der Abfrageausführung ausgewertet wird („Schema-on-read“). Laufzeitfelder können jederzeit eingeführt oder geändert werden, auch nachdem die Dokumente indexiert wurden, und sie können als Teil einer Abfrage definiert werden. Abfragen sehen diese Felder über dieselbe Schnittstelle wie sie indexierte Felder sehen. Das heißt, dass ein und dasselbe Feld in einigen Indizes eines Datenstreams ein Laufzeitfeld sein kann, während es in anderen Indizes desselben Datenstreams als indexiertes Feld auftritt. Es ist wichtig, dass Abfragen diesen Unterschied erkennen. Während indexierte Felder eine optimale Abfrage-Performance bieten, stellen Laufzeitfelder eine gute Ergänzung dar, weil sie eine Änderung der Datenstruktur ermöglichen, nachdem das Dokument indexiert wurde.

Lookup-Laufzeitfeld

Mit Lookup-Laufzeitfeldern können Sie Ergebnissen aus einem Primärindex Informationen aus einem Lookup-Index hinzufügen, indem Sie für beide Indizes einen Primärschlüssel definieren, der die Dokumente miteinander verknüpft. Diese Funktion, die wie Laufzeitfelder bei der Abfrageverarbeitung verwendet wird, ermöglicht eine flexible Datenanreicherung.

Cluster-übergreifende Suche

Mit der Cluster-übergreifenden Suche (Cross-Cluster Search, CCS) kann jeder beliebige Knoten als föderierter Client über mehrere Cluster hinweg eingesetzt werden. Die Cluster-übergreifenden Knoten treten dem Remote-Cluster nicht bei, sondern stellen eine ressourcenschonende Verbindung her, um föderierte Suchanfragen auszuführen.

Relevanz-Scoring

Eine Ähnlichkeit (Relevanz-Scoring/Ranking-Modell) definiert, wie übereinstimmende Dokumente bewertet werden. Elasticsearch verwendet standardmäßig die BM25-Ähnlichkeit, eine komplexe, TF/IDF-basierte Ähnlichkeit mit integrierter tf-Normalisierung, die sich optimal für kurze Felder wie etwa Namen eignet, bietet jedoch auch viele weitere Ähnlichkeitsoptionen an.

Vektorsuche (ANN)

Aufbauend auf der neuen Unterstützung für die approximative Nächster-Nachbar-Suche (ANN-Suche) in Lucene 9 auf der Basis des HNSW-Algorithmus ermöglicht der neue „_knn_search API“-Endpoint eine skalierbarere und leistungsfähigere Suche anhand der Vektorähnlichkeit. Zu diesem Zweck wird nach einem Kompromiss zwischen Trefferquote („Recall“) und Performance gesucht, was – im Vergleich mit der herkömmlichen kompromisslosen Vektorähnlichkeitsmethode – zu einer deutlich besseren Performance bei sehr großen Datenbeständen führt und die Trefferquote nur geringfügig reduziert.

Query DSL

Für eine Volltextsuche benötigen Sie eine robuste Abfragesprache. Elasticsearch stellt eine komplette Abfrage-DSL (domain-specific language, domänenspezifische Sprache) auf JSON-Basis bereit, mit der Sie Abfragen definieren können. Erstellen Sie einfache Abfragen nach Begriffen und Sätzen, oder entwickeln Sie zusammengesetzte Abfragen mit einer Kombination aus mehreren Abfragen. Außerdem können Sie zur Abfragezeit Filter anwenden, um Dokumente zu entfernen, bevor diese eine Relevanzbewertung erhalten haben.

Asynchrone Suche

Mit der API für die asynchrone Suche können Nutzer:innen Abfragen, deren Verarbeitung potenziell lange dauert, im Hintergrund ausführen lassen, den Fortschritt der Abfragenverarbeitung verfolgen und Teilergebnisse abrufen, sobald diese zur Verfügung stehen.

Highlighter

Mit Highlightern können Sie hervorgehobene Snippets aus einem oder mehreren Feldern in Ihren Suchergebnissen abrufen, um den Nutzer:innen die Übereinstimmungen mit der Abfrage zu zeigen. Wenn Sie Hervorhebungen anfordern, enthält die Antwort ein zusätzliches Highlight-Element für jeden Suchtreffer, der die hervorgehobenen Felder und Fragmente enthält.

Type-Ahead (Autovervollständigung)

Der Vervollständigungs-Suggester stellt Autovervollständigungs- und Sucheingabefunktionen bereit. Diese Navigationsfunktion führt Nutzer:innen noch während der Suche zu relevanten Ergebnissen und verbessert die Suchgenauigkeit.

Rechtschreibkorrektur

Die Rechtschreibkorrektur basiert auf dem Begriffs-Suggester, der Begriffe anhand der Änderungsdistanz vorschlägt. Der empfohlene Text wird analysiert, bevor die Begriffe vorgeschlagen werden. Die vorgeschlagenen Begriffe werden pro analysiertem Vorschlags-Text-Token geliefert.

Suggester („meinten Sie“)

Mit den Satz-Suggestern fügen Sie Ihrer Suche eine „meinten-Sie“-Funktion hinzu, indem Sie die Begriffs-Suggester um zusätzliche Logik erweitern, um auf Basis von ngram-Sprachmodellen ganze korrigierte Sätze anstelle einzelner gewichteter Tokens auszuwählen. In der Praxis trifft dieser Suggester bessere Entscheidungen für die auszuwählenden Token auf Basis von Kookkurrenz und Häufigkeiten.

Percolators

Percolators stellen das herkömmliche Suchmodell, bei dem Dokumente in einem Index mit einer Abfrage gesucht werden, auf den Kopf, und gleichen stattdessen Dokumente mit Abfragen aus einem Index ab. Die eigentliche percolate-Abfrage enthält das Dokument, das als Suche verwendet und mit den gespeicherten Abfragen abgeglichen werden soll.

Query Profiler/Optimizer

Die Profile API liefert ausführliche Timinginformationen zur Ausführung einzelner Komponenten in einer Suchabfrage. Sie erhalten Einblicke in die Ausführung von Suchabfragen auf einer niedrigen Ebene, können Gründe für langsame Abfragen ermitteln und Schritte zu deren Verbesserung ergreifen.

Berechtigungsbasierte Suchergebnisse

Mit der Sicherheit auf Feldebene und auf Dokumentebene können Sie die Suchergebnisse an den Lesezugriff der Nutzer:innen anpassen. Insbesondere können Sie einschränken, welche Felder und Dokumente für dokumentbasierte Lese-APIs verfügbar sind.

Automatisches Abbrechen von Abfragen

Das automatische Abbrechen von Abfragen ist ein hilfreiches Kibana-Feature, das die Nutzung von Clustern vereinfacht, weil es unnötige Verarbeitungsschritte eliminiert. Elasticsearch-Anforderungen werden automatisch abgebrochen, sobald Nutzer:innen ihre Abfrage ändern/aktualisieren oder die Browserseite aktualisieren.

Suchen und Analysieren

Analytics

Die Datensuche ist nur der Anfang. Mit den leistungsstarken Analysefunktionen des Elastic Stack können Sie einen tieferen Sinn in den Daten finden, nach denen Sie gesucht haben. Ob Sie dies durch das Aggregieren von Ergebnissen, das Aufspüren von Beziehungen zwischen Dokumenten oder das Einrichten von Alerts bei bestimmten Schwellenwerten erreichen – das Fundament ist in jedem Fall eine besonders leistungsfähige Suchfunktionalität.

Aggregationen

Mit dem Aggregationen-Framework können Sie aggregierte Daten auf Basis einer Suchabfrage bereitstellen. Dieses Framework verwendet einfache Bausteine, die sogenannten Aggregationen, mit denen Sie komplexe Zusammenfassungen der Daten erstellen können. Eine Aggregation ist eine Arbeitseinheit, die Analysedaten über eine Reihe von Dokumenten generiert.

Metrik-Aggregationen

Bucket-Aggregationen

Pipeline-Aggregationen

Matrix-Aggregationen

Geodaten-Hexraster-Aggregationen („geohex_grid“)

Aggregation für zufallsbasiertes Sampling („random_sampler“)

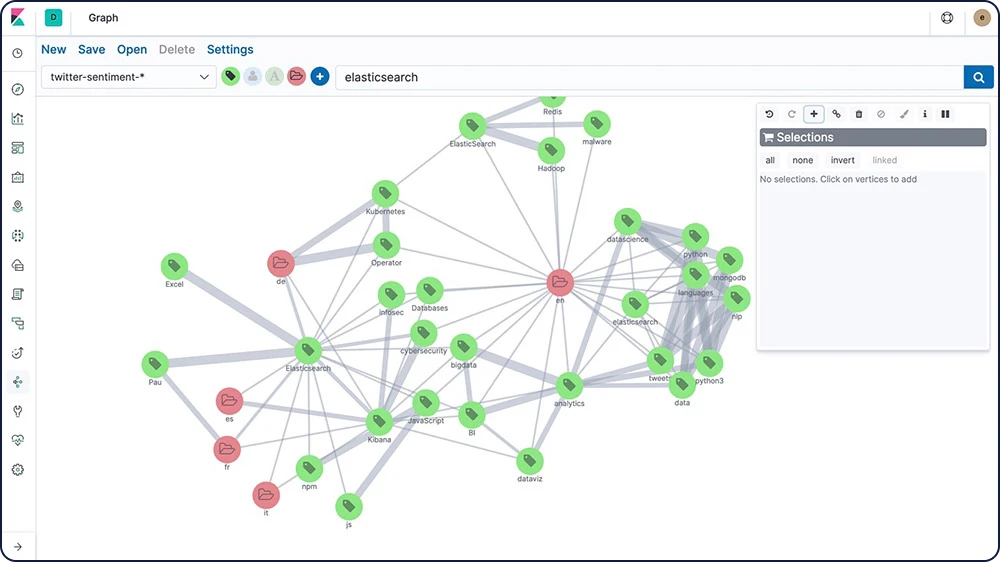

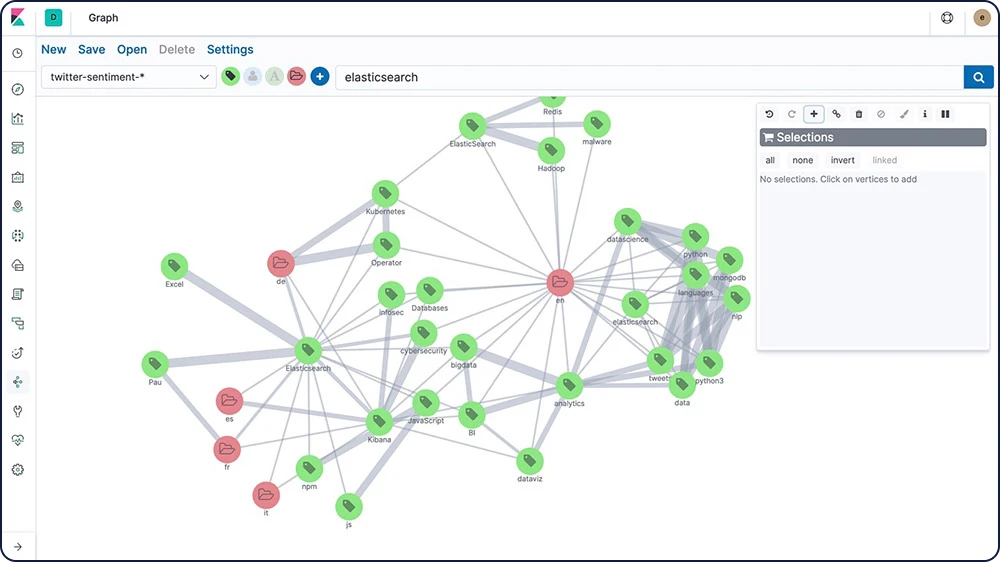

Graphexploration

Mit der Graphexplorations-API können Sie Informationen über die Dokumente und Begriffe in Ihrem Elasticsearch-Index extrahieren und zusammenfassen. Machen Sie sich mit dieser API vertraut, indem Sie Graph in Kibana einsetzen, um Verbindungen zu erkunden.

Schwellenwertbasiertes Alerting

Durch die Einrichtung schwellenwertbasierter Alerts können Sie regelmäßig überprüfen, ob die Daten in Ihren Elasticsearch-Indizes innerhalb eines vorgegebenen Zeitintervalls bestimmte Schwellenwerte über- oder unterschreiten. Unsere Alerting-Features bieten Ihnen die ganze Leistungsfähigkeit der Elasticsearch-Abfragesprache, damit Sie relevante Veränderungen in Ihren Daten identifizieren können.

Suchen und Analysieren

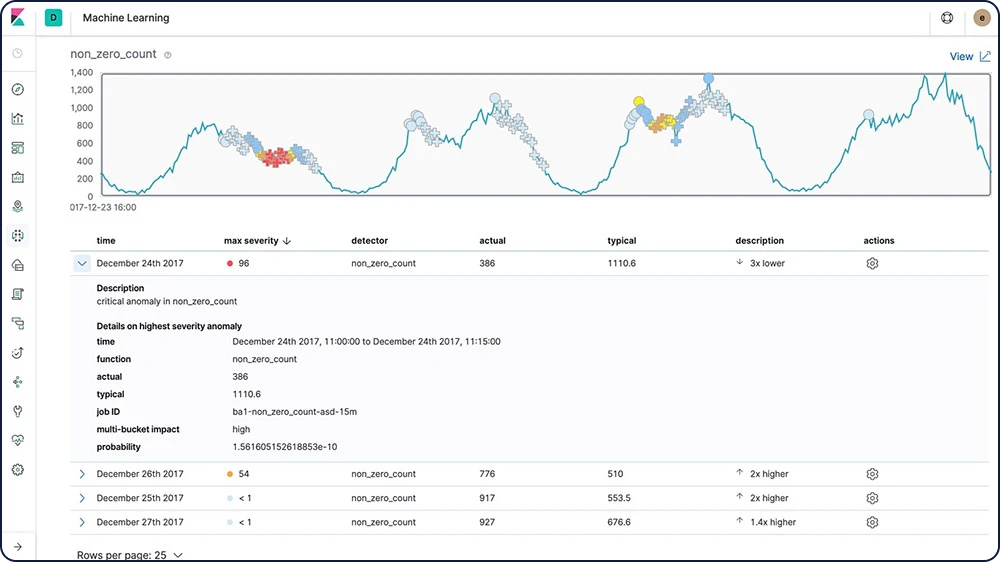

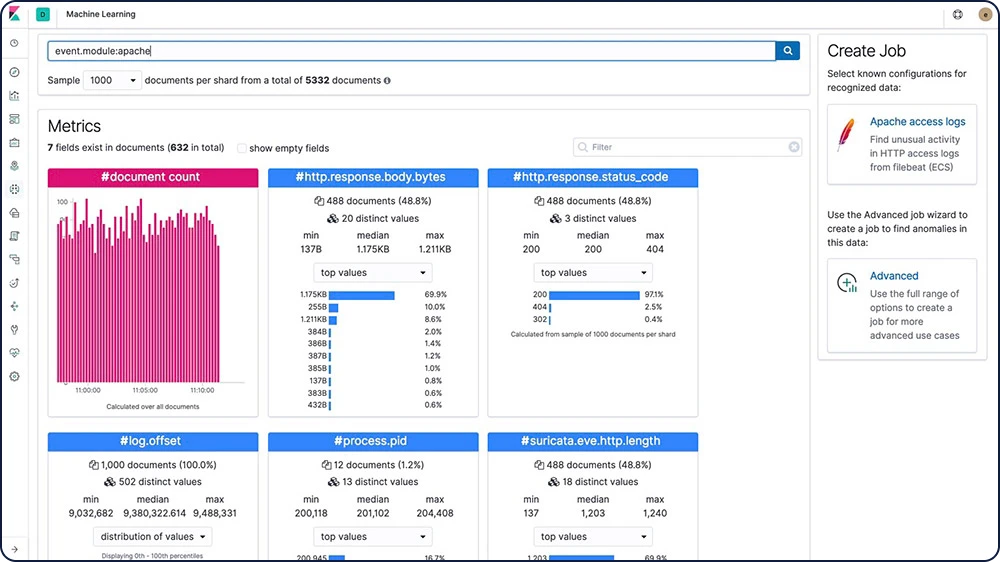

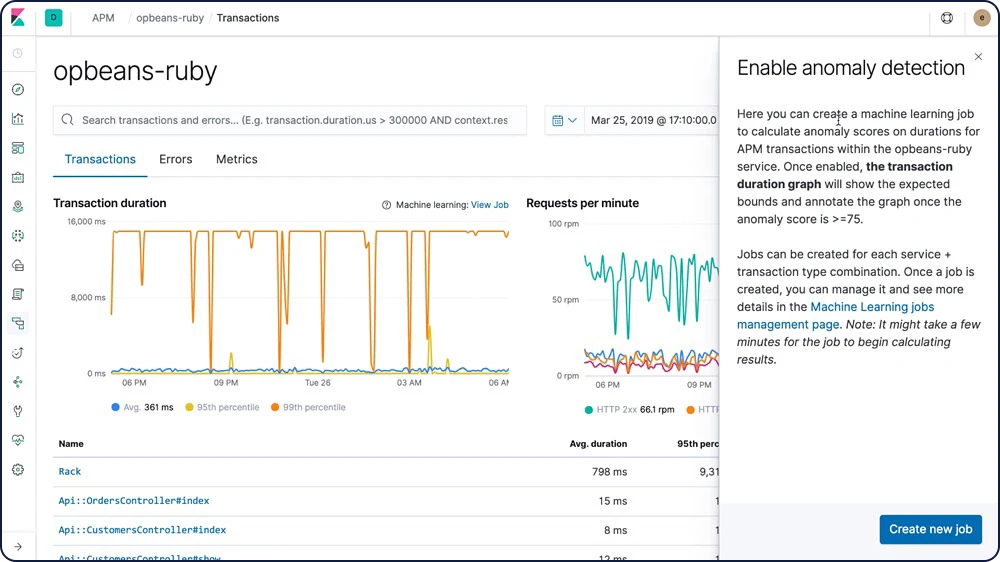

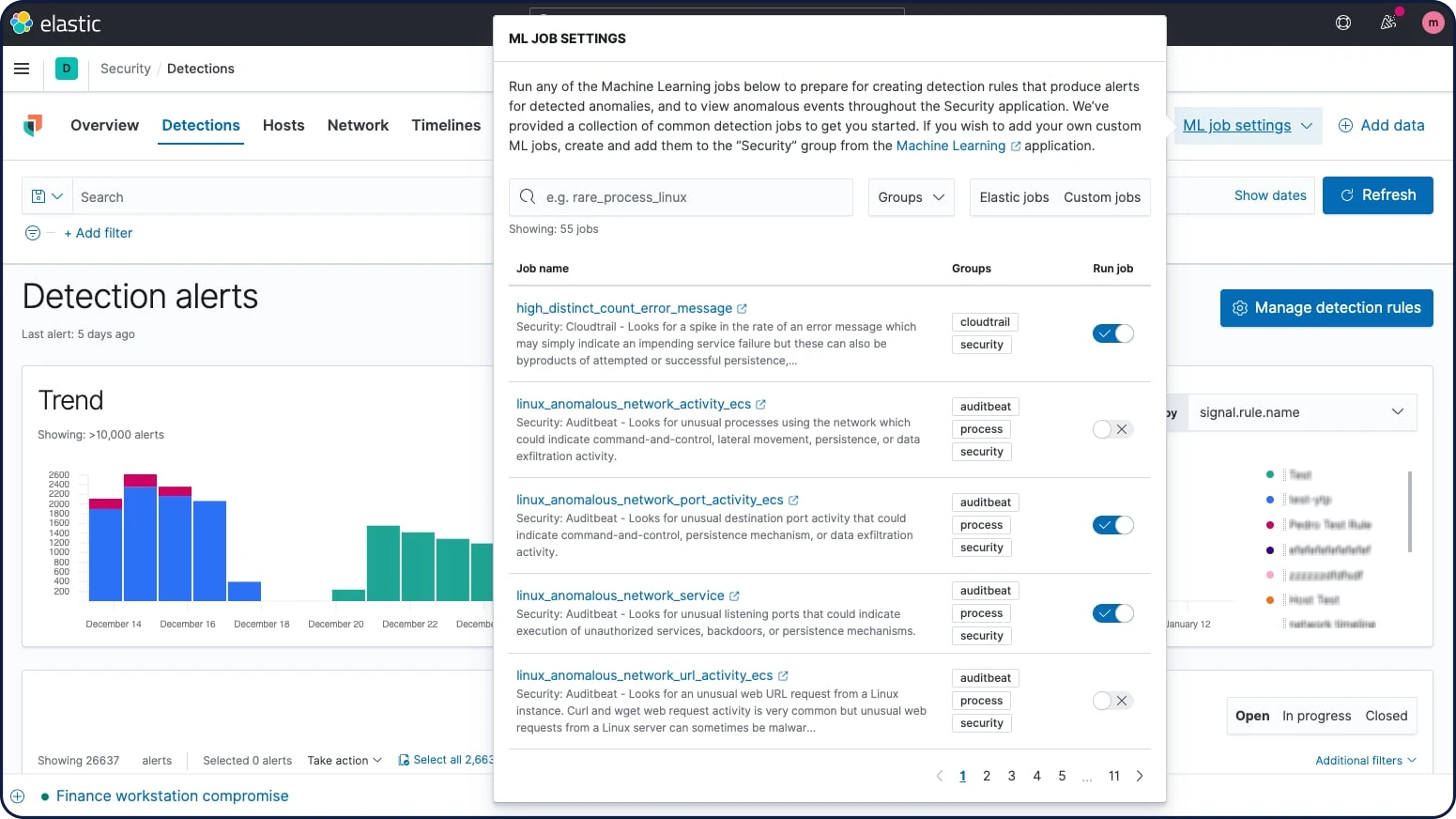

Machine Learning

Mit Elastic Machine Learning können Sie das Verhalten Ihrer Elasticsearch-Daten – Trends, Regelmäßigkeit und mehr – automatisch in Echtzeit modellieren und Probleme schneller erfassen, die Ursachenanalysen vereinfachen und Falschmeldungen verringern.

Inferenz

Mit Inferenz können Sie beaufsichtigte Machine-Learning-Prozesse, wie Regression oder Klassifizierung, nicht nur zur Analyse einzelner Batches, sondern kontinuierlich benutzen. Inferenz ermöglicht es, trainierte Machine-Learning-Modelle auf eingehende Daten anzuwenden.

Spracherkennung

Bei der Spracherkennung handelt es sich um ein trainiertes Modell, das zur Erkennung der in einem Text verwendeten Sprache dient. Sie können das Spracherkennungsmodell in einem Inferenz-Prozessor referenzieren.

Prognosen zu Zeitreihen

Nachdem Elastic Machine Learning Baselines für das normale Verhalten Ihrer Daten erstellt hat, können Sie mit diesen Daten Prognosen für das zukünftige Verhalten generieren. Erstellen Sie anschließend eine Prognose für einen Zeitreihenwert zu einem bestimmten Zeitpunkt in der Zukunft oder schätzen Sie die Wahrscheinlichkeit für einen bestimmten Zeitreihenwert in der Zukunft ab.

Anomalieerkennung in Zeitreihen

Mit den Elastic Machine-Learning-Funktionen können Sie die Analyse von Zeitreihendaten automatisieren, indem Sie exakte Baselines für das normale Verhalten in den Daten generieren und anschließend abnormale Muster identifizieren. Anomalien werden mithilfe von proprietären Machine-Learning-Algorithmen erkannt, klassifiziert und mit statistisch signifikanten Einflüssen in den Daten verknüpft.

Anomalien im Zusammenhang mit zeitlichen Abweichungen von Werten, Anzahlen oder Häufigkeiten

Statistische Seltenheit

Ungewöhnliches Verhalten für ein Mitglied einer Population

Alerting bei Anomalien

Für Veränderungen, die mit Regeln und Grenzwerten schwerer zu definieren sind, können Sie Benachrichtigungen mit unbeaufsichtigten Machine-Learning-Funktionen kombinieren, um ungewöhnliche Verhaltensweisen aufzudecken. Lassen Sie sich dann anhand der Anomaliebewertungen im Alerting-Framework benachrichtigen, wenn Probleme auftreten.

Populations-/Entitätsanalyse

Mit den Elastic Machine-Learning-Funktionen können Sie ein Profil mit den Aktionen erstellen, die typische Nutzer:innen, ein Computer oder eine andere Entität über einen bestimmten Zeitraum ausführt, und anschließend Ausreißer identifizieren, die sich gegenüber der restlichen Population abnormal verhalten.

Kategorisierung von Lognachrichten

Lognachrichten von Anwendungen sind oft unstrukturiert und enthalten variable Daten. Die Machine-Learning-Funktionen von Elastic beobachten die statischen Teile der Nachricht, gruppieren ähnliche Nachrichten in Cluster und klassifizieren sie in Nachrichtenkategorien.

Anzeige der Ursache

Sobald eine Anomalie erkannt wurde, können die Elastic-Machine-Learning-Funktionen problemlos die Eigenschaften aufspüren, die diese wesentlich beeinflusst haben. Gibt es beispielsweise einen ungewöhnlichen Rückgang bei der Zahl der Transaktionen, lässt sich so schnell herausfinden, welcher Server ausgefallen ist oder welcher Switch neu konfiguriert werden muss.

Data Visualizer

Mit dem Data Visualizer können Sie Ihre Elasticsearch-Daten besser kennenlernen und mögliche Felder für die Machine Learning-Analyse identifizieren, indem Sie die Metriken und Felder in einer Log-Datei oder einem vorhandenen Index analysieren.

„Anomaly Explorer“ für Jobs mit mehreren Metriken

Erstellen Sie komplexe Machine-Learning-Jobs mit mehreren Detectors. Mit dem Anomaly Explorer können Sie sich die Ergebnisse ansehen, nachdem ein mehrere Metriken umfassender Job den Stream der Eingangsdaten analysiert, dessen Verhalten modelliert und auf Basis der beiden im Job definierten Detectors eine Analyse durchgeführt hat.

Ausreißererkennungs-API

Bei der nicht überwachten Ausreißererkennung kommen vier verschiedene distanz- und dichtebasierte Machine-Learning-Verfahren zum Einsatz, die dabei helfen herauszufinden, welche Datenpunkte im Vergleich zur Mehrheit als unüblich einzustufen sind. Zum Erstellen von Data-Frame-Analytics-Jobs für die Ausreißererkennung steht den Nutzer:innen eine eigens zu diesem Zweck geschaffene API zur Verfügung.

Modell-Snapshot-Management

Bei ungeplanten Systemausfällen oder anderen Ereignissen, die die Ergebnisse der Anomalieerkennung verfälschen können, ermöglichen Modell-Snapshots eine schnelle Wiederherstellung des gewünschten Modellzustands.

Suchen und Analysieren

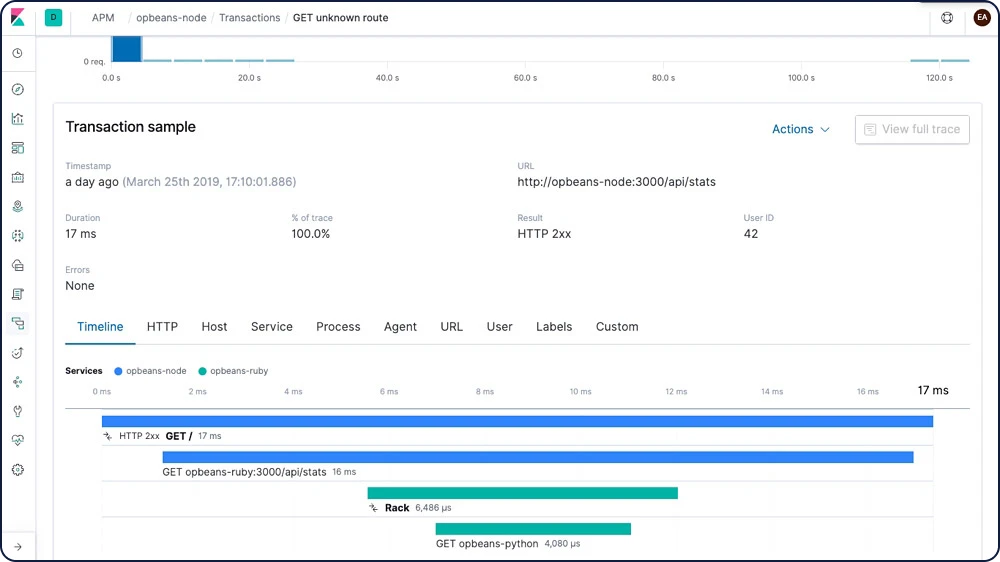

Elastic APM

Sie nutzen Elasticsearch bereits für Log-Daten und Systemmetriken? Mit Elastic APM können Sie auch Anwendungsmetriken in Elasticsearch speichern. Mit nur vier Zeilen Code erhalten Sie einen besseren Überblick und können so Fehler im zu veröffentlichenden Code schnell beheben.

APM-Server

Der APM-Server empfängt Daten von APM-Agents und transformiert sie zu Elasticsearch-Dokumenten. Dazu wird ein HTTP-Server-Endpoint bereitgestellt, an den die Agents die gesammelten APM-Daten streamen. Nachdem der APM-Server die Ereignisse von den APM-Agents validiert und verarbeitet hat, transformiert er die Daten in Elasticsearch-Dokumente und speichert sie in den entsprechenden Elasticsearch-Indizes.

APM-Agents

APM-Agents sind Open-Source-Bibliotheken, die in derselben Sprache wie Ihr Dienst geschrieben wurden. Diese Bibliotheken werden wie jede andere Bibliothek in Ihrem Dienst installiert. Sie instrumentieren Ihren Code und erfassen Leistungsdaten und Fehler zur Laufzeit. Diese Daten werden für kurze Zeit zwischengespeichert und anschließend an den APM-Server gesendet.

APM-App

Um Blockaden im Code finden und reparieren zu können, brauchen Sie eine gute Suchfunktion. Über unsere dedizierte Benutzeroberfläche können Sie Engpässe identifizieren und sich auf schwierige Änderungen auf Code-Ebene konzentrieren. Das Ergebnis: besserer, effizienterer Code für ein zügigeres Entwickeln, Testen und Implementieren, schnellere Anwendungen und ein besseres Nutzungserlebnis auf Kundenseite.

Verteiltes Tracing

Möchten Sie gern mehr darüber erfahren, welche Wege Anfragen in Ihrer Infrastruktur nehmen? Mit dem verteilten Tracing können Sie Transaktionen verketten und herausfinden, wie Transaktionen zusammenhängen und wie Ihre Dienste miteinander interagieren. So lässt sich feststellen, an welchen Stellen es stockt, und Sie ermitteln die Komponenten, die optimiert werden sollten.

Alerting-Integration

Lassen Sie sich jederzeit über Ihre Code-Performance informieren. Wenn etwas schiefläuft, erhalten Sie eine Benachrichtigung per E-Mail, und wenn etwas außerordentlich gut läuft, gibt es eine Benachrichtigung bei Slack.

Service Maps

Service Maps zeigen visuell, wie Ihre Dienste verbunden sind, und bieten allgemeine Transaktionsmetriken, wie die durchschnittliche Transaktionsdauer, Anfrage- und Fehlerraten sowie Informationen zu CPU- und Speichernutzung.

Machine Learning-Integration

Sie können Machine-Learning-Aufträge direkt in der APM-App erstellen. Anschließend können Sie Ihre Daten mit Machine-Learning-Features automatisch modellieren und abnormale Verhaltensweisen aufspüren.

Erkunden und visualisieren

Erkunden und visualisieren

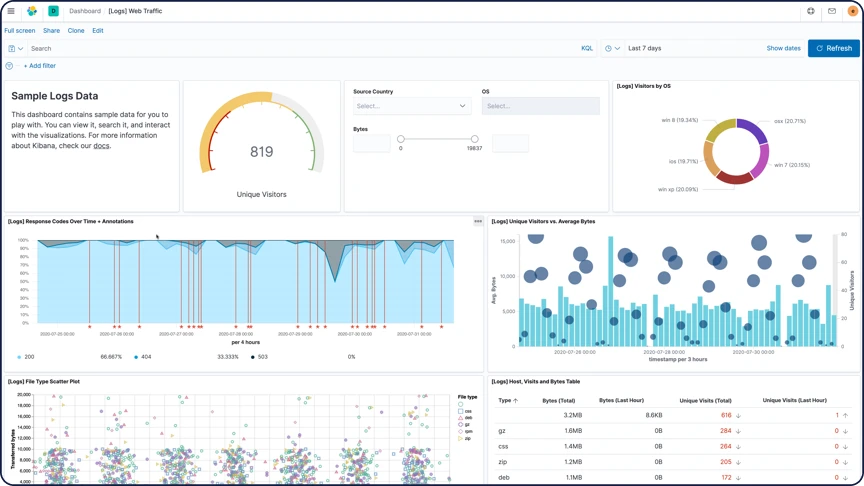

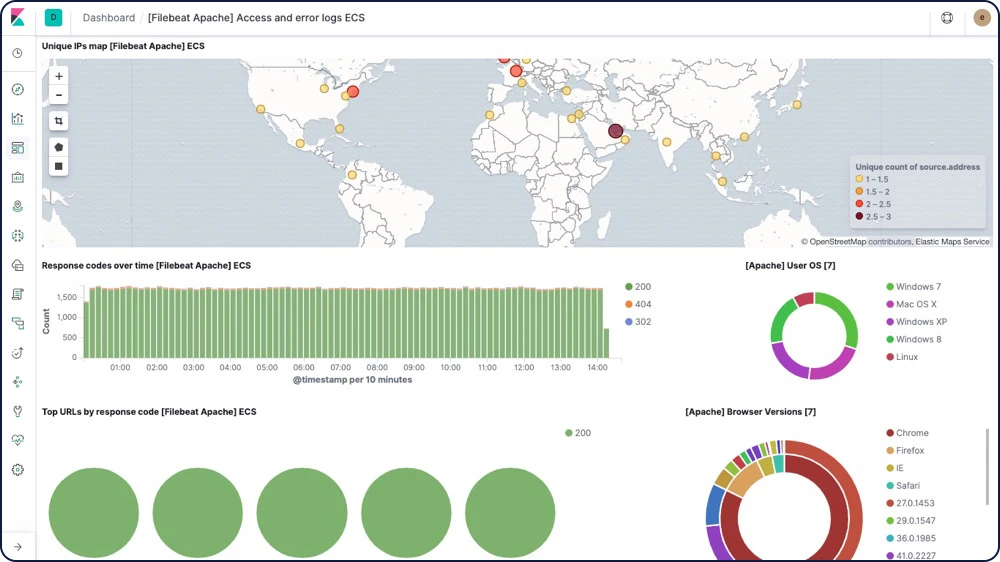

Visualisierungen

Erstellen Sie Visualisierungen für die Daten in Ihren Elasticsearch-Indizes. Kibana-Visualisierungen basieren auf Elasticsearch-Abfragen. Verwenden Sie eine Reihe von Elasticsearch-Aggregationen, um Ihre Daten zu extrahieren und zu verarbeiten, und erstellen Sie Diagramme, in denen wichtige Trends, Spitzen und Gefälle hervorgehoben werden.

Dashboards

Ein Kibana-Dashboard ist eine Zusammenstellung von verschiedenen Visualisierungen und Suchergebnissen. Sie können die Dashboard-Inhalte neu anordnen, bearbeiten und ihre Größe ändern und das Dashboard anschließend speichern, um es zu teilen. Sie haben die Möglichkeit, individuelle Drilldowns zwischen mehreren Dashboards oder zu Webanwendungen zu erstellen, um Maßnahmen festzulegen und die Entscheidungsfindung zu fördern.

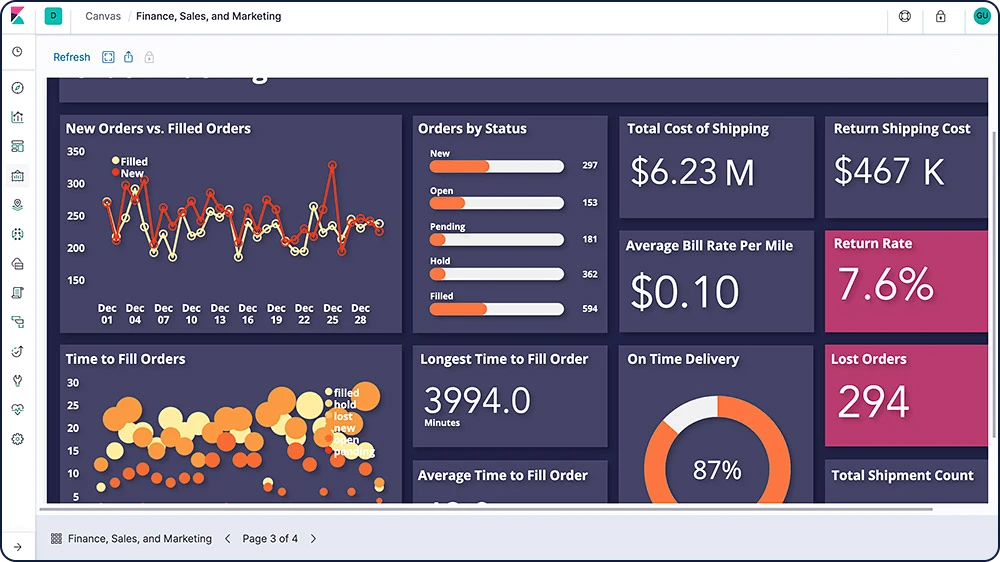

Canvas

Canvas ist eine völlig neue Art, um Ihre Daten spektakulär darzustellen. Canvas kombiniert Daten mit Farben, Formen, Text und Ihrer eigenen Fantasie, um dynamische, mehrseitige, pixelperfekte Datenanzeigen für große und kleine Bildschirme zu erstellen.

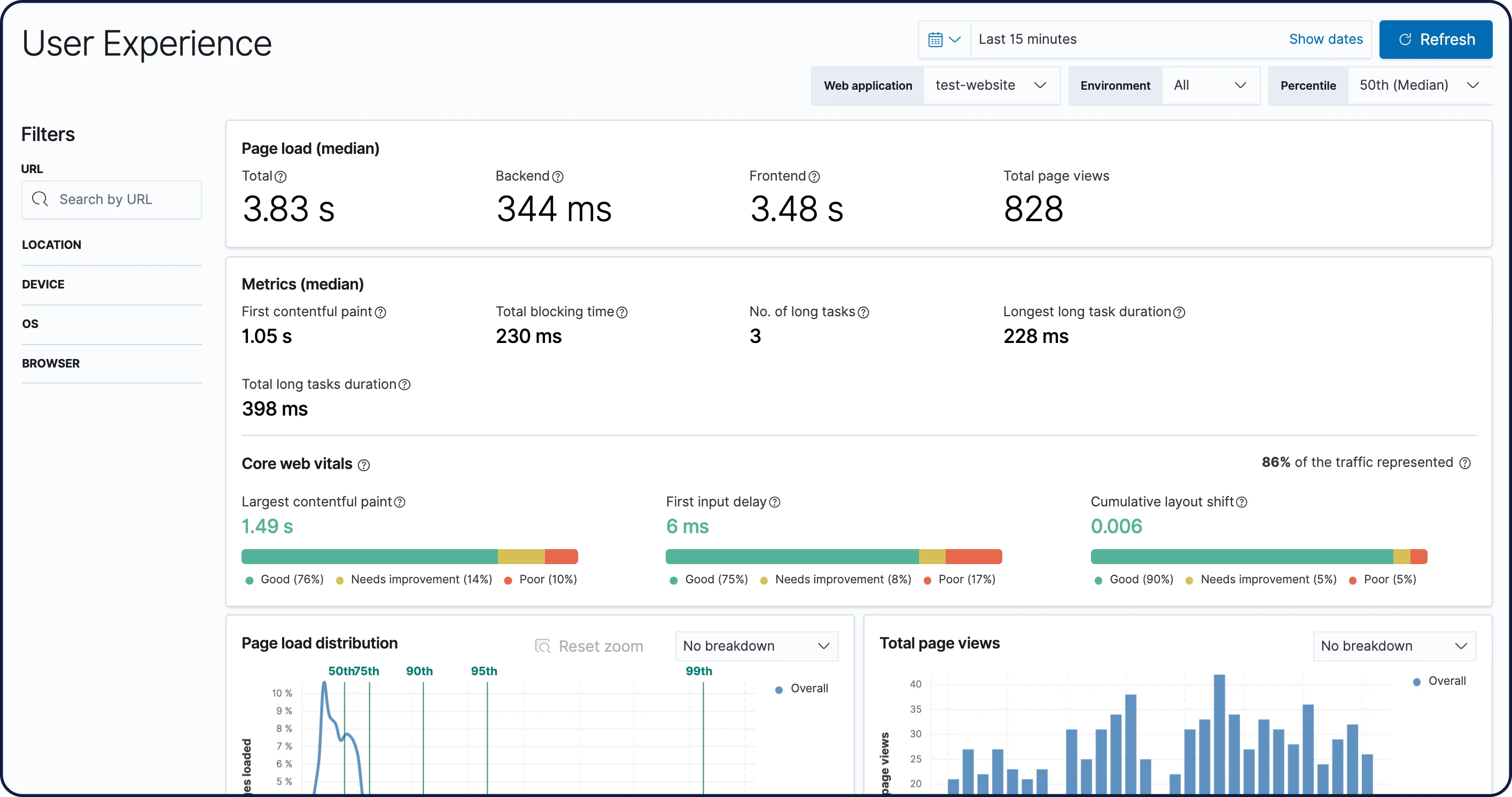

User Experience

Die von der App User Experience bereitgestellten Daten vermitteln Ihnen ein Bild davon, wie die Nutzer:innen Ihre Webanwendung erleben. So können Sie die nutzerseitig wahrgenommene Performance Ihrer Webanwendung quantifizieren und analysieren.

Kibana Lens

Kibana Lens ist eine intuitive Benutzeroberfläche, die den Prozess der Datenvisualisierung durch einfaches Drag-and-Drop vereinfacht. Es spielt keine Rolle, ob Sie Milliarden von Logs durchforschen oder Trends in Ihrem Website-Traffic ausfindig machen möchten – mit Lens braucht es nur ein paar Klicks, um aus Daten wertvolle Erkenntnisse zu gewinnen. Dabei sind keinerlei Kibana-Vorkenntnisse erforderlich.

Time Series Visual Builder

Der Time Series Visual Builder (TSVB) nutzt den vollen Leistungsumfang des Elasticsearch-Aggregationsframeworks und kombiniert eine beliebige Anzahl an Aggregationen und Pipeline-Aggregationen, um komplexe Daten bedeutungsvoll darzustellen.

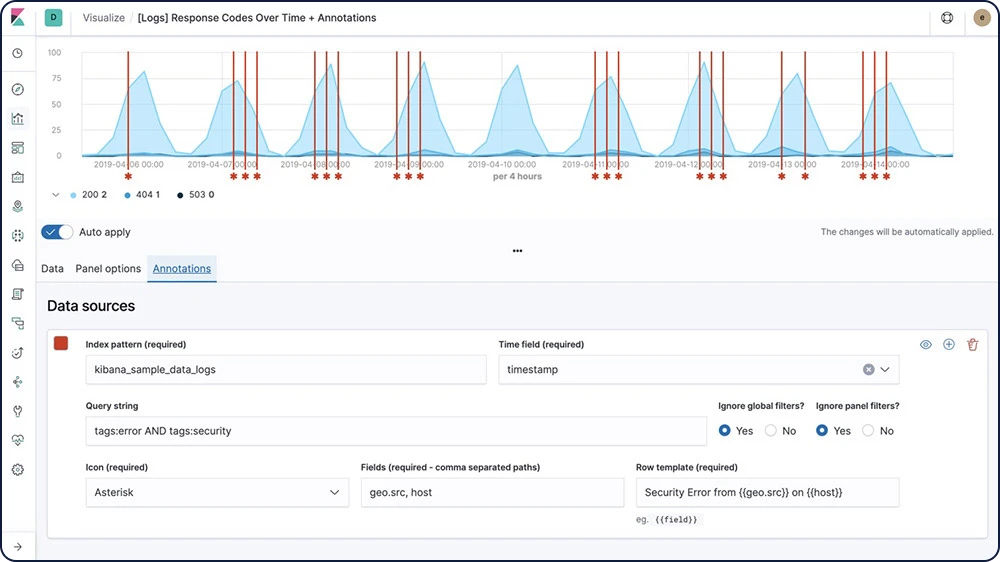

Graph Analytics

Mit der Graph-Analytics-Funktion können Sie herausfinden, in welcher Beziehung die Elemente in einem Elasticsearch-Index zueinander stehen. Erkunden Sie die Verbindungen zwischen indexierten Begriffen und finden Sie heraus, welche Verbindungen besonders wichtig sind. Diese Funktion hilft bei einer Vielzahl von Anwendungen, von der Betrugserkennung bis hin zu Empfehlungs-Engines.

Raumbezogene Analyse

Viele Nutzer:innen des Elastic Stack suchen häufig nach dem „Wo“ von Ereignissen. Ob Sie Ihr Netzwerk vor Angriffen schützen, langsame Reaktionszeiten von Anwendungen an bestimmten Orten untersuchen oder einfach nur jemanden suchen, der Sie nach Hause bringt: Geodaten – und die Suche – spielen eine wichtige Rolle.

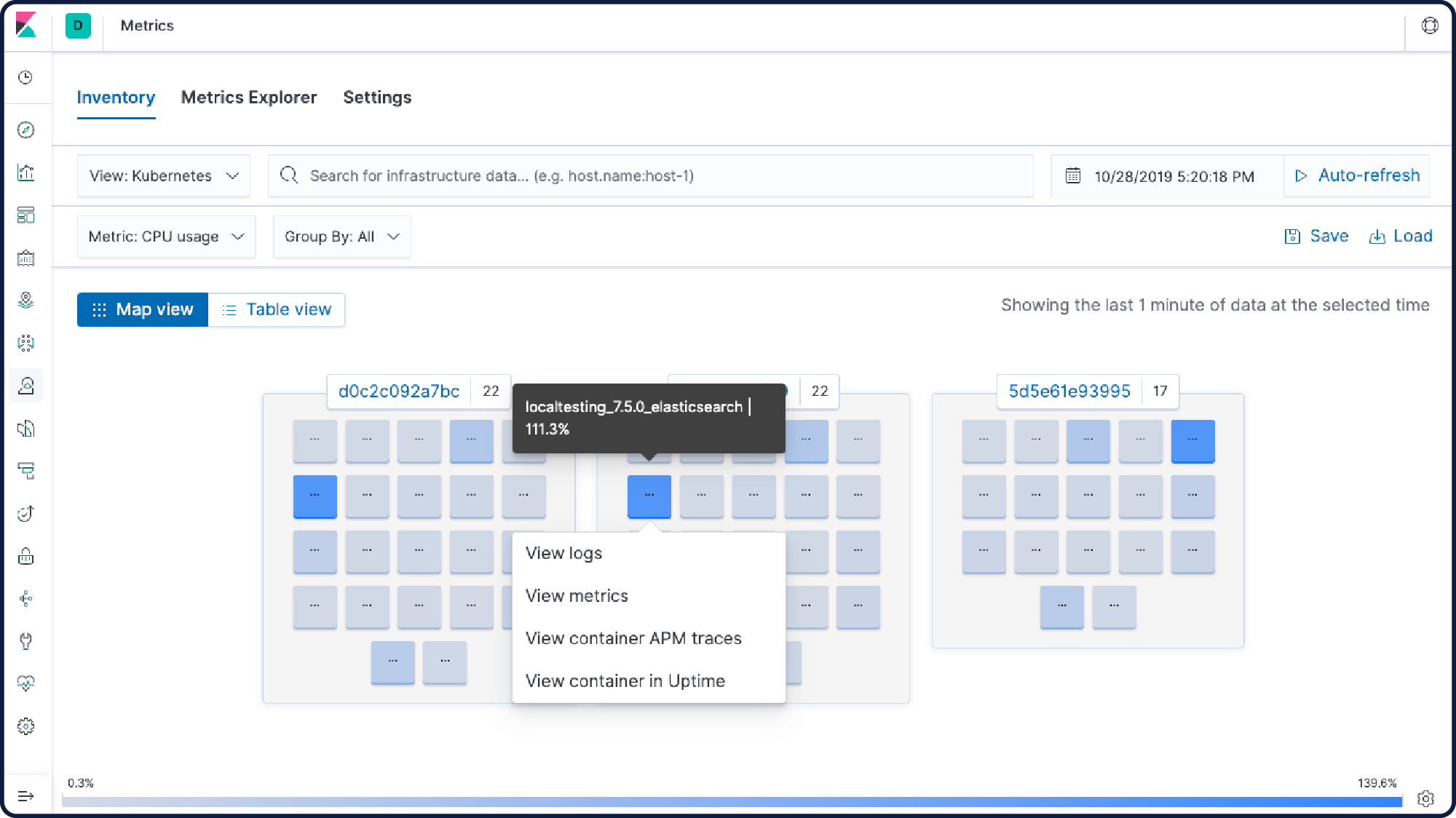

Container-Monitoring

Wie Ihre Anwendungen und Ihre Umgebung entwickelt sich auch der Elastic Stack immer weiter. In Elastic können Sie von einem zentralen Ort aus Ihre Daten überwachen, sie durchsuchen und visualisieren, was in Ihren Anwendungen, in Docker und in Kubernetes geschieht.

Kibana-Plugins

Erweitern Sie den Funktionsumfang von Kibana mit von der Community beigesteuerten Plugin-Modulen. Open-Source-Plugins sind für eine Vielzahl von Apps, Erweiterungen, Visualisierungen und mehr verfügbar. Beispiele für Plugins:

Vega-Visualisierungen

Prometheus-Exporter

3D-Diagramme und -Grafiken

Kalendervisualisierungen

Und vieles mehr

Datenimport-Tutorial

In unserem einfach zu verfolgenden Tutorial lernen Sie, einen Datensatz in Elasticsearch zu laden, ein Indexmuster zu definieren, Daten zu erfassen und zu erkunden,Visualisierungen und Dashboards zu erstellen und vieles mehr.

Kibana-Laufzeitfelder-Editor

Der Kibana-Laufzeitfelder-Editor nutzt die Laufzeitfelder in Elasticsearch, um Analyst:innen zu ermöglichen, ad hoc eigene benutzerdefinierte Felder hinzuzufügen. Mit diesem Editor, der in Indexmustern, Discover und Kibana Lens zur Verfügung steht, lassen sich Laufzeitfelder erstellen, bearbeiten und entfernen.

Erkunden und visualisieren

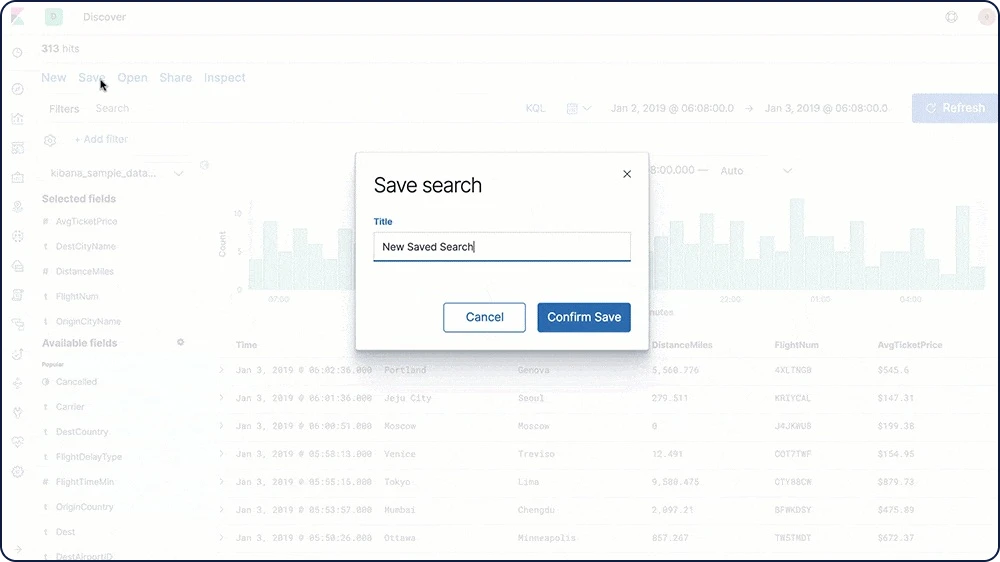

Teilen und zusammenarbeiten

Teilen Sie Ihre Kibana-Visualisierungen ganz einfach mit anderen im Team, Ihrem Chef, dessen Chef, Ihren Kunden, Compliance-Beauftragten oder Auftragnehmern – kurz gesagt, mit jedem, mit dem Sie sie teilen möchten. Betten Sie ein Dashboard ein, teilen Sie einen Link oder exportieren Sie Ihre Daten als PDF-, PNG- oder CSV-Dateien und verschicken Sie sie als Anhang. Oder organisieren Sie Ihre Dashboards und Visualisierungen in Kibana-Spaces.

Einbettbare Dashboards

In Kibana können Sie mühelos einen direkten Link zu einem Kibana-Dashboard teilen oder das Dashboard als Iframe in eine Webseite einbetten, entweder als Live-Dashboard oder als statischer Snapshot des jeweils aktuellen Zustands.

Dashboard-Only-Modus

Mit der integrierten Rolle „kibana_dashboard_only_user“ können Sie einschränken, was den Nutzer:innen nach der Anmeldung bei Kibana angezeigt wird. Die Rolle „kibana_dashboard_only_user“ ist mit schreibgeschützten Berechtigungen für Kibana vorkonfiguriert. Die Nutzer:innen können Dashboards mit uneingeschränkten Visualisierungsfunktionen öffnen. Sämtliche Bedienelemente zum Bearbeiten und Erstellen sind ausgeblendet.

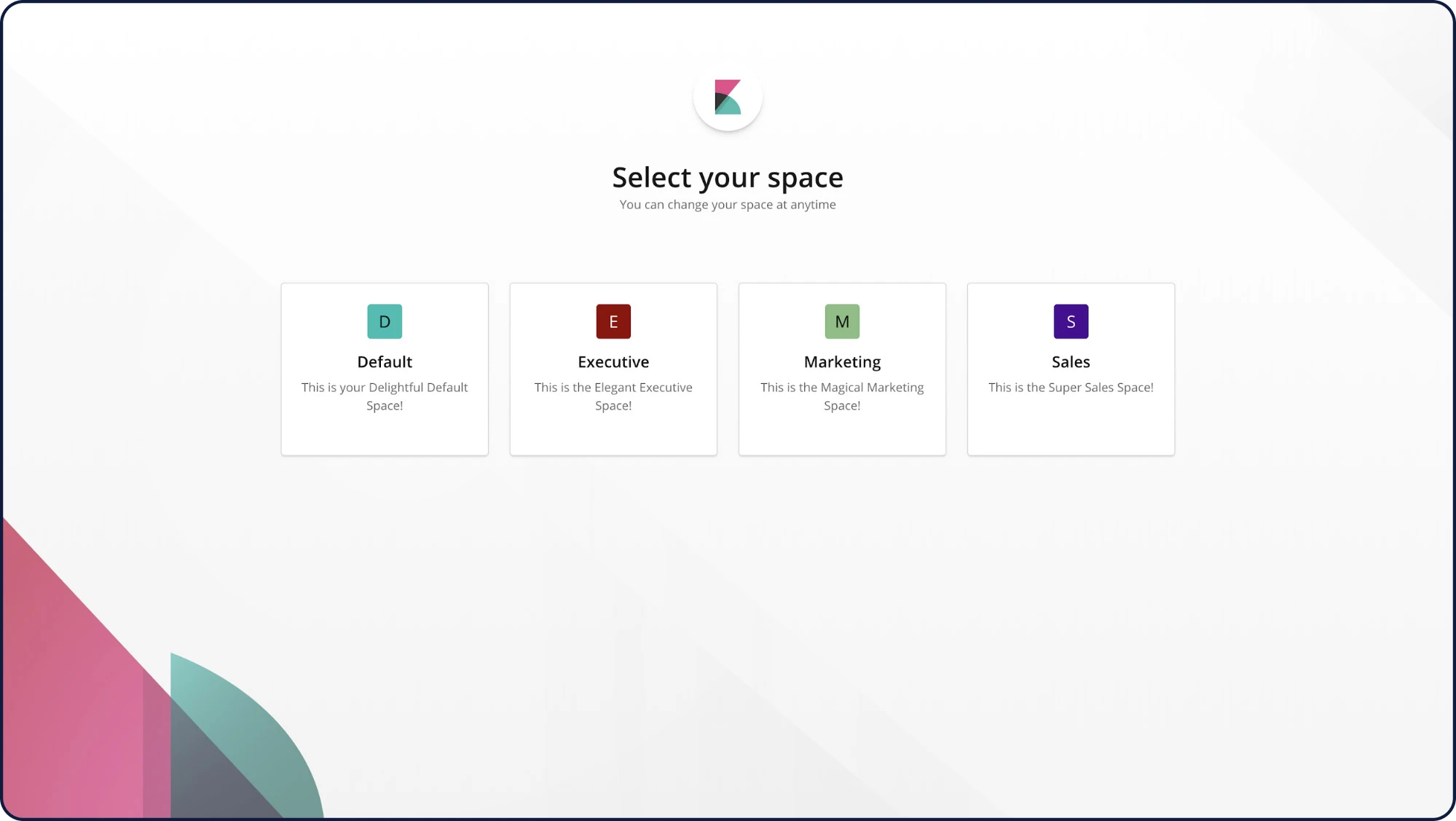

Spaces

Mit Spaces in Kibana können Sie Ihre Dashboards und andere gespeicherte Objekte in aussagekräftige Kategorien einteilen. Sobald Sie sich in einem bestimmten Space befinden, werden nur noch die Dashboards und andere gespeicherte Objekte angezeigt, die zu diesem Space gehören. Und mit den Sicherheitsfunktionen können Sie als zusätzliche Sicherheitsebene festlegen, welche Nutzer:innen Zugriff auf bestimmte Spaces erhalten.

Individuelle Banner für Kibana-Spaces

Individuelle Banner helfen bei der Abtrennung von Kibana-Spaces für unterschiedliche Rollen, Teams, Funktionen und mehr. Sie können Bekanntmachungen und Nachrichten auf spezifische Kibana-Spaces zuschneiden und Nutzer:innen dabei helfen, schnell herauszufinden, in welchem Space sie sich gerade befinden.

CSV-Exporte

In Discover können Sie gespeicherte Suchen in CSV-Dateien exportieren, um sie anschließend in externen Texteditoren zu verarbeiten.

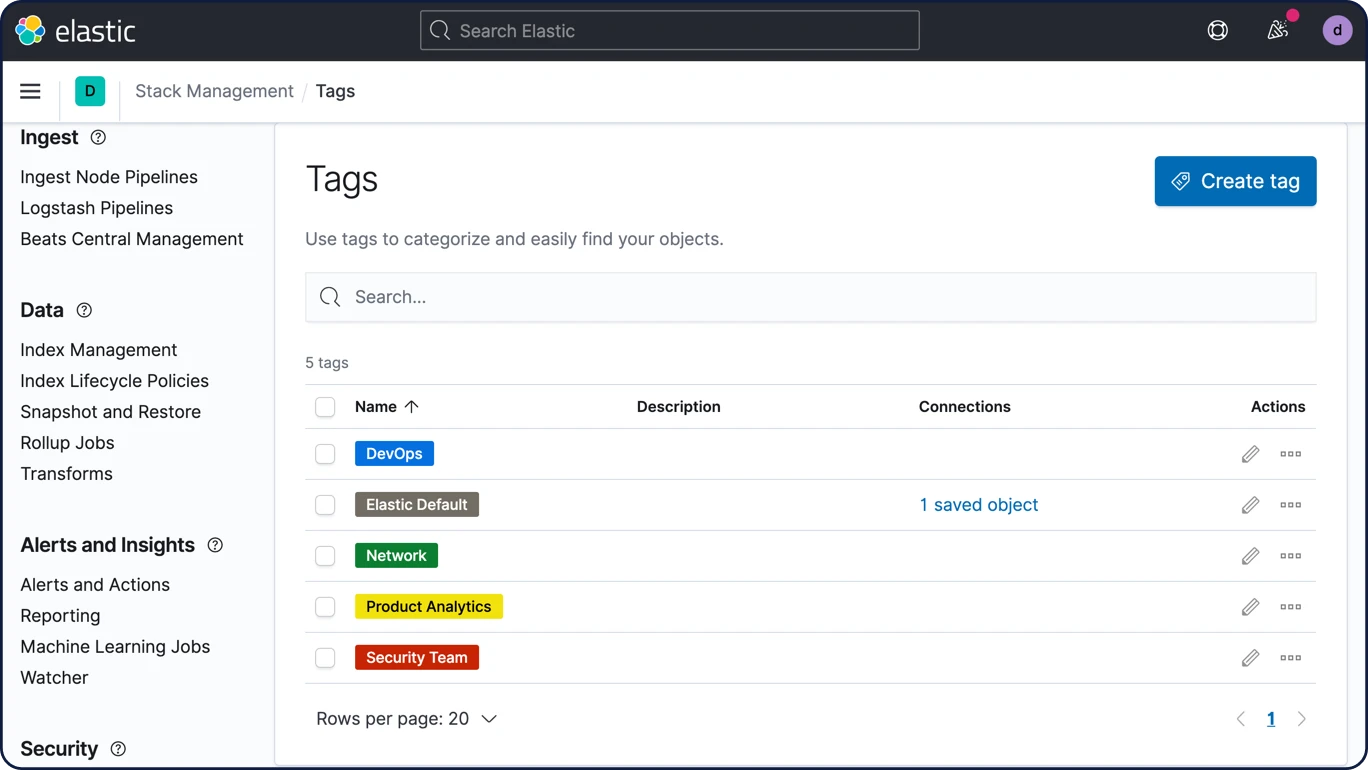

Tags

Die Möglichkeit, Tags einfach zu erstellen und sie Dashboards und Visualisierungen hinzuzufügen, macht die Verwaltung von Inhalten effizienter.

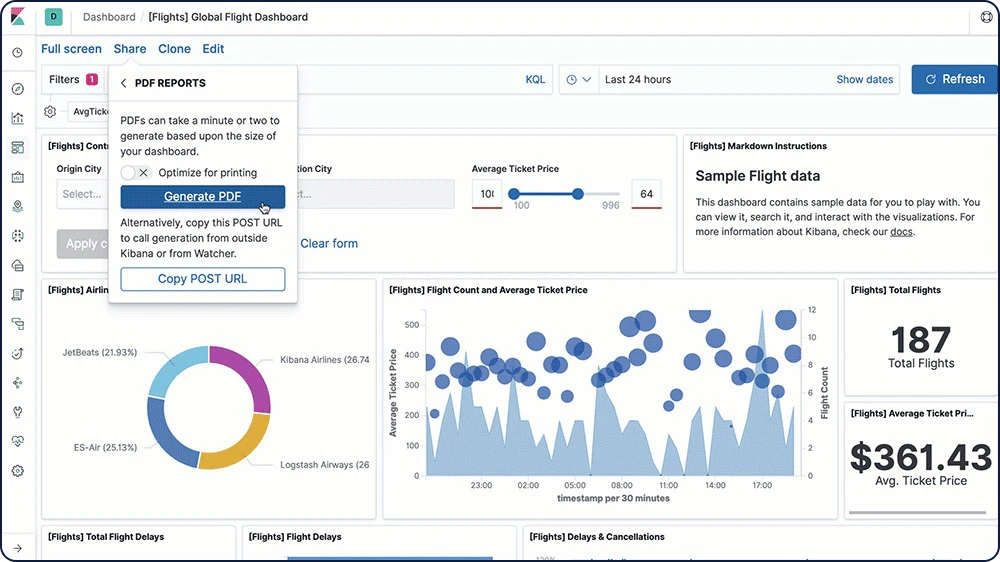

PDF- und PNG-Berichte

Erstellen Sie schnell und einfach Berichte zu beliebigen Kibana Visualisierungen und -Dashboards und speichern Sie sie als PDF oder PNG. Sie können Berichte ad hoc herunterladen, zu bestimmten Zeiten automatisch erstellen, bei Vorliegen bestimmter Bedingungen generieren lassen und automatisch mit anderen Nutzer:innen teilen.

Erkunden und visualisieren

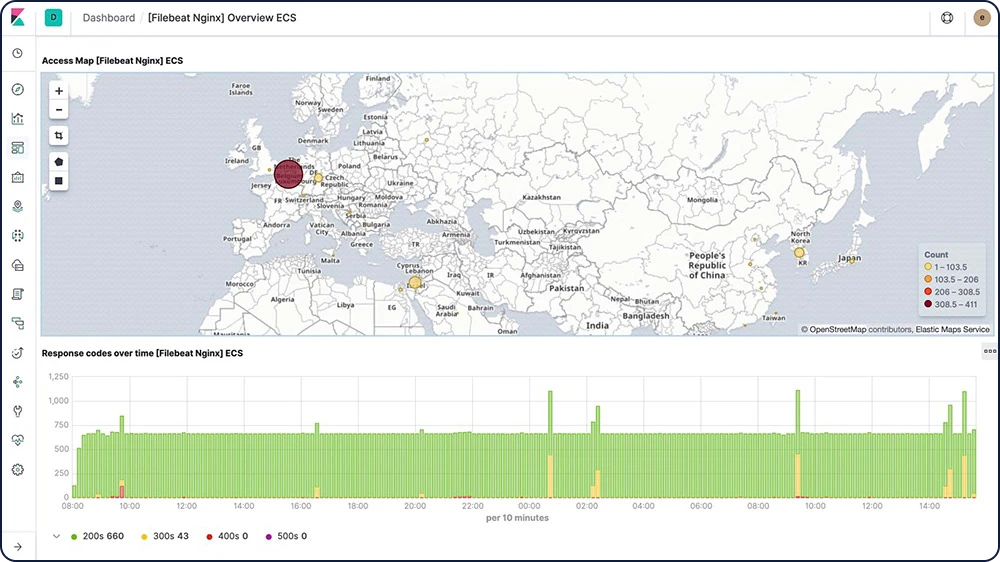

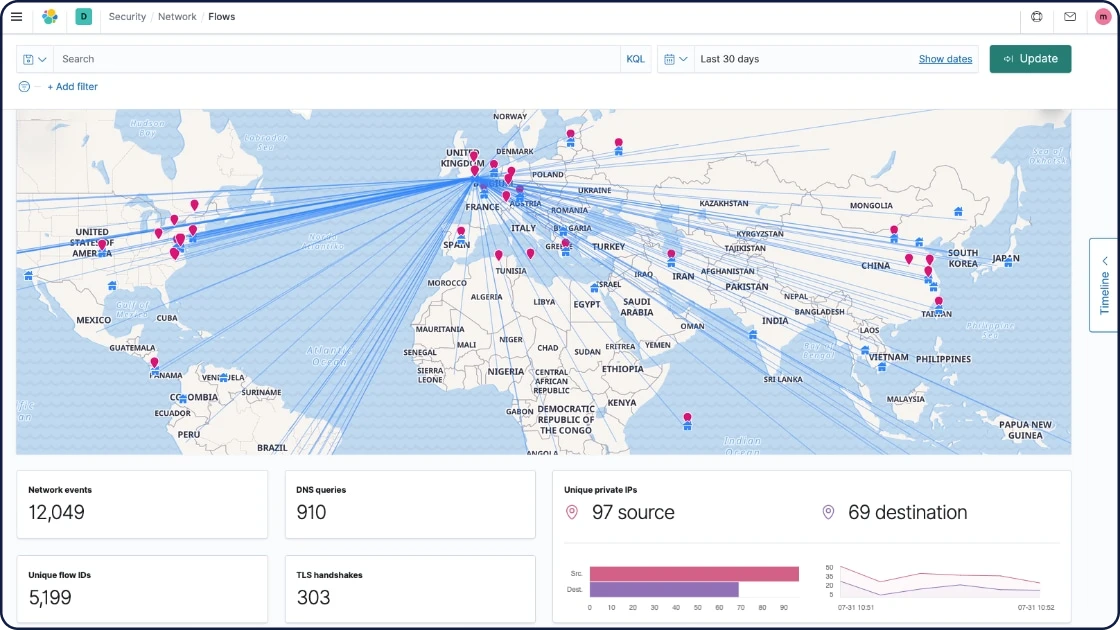

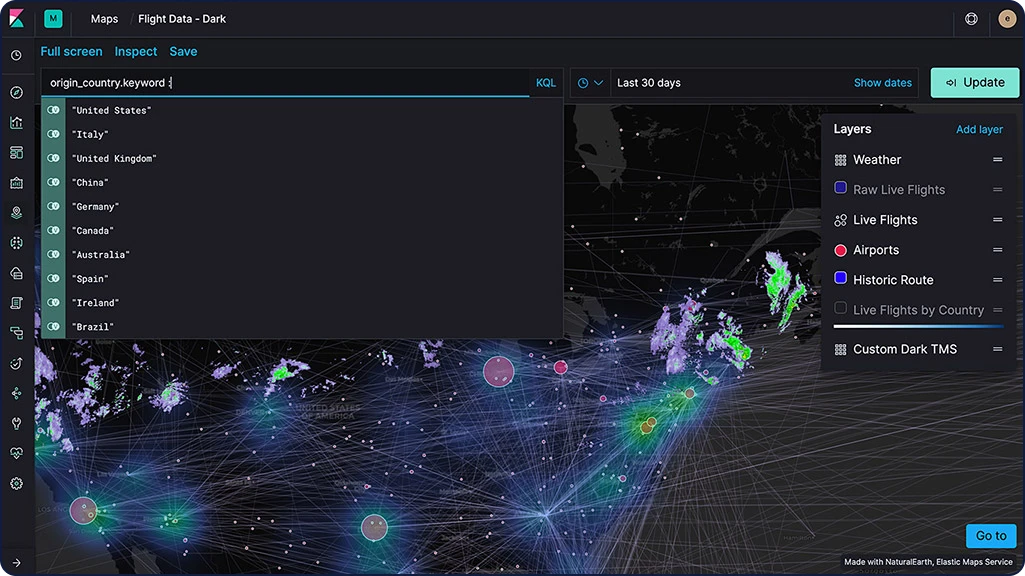

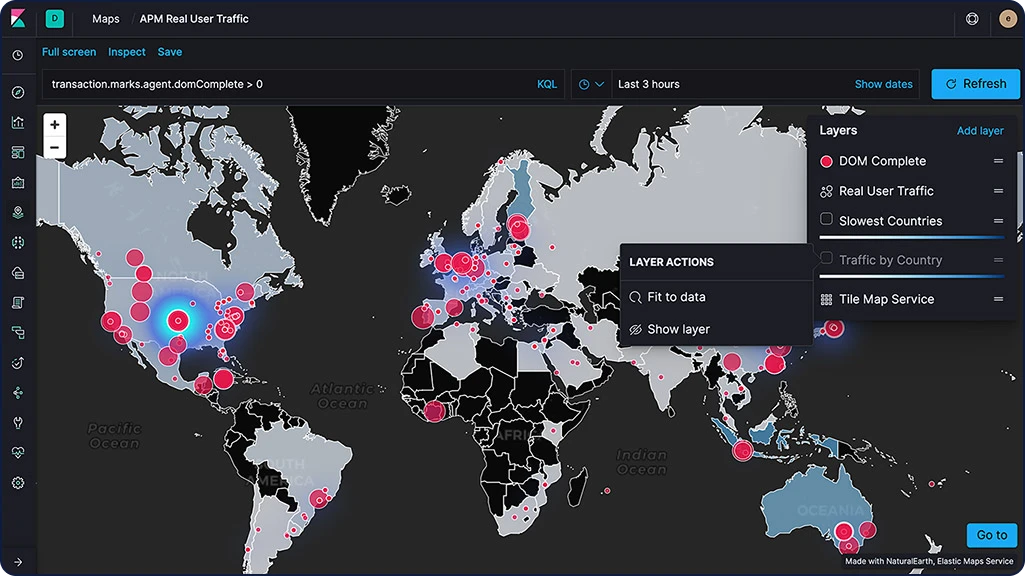

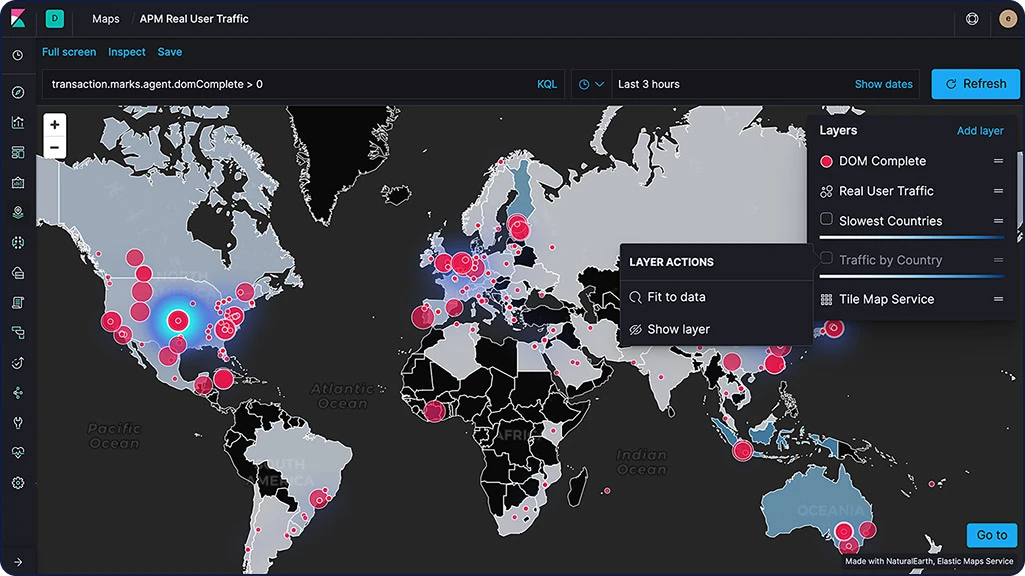

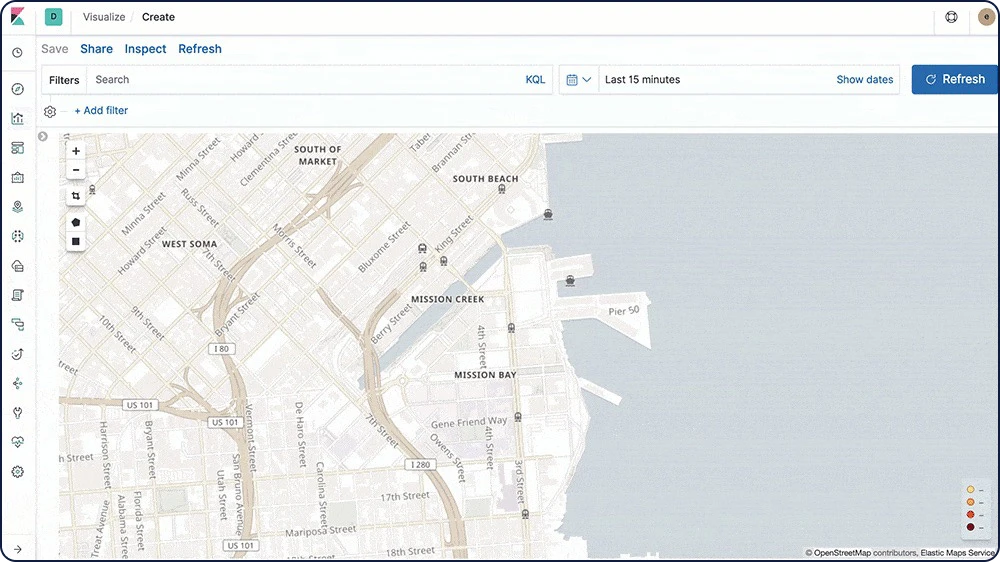

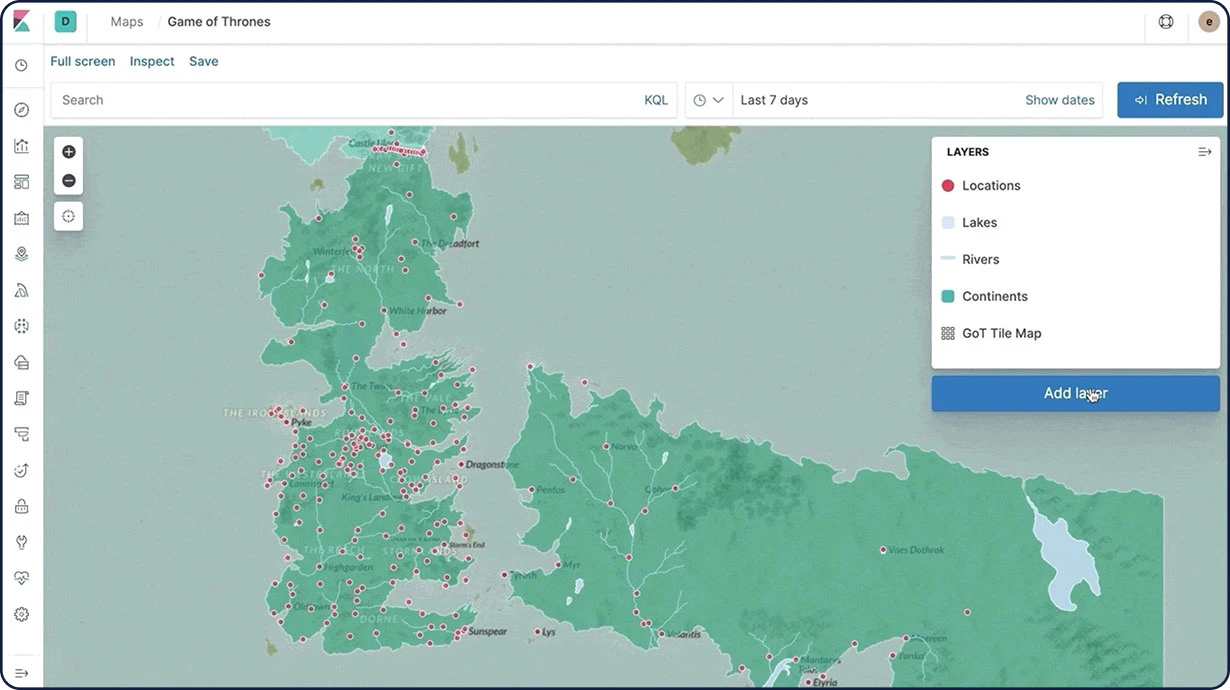

Elastic Maps

Mit der Maps-App können Sie Ihre geografischen Daten in großem Umfang schnell und in Echtzeit verarbeiten. Fügen Sie mehrere Ebenen und Indizes zu einer Karte hinzu, drucken Sie Rohdokumente, wenden Sie Stilvorlagen im Client an und suchen Sie global in mehreren Ebenen, um Ihre Daten mühelos zu verstehen und zu überwachen.

Kartenebenen

Mit der Maps-App in Kibana können Sie Ebenen für einzelne Indizes zu Landkarten hinzufügen. Da über ein und dieselbe Karte mehrere Ebenen gelegt werden können, haben Sie die Möglichkeit, alle Ebenen auf einmal zu durchsuchen und zu filtern – in Echtzeit. Nutzen Sie Chloropethenebenen, Wärmekartenebenen, Kachelebenen, Vektorebenen und sogar Ebenen für bestimmte Anwendungsfälle wie etwa Observability für APM-Daten.

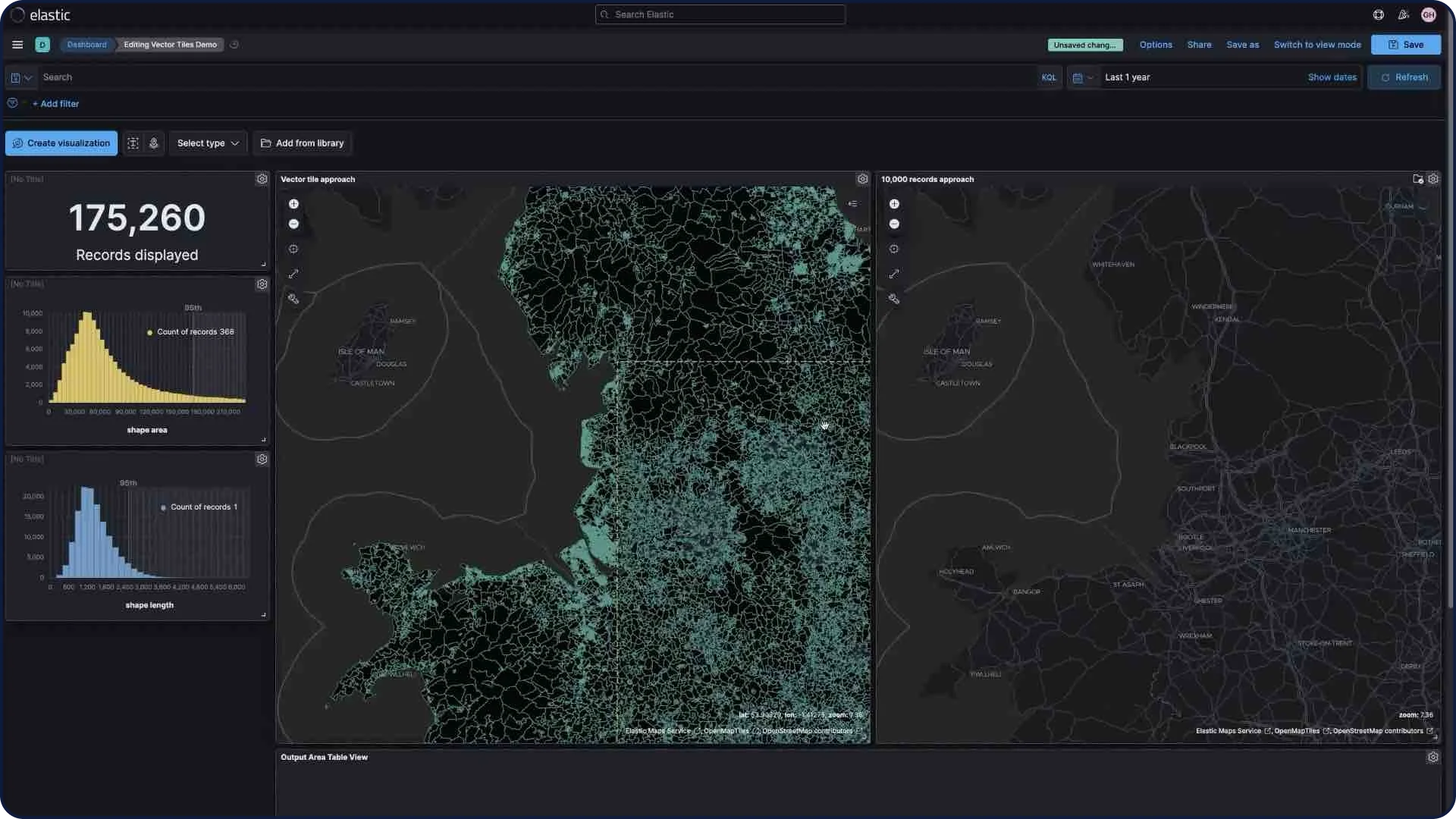

Vektorkacheln

Mit den Vektorkacheln können Sie Ihre Karte in Kacheln aufteilen und so besser als bei vergleichbaren Alternativen schnell in den Kacheln navigieren und unterbrechungsfrei zoomen. Bei allen neuen Polygonebenen ist die Einstellung „Use vector tiles“ (Vektorkacheln verwenden) standardmäßig aktiviert. Wenn Sie die 10.000-Datensätze-Methode vorziehen, können Sie die Skalierungsoptionen in den Ebeneneinstellungen anpassen.

Individuelle Regionskarten

Regionskarten sind thematische Karten, in denen umgrenzte Vektorformen mit einem Farbverlauf eingefärbt werden, und mit denen Sie individuelle Positionsdaten mit einem Schema Ihrer Wahl darstellen können.

Elastic Maps Service (Vergrößerungsstufen)

Der Elastic Maps Service dient als Basis für alle Geodaten-Visualisierungen in Kibana (inklusive der Maps-App) und stellt Grundkarten-Kacheln, Shapefiles und andere wichtige Funktionen für die Darstellung von Geodaten bereit. Mit der Kibana-Standarddistribution können Sie in eine Karte bis ins 18-fache reinzoomen.

Elastic Maps Server

Der Elastic Maps Server ermöglicht die Verwendung der Elastic Maps Service-Grundkarten und ‑Grenzen auf der lokalen Infrastruktur.

GeoJSON-Upload

Die GeoJSON-Upload-Funktion ist trotz aller Einfachheit und Benutzerfreundlichkeit äußerst robust. Durch die direkte Erfassung in Elasticsearch versetzt das Feature Kartenersteller in die Lage, GeoJSON-Dateien, die mit Punkten, Formen und Inhalten angereichert wurden, per Drag-and-Drop in Karten zu ziehen und so Daten schnell und einfach zu visualisieren. Mithilfe von mit GeoJSON definierten Grenzen können Sie E‑Mail- oder Webanwendungs-Alerts für die Verfolgung datengesteuerter Objektbewegungen einrichten.

Geo-Alerts

Sie können festlegen, dass Sie benachrichtigt werden, sobald eine geografische Grenze überschritten wird – ganz gleich, ob von außen nach innen oder umgekehrt. Außerdem können Sie die aktuelle Position eines Objekts innerhalb einer festgelegten Grenze überwachen.

Upload von Shapefiles

Die Maps-Anwendung enthält eine integrierte Funktion für das Hochladen von Shapefiles, die so einfach wie leistungsfähig ist. Laden Sie einfach und schnell lokale offene Daten und Grenzen, um sie analysieren und vergleichen zu können.

Erkunden und visualisieren

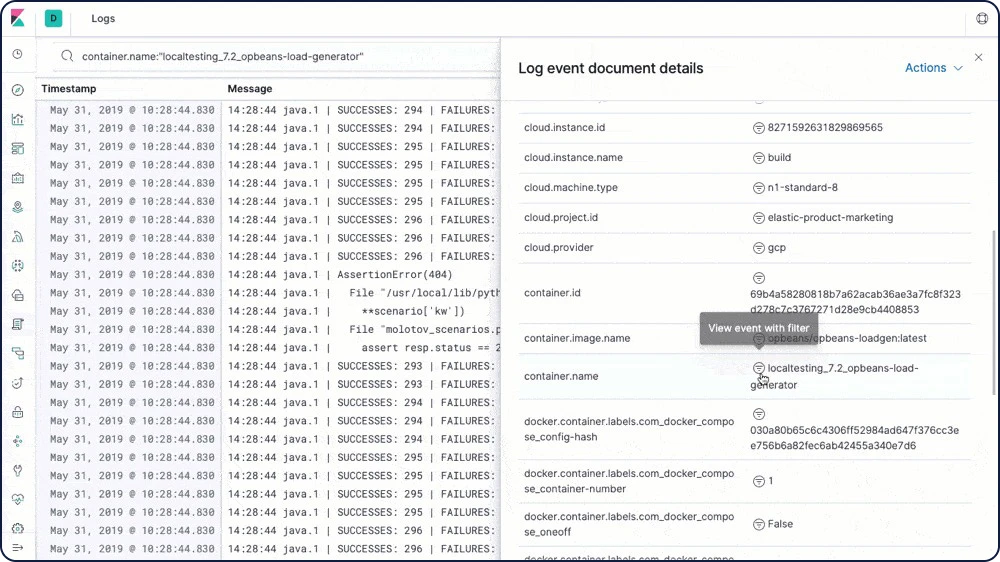

Elastic Logs

Mit integrierter Unterstützung für verbreitete Datenquellen und Standard-Dashboards bietet der Elastic Stack ein Rundum-Sorglos-Paket. Senden Sie Log-Daten mit Filebeat und Winlogbeat, indexieren Sie sie in Elasticsearch und visualisieren Sie alles in Minutenschnelle in Kibana.

Log-Shipper (Filebeat)

Filebeat hilft Ihnen dabei, Einfaches einfach zu halten, indem es Ihre Logs und Dateien unkompliziert und schnell weiterleitet und zentralisiert. Filebeat verfügt über integrierte Module (aktuell unter anderem für auditd, Apache, NGINX, System und MySQL), die das Erfassen, Parsen und Visualisieren von Daten aus verbreiteten Log-Formaten so weit vereinfachen, dass diese Schritte mit einem einzigen Befehl gestartet werden können.

Logs-Dashboards

Mit den Beispielen für Filebeat-Dashboards können Sie Ihre Protokolldaten in Kibana mühelos erkunden. Verwenden Sie diese vorkonfigurierten Dashboards als Ausgangspunkt und passen Sie sie an Ihre eigenen Anforderungen an.

Anomalieerkennung bei Logrates

Die Machine-Learning-gestützte Analyse von Logrates weist auf Zeiträume hin, in denen die Lograte außerhalb des Üblichen liegt, sodass Sie Anomalien schnell identifizieren und untersuchen können.

Logs-App

Mit der Logs-App können Sie Protokolldaten in Echtzeit in einer kompakten und individuell anpassbaren Anzeige überwachen. Die Protokolldaten werden mit den Metriken in der Metrics-App in Beziehung gesetzt, sodass sich Probleme leichter diagnostizieren lassen.

Erkunden und visualisieren

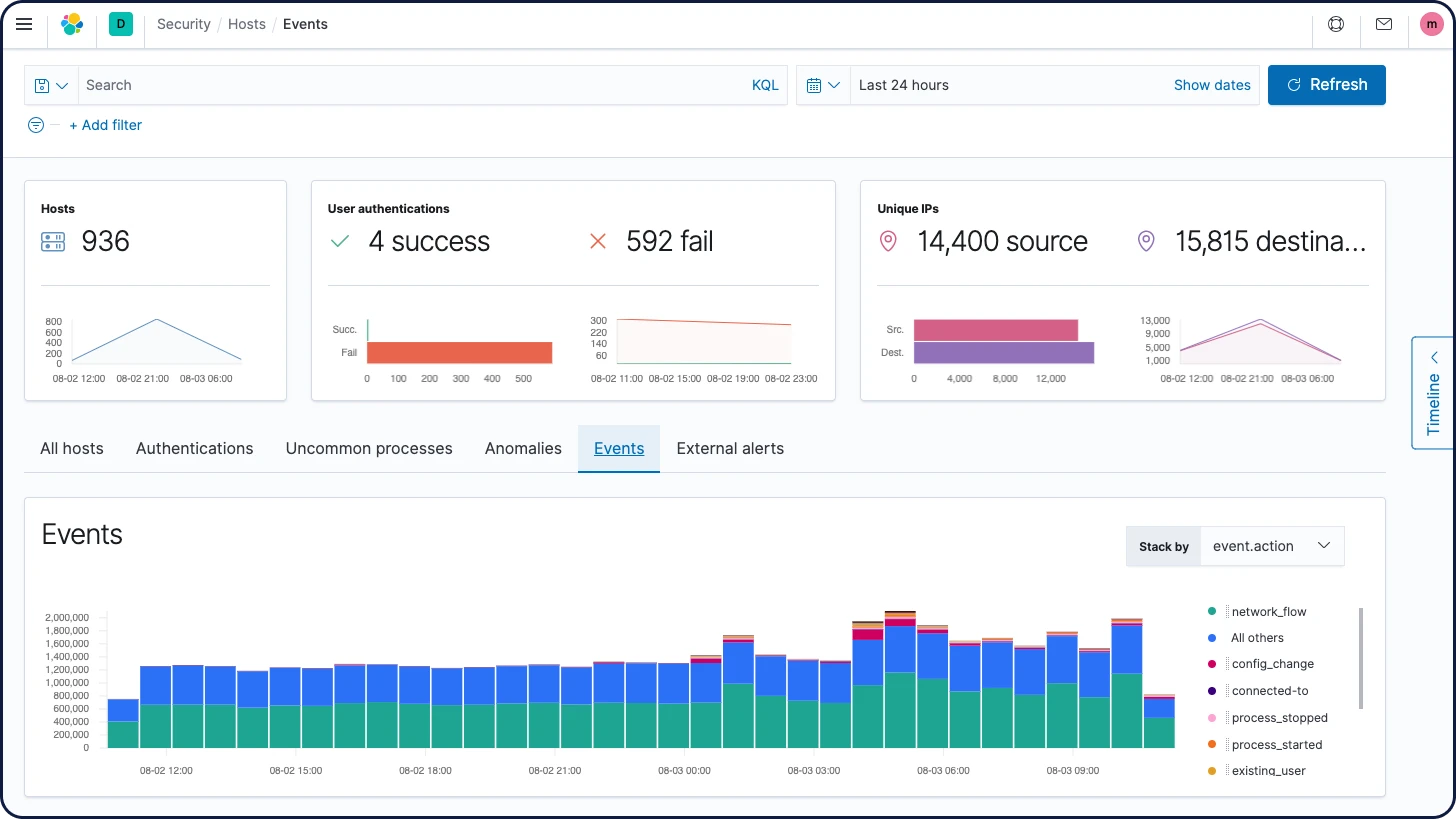

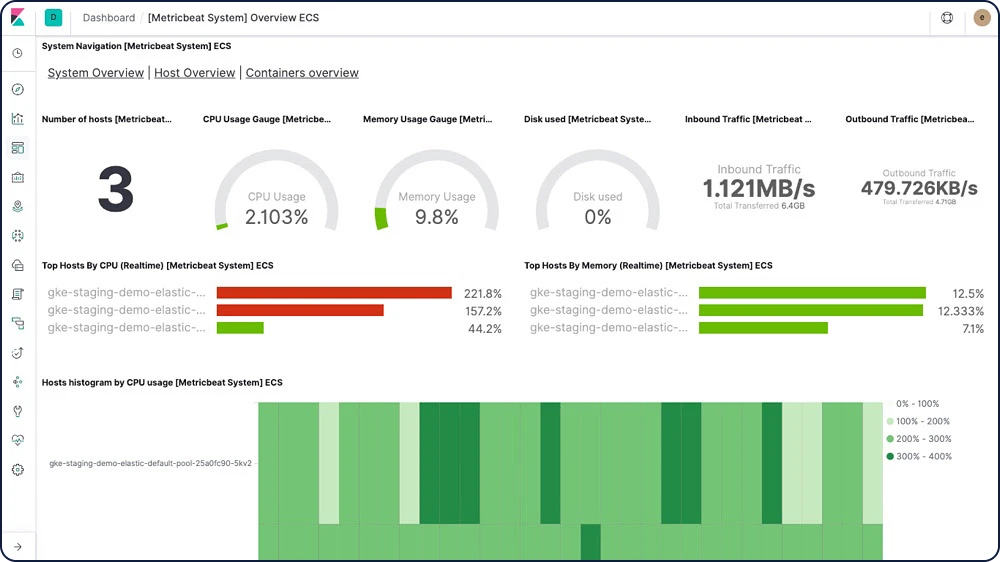

Elastic Metrics

Mit Elastic Metrics können Sie wichtige Metriken, wie CPU-Auslastung, Systemlast, Speicherverbrauch und Netzwerkverkehr, problemlos überwachen, um sich einen Überblick über die allgemeine Integrität Ihrer Server, Container und Dienste zu verschaffen.

Metric Shipper (Metricbeat)

Metricbeat ist ein leichtgewichtiger Shipper, den Sie auf Ihren Servern installieren können, um regelmäßig Metriken für das Betriebssystem und die auf dem Server ausgeführten Dienste zu erfassen. CPU, Speicher, Redis oder NGINX: Metricbeat ist ein leichtgewichtiger Shipper, der System- und Dienststatistiken an das gewünschte Ziel sendet.

Metriken-Dashboards

Wir stellen Beispiele für Metricbeat-Dashboards bereit, die Ihnen dabei helfen, sich schnell mit der Überwachung von Servern in Kibana vertraut zu machen. Verwenden Sie diese vorkonfigurierten Dashboards als Ausgangspunkt und passen Sie sie an Ihre eigenen Anforderungen an.

Alerting-Integration für Metrics

Richten Sie in der Metrics-App in Kibana Schwellenwert-Alerts für Ihre Metriken mit Echtzeit-Feedback ein und legen Sie fest, wie Sie benachrichtigt werden möchten – Dokumente, Logs, Slack, einfache Webhooks und mehr.

Machine-Learning-Integration für Elastic Metrics

Elastic Metrics ermöglicht dank 1‑Klick-Anomalieerkennung das schnelle Aufspüren geläufiger Infrastrukturprobleme.

Metrics-App

Nachdem Sie Metriken zu Elasticsearch gestreamt haben, können Sie die Metrics-App in Kibana verwenden, um die Metriken in Echtzeit zu überwachen und Probleme zu identifizieren.

Erkunden und visualisieren

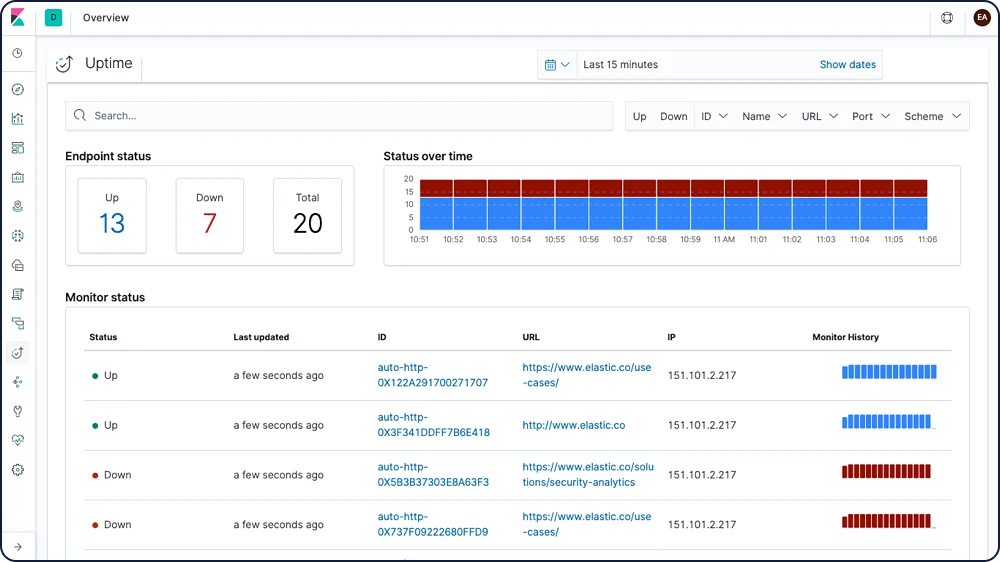

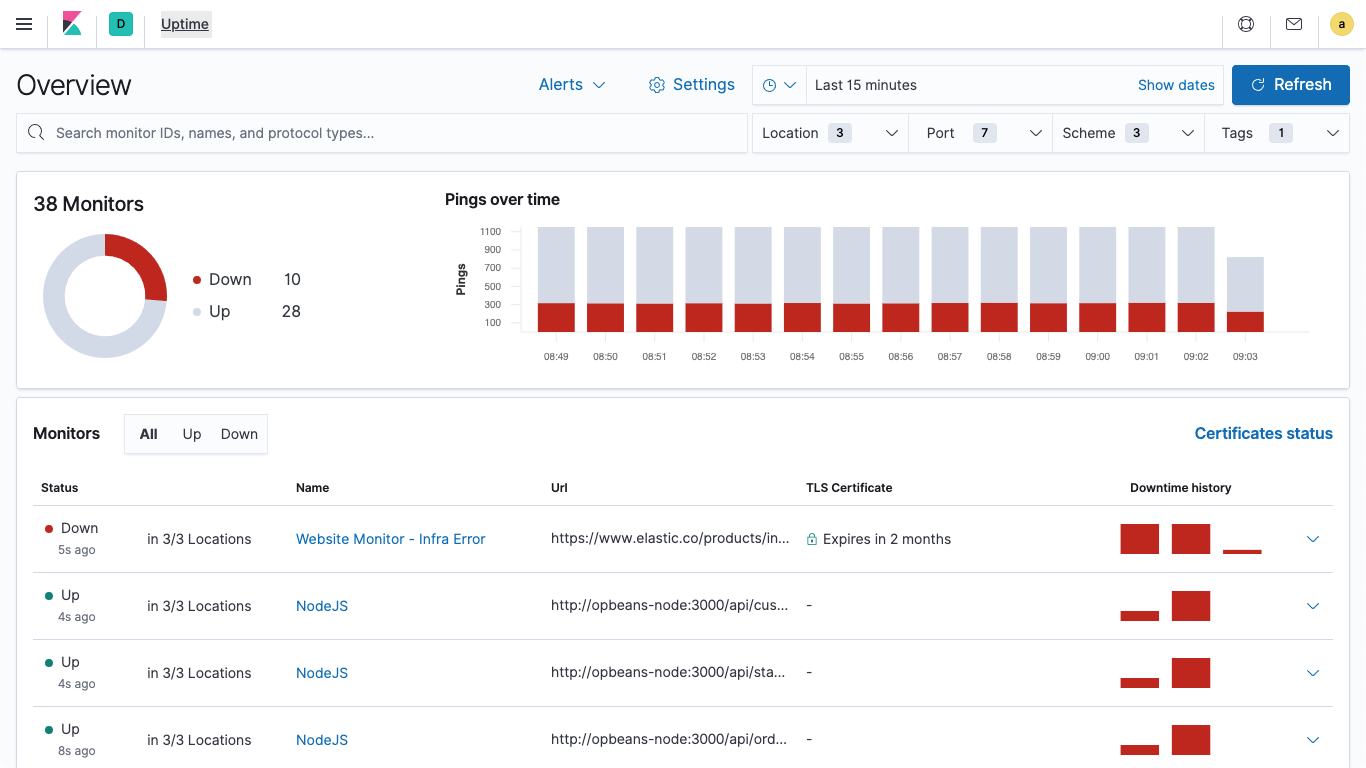

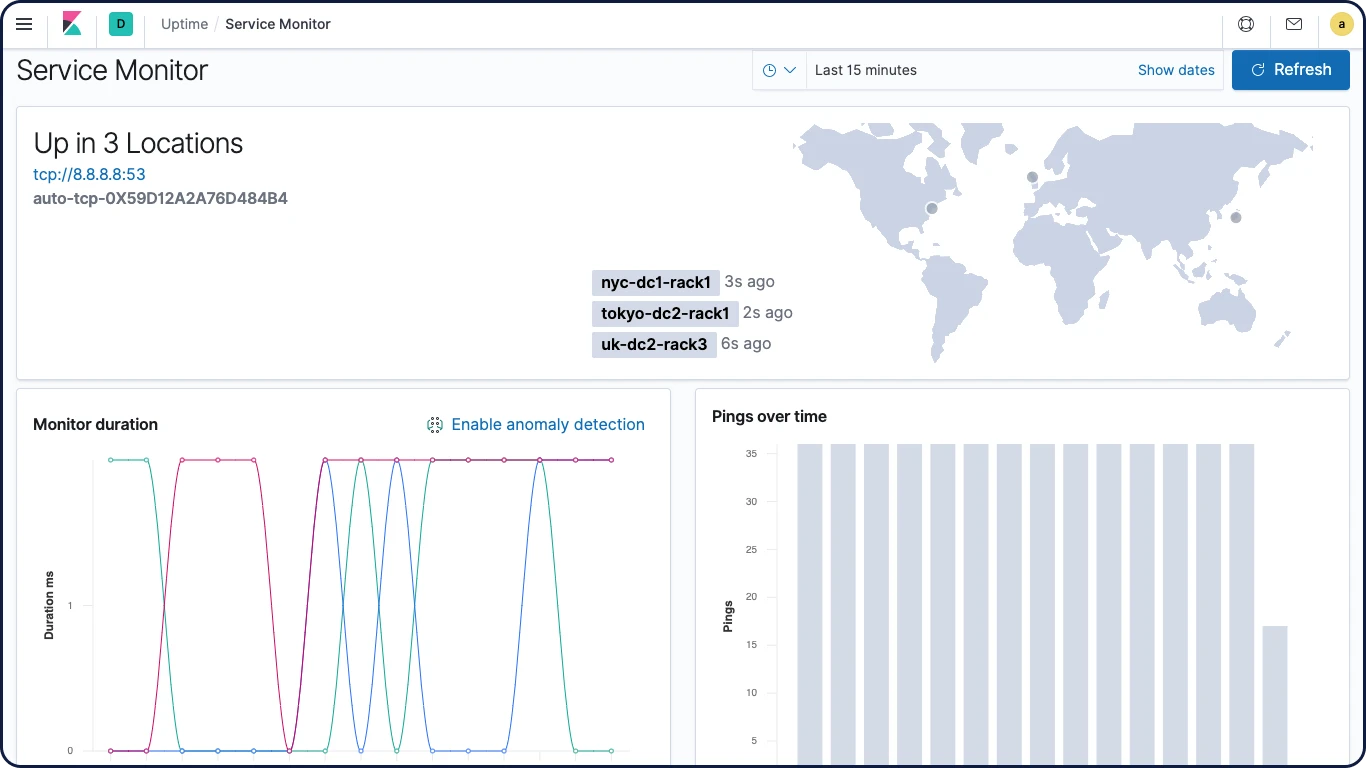

Elastic Uptime

Elastic Uptime basiert auf der Open-Source-Lösung Heartbeat und verarbeitet Ihre Verfügbarkeitsdaten zusammen mit Kontextinformationen aus Log-Daten, Metriken und APM-Daten. Auf diese Weise können Sie Punkte leichter verbinden, Aktivitäten korrelieren und Probleme schneller lösen.

Uptime-Monitor (Heartbeat)

Heartbeat ist ein leichtgewichtiger Daemon, den Sie auf einem Remoteserver installieren können, um den Status und die Verfügbarkeit Ihrer Dienste regelmäßig zu überprüfen. Heartbeat erfasst die Serverdaten und zeigt sie anschließend im Uptime-Dashboard und in der App in Kibana an.

Uptime-Dashboards

Mit den Beispielen für Heartbeat-Dashboards können Sie den Status Ihrer Dienste mühelos in Kibana visualisieren. Verwenden Sie diese vorkonfigurierten Dashboards als Ausgangspunkt und passen Sie sie an Ihre eigenen Anforderungen an.

Alerting-Integration für Uptime

Richten Sie direkt in der Uptime-App schwellenwertbasierte Alerts für Ihre Verfügbarkeitsdaten ein und legen Sie fest, wie Sie benachrichtigt werden möchten – Dokumente, Logs, Slack, einfache Webhooks und mehr.

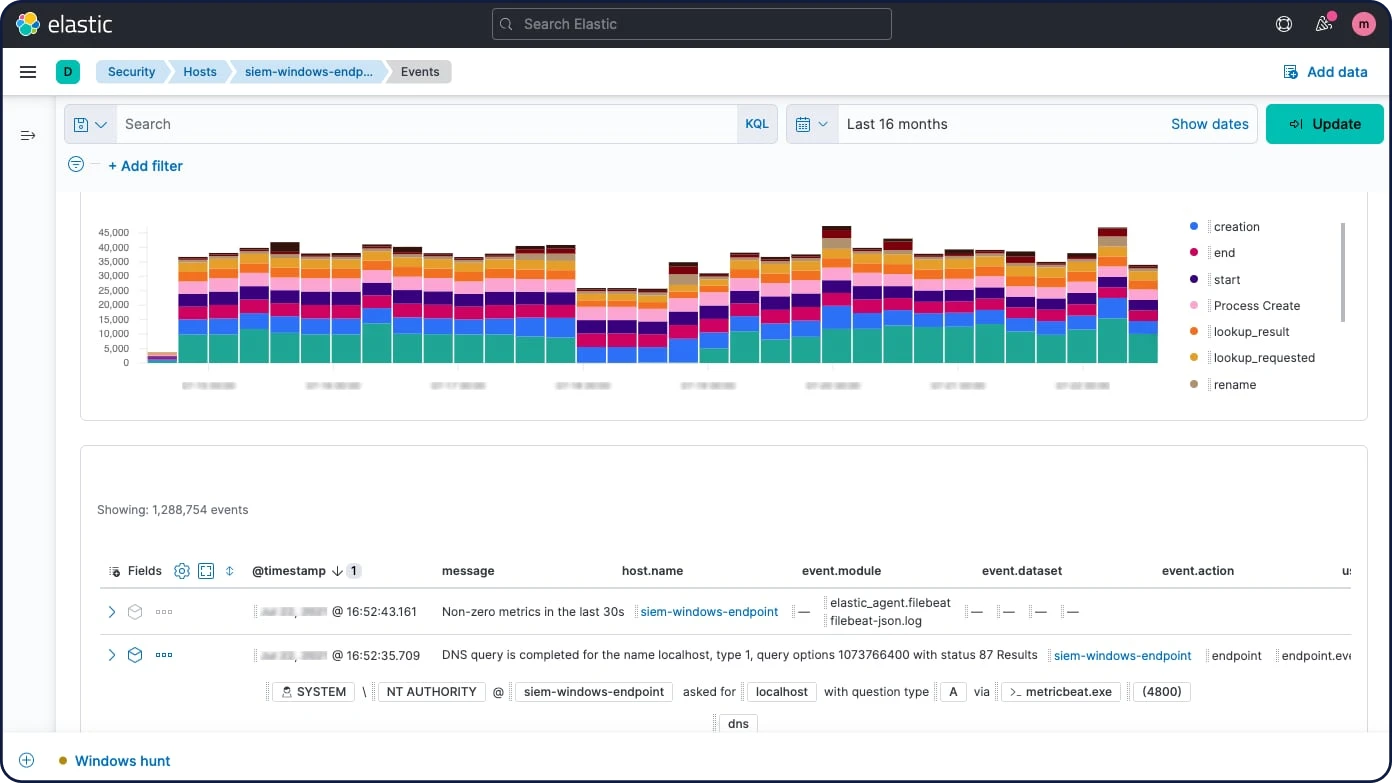

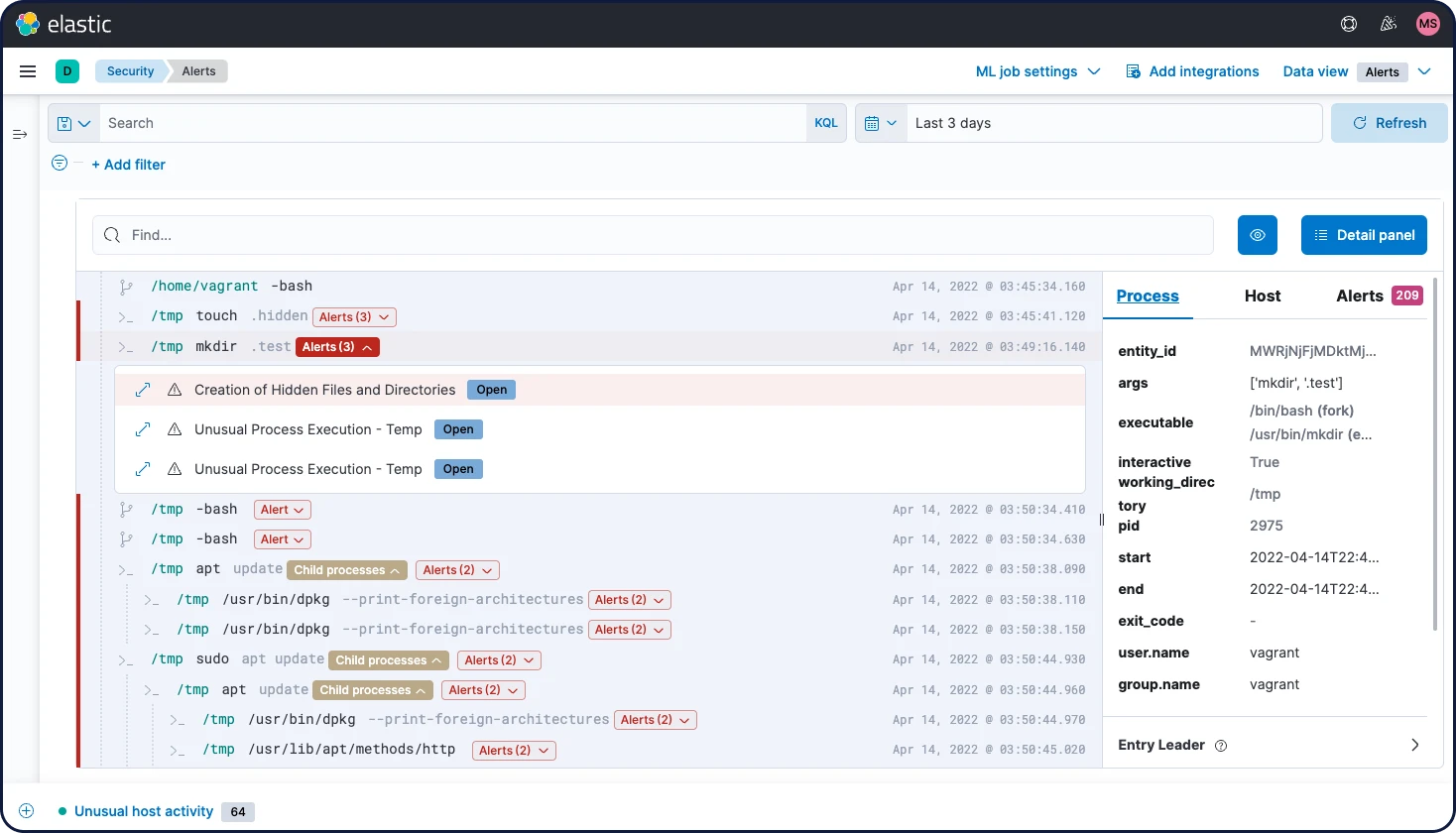

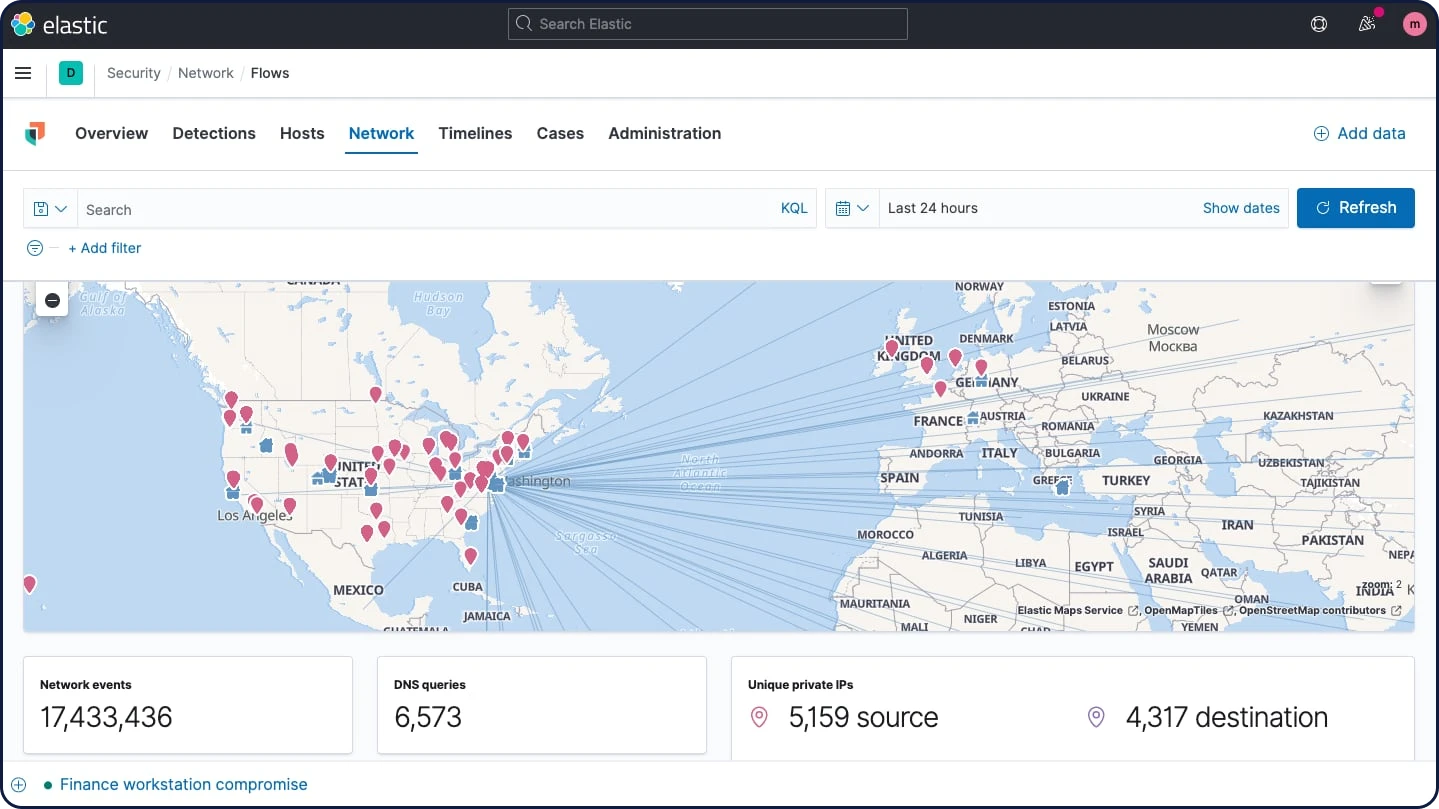

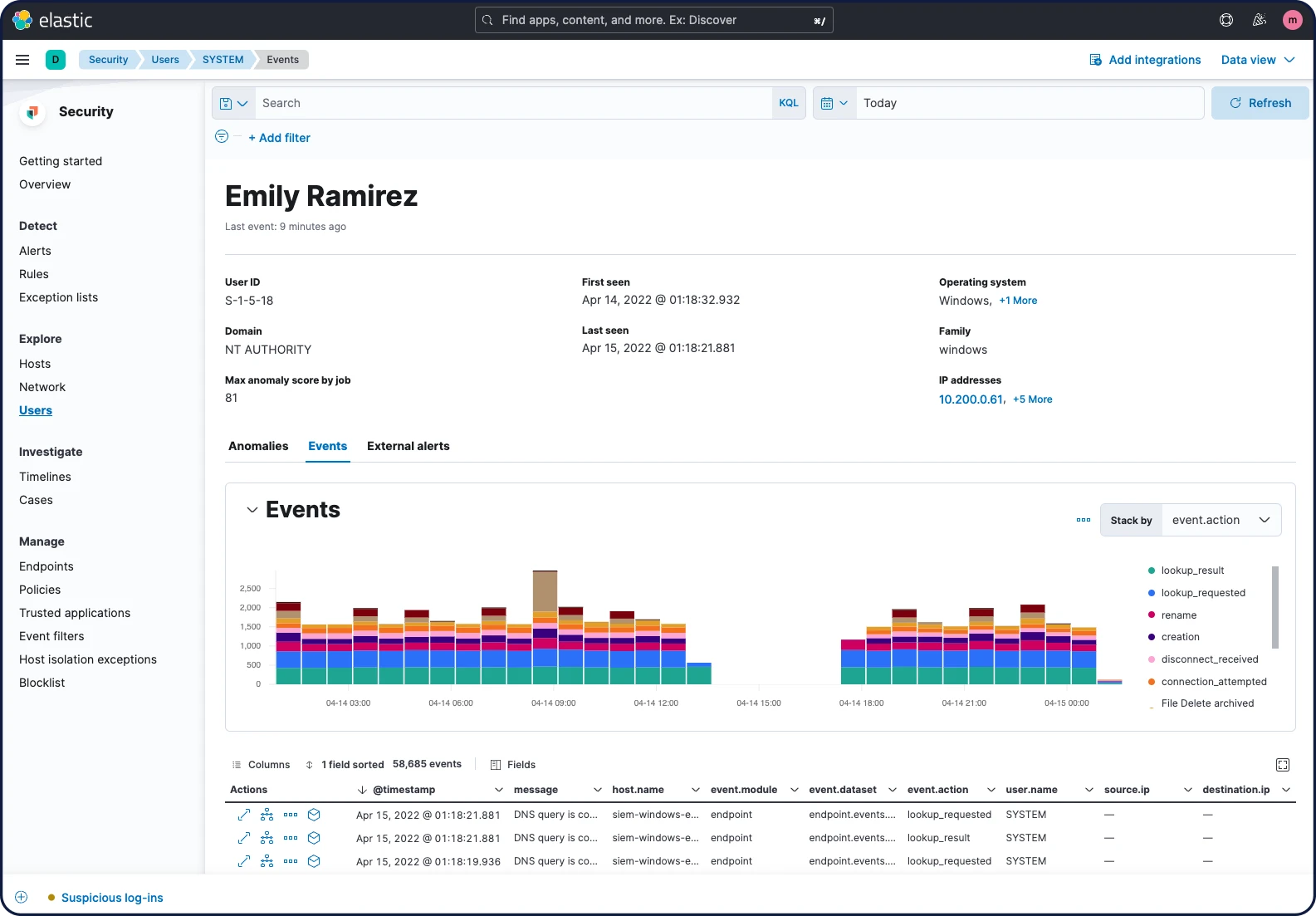

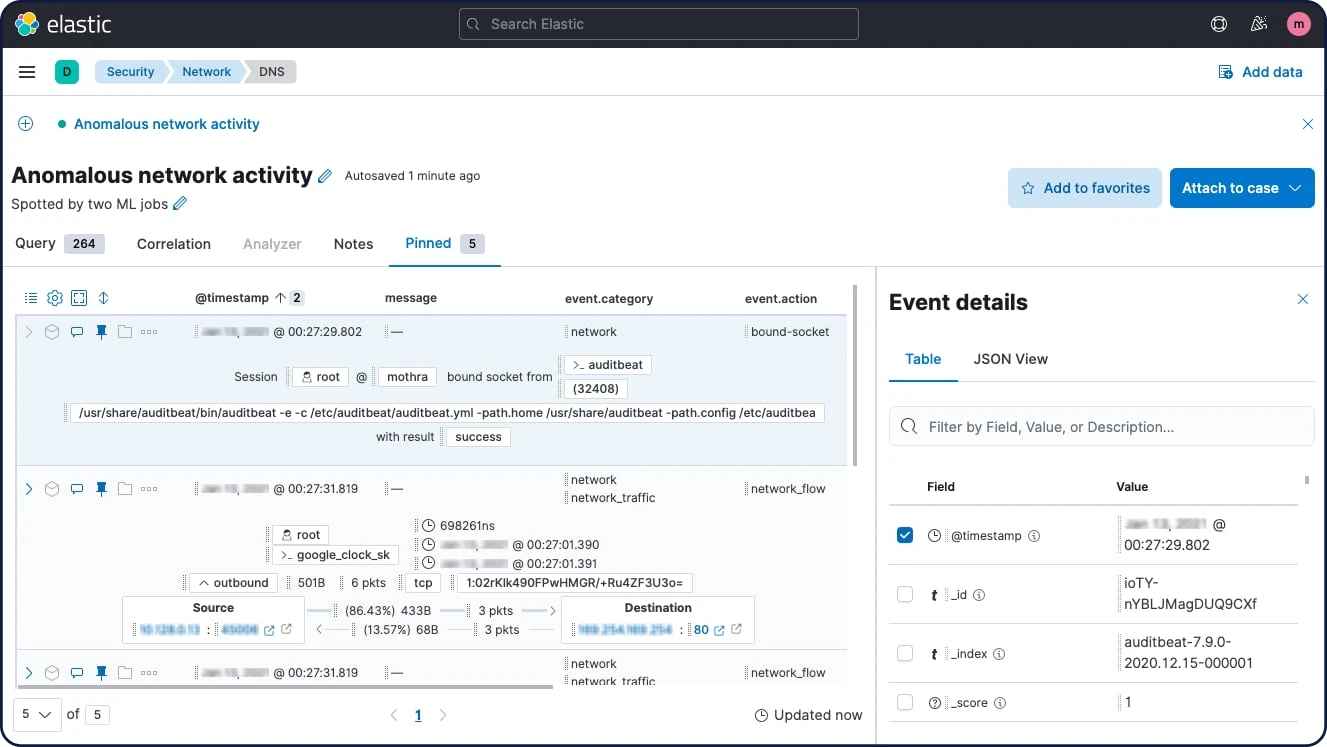

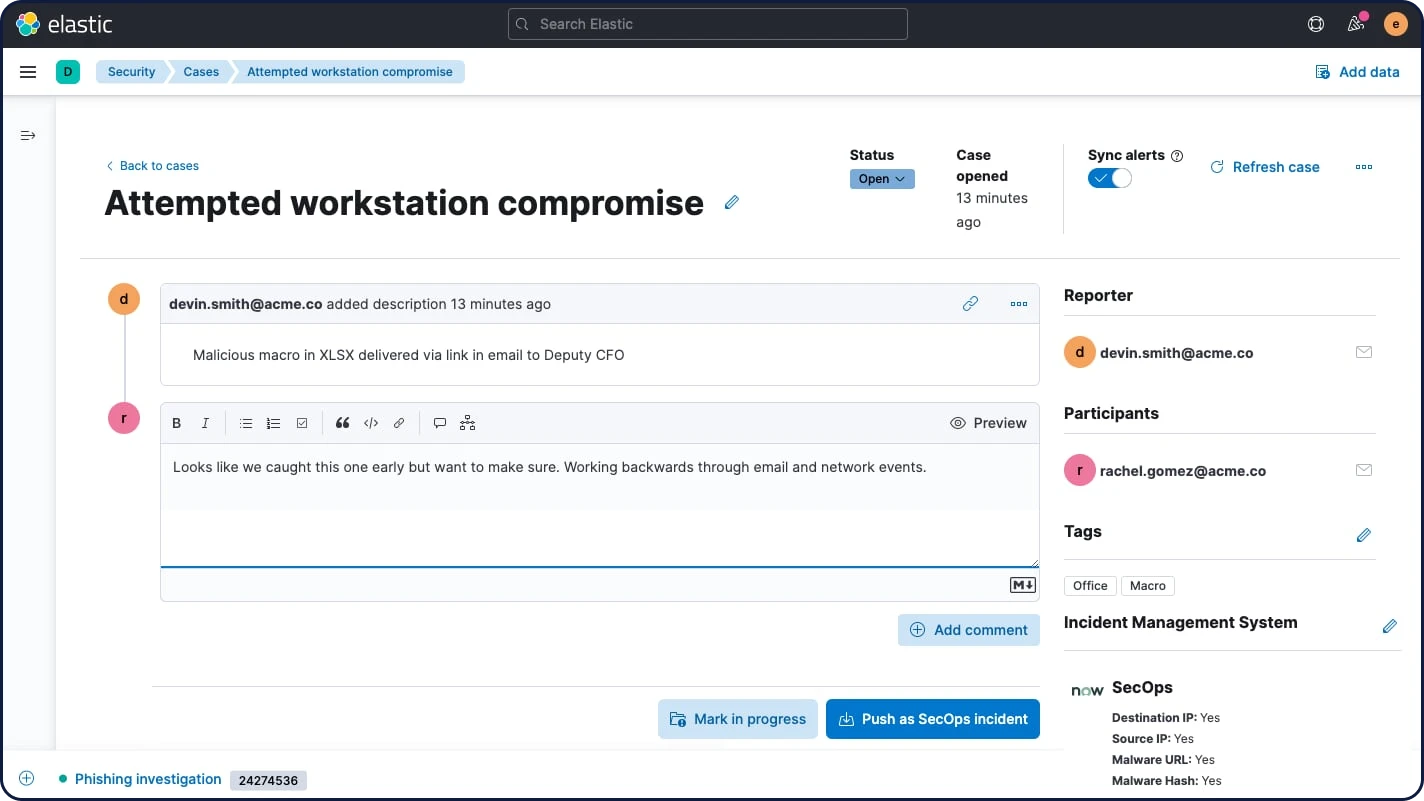

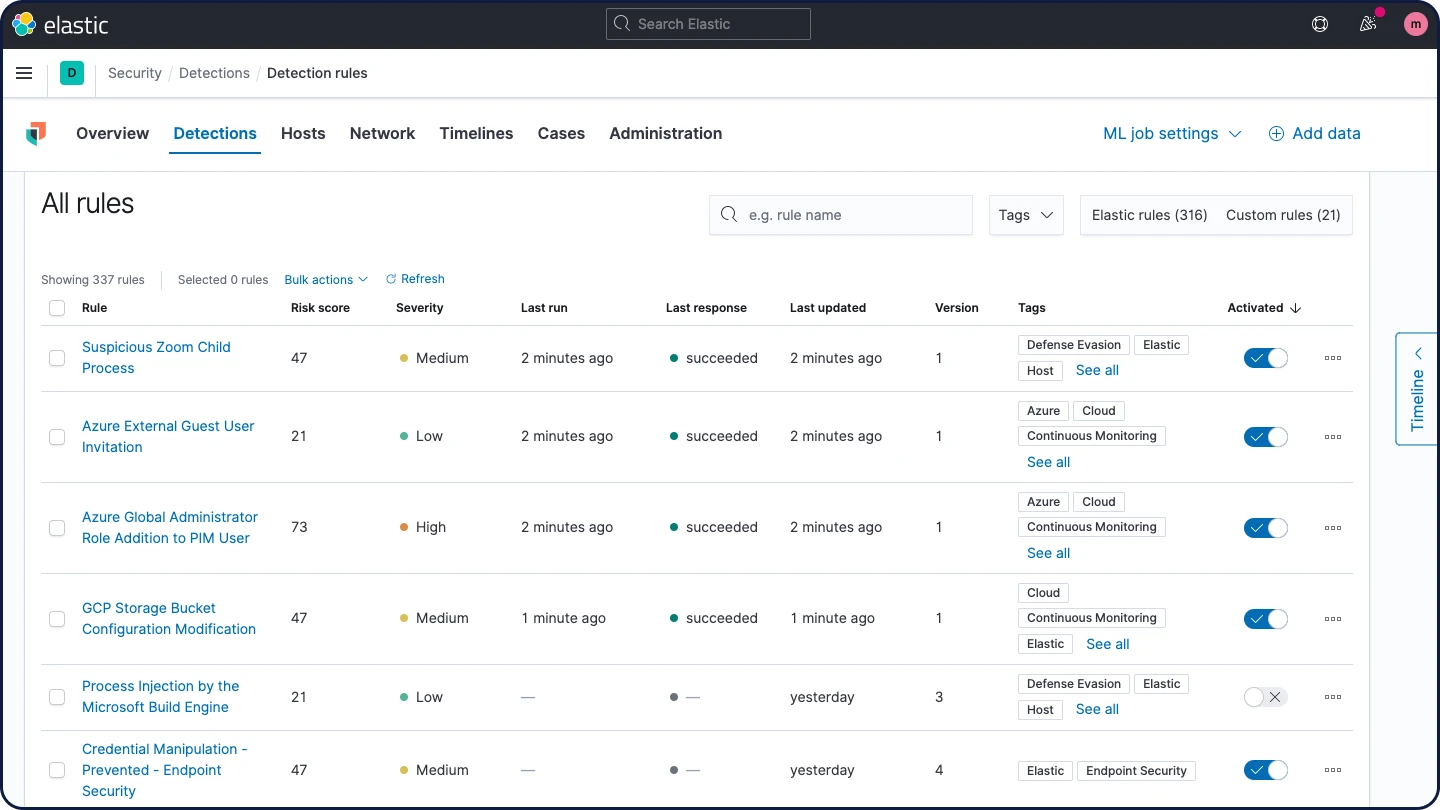

Zertifikatüberwachung