Quand informations et contexte s'associent avec Elastic AI Assistant pour Elastic Observability

Elastic® a décidé de renforcer Elastic AI Assistant, l'assistant d'IA générative adossé à Elasticsearch Relevance Engine™ (ESRE). Le but : permettre une analyse plus poussée en matière d'observabilité et aider les utilisateurs, quel que soit leur niveau de compétence. Elastic AI Assistant (en préversion technique dans Elastic Observability) révolutionne l'identification et la résolution des problèmes en éliminant la recherche manuelle de données dispersées dans des silos à l'aide d'un assistant interactif qui fournit des informations contextuelles aux SRE.

Elastic AI Assistant facilite la compréhension des erreurs d'application, l'interprétation des messages log, l'analyse des alertes et la formulation de suggestions pour améliorer le code. En outre, l'interface de tchat interactif d'Elastic AI Assistant permet aux SRE de discuter et de visualiser l'ensemble des données télémétriques pertinentes dans un seul emplacement tout en exploitant les runbooks et les données propriétaires pour plus de contexte.

Elastic AI Assistant est configuré pour se connecter au LLM de votre choix, tel qu'OpenAI ou Azure OpenAI, mais ce n'est pas tout. Vous pouvez aussi lui fournir des informations privées. Il peut s'agir notamment de runbooks, de l'historique des incidents passés ou d'un incident en cours, et bien d'autres éléments. À l'aide d'un processeur d'inférence propulsé par Elastic Learned Sparse EncodeR (ELSER), Elastic AI Assistant accède aux données les plus pertinentes pour répondre à des questions précises ou réaliser des tâches spécifiques.

Elastic AI Assistant est capable d'apprendre et peut donc alimenter sa base de connaissances grâce à une utilisation continue. Les SRE peuvent donner à l'assistant des informations sur un problème spécifique, afin qu'il puisse fournir un support dans le cas où cet incident surviendrait ultérieurement et qu'il puisse aider à établir des rapports de panne, à mettre à jour les runbooks et à améliorer l'analyse automatisée de la cause première. Les SRE peuvent détecter et résoudre les problèmes plus rapidement et de manière proactive en combinant les forces d'Elastic AI Assistant et du Machine Learning et en éliminant la récupération manuelle de données dispersées dans des silos, et donner ainsi un coup de boost à l'AIOps.

Dans cet article, nous présenterons quelques-unes des fonctionnalités initiales disponibles dans la préversion technique d'Elastic 8.10 :

- Fonctionnalité de tchat disponible sur n'importe quel écran dans Elastic

- Requêtes spécifiques prédéfinies des LLM afin d'obtenir des informations contextuelles pour :

- comprendre la signification du message dans un log ;

- obtenir de meilleures options pour traiter les erreurs rencontrées par les services gérés par Elastic APM ;

- obtenir plus de contexte et apprendre à s'en servir dans le cadre des alertes de log ;

- comprendre comment optimiser le code dans Universal Profiling ;

- comprendre quels processus se trouvent dans les hôtes monitorés dans Elastic.

Si vous le souhaitez, vous pouvez aussi regarder la vidéo ci-dessous pour en savoir plus sur les fonctionnalités dans le scénario que nous allons étudier.

Elastic AI Assistant pour Elastic Observability

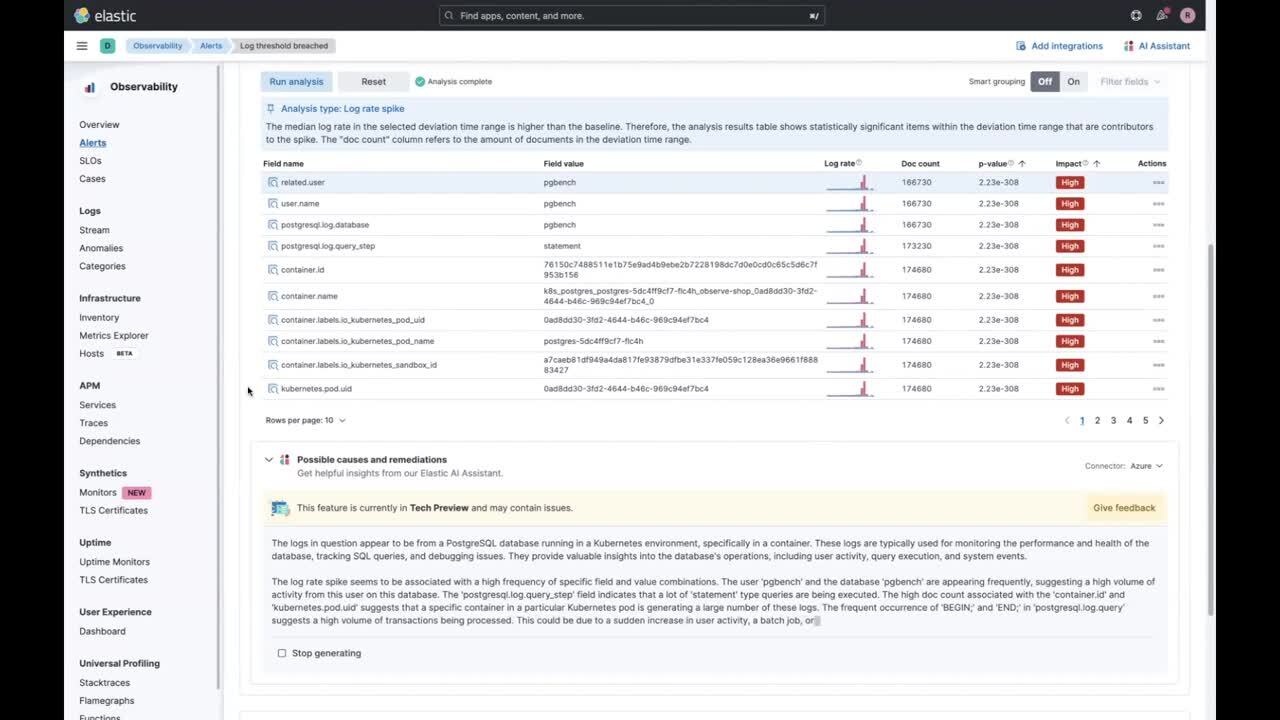

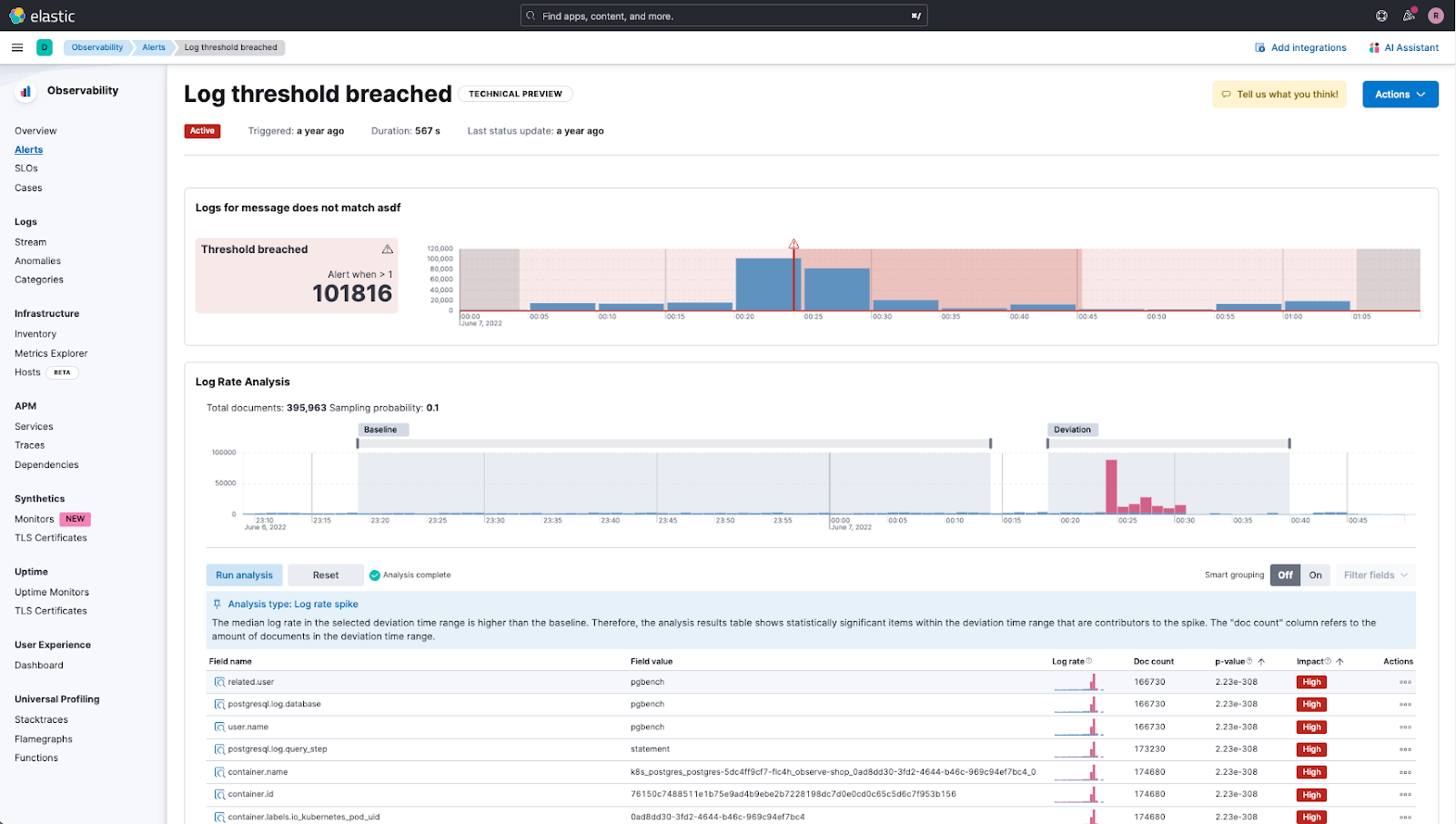

Vous êtes SRE et vous recevez une alerte indiquant que le seuil du nombre d'entrées de logs a été dépassé. Dans Elastic Observability, non seulement vous obtenez l'alerte, mais vous pouvez aussi voir une analyse des pics de logs en temps réel afin que vous puissiez mieux appréhender le problème.

Utilisation d'Elastic AI Assistant pour analyser un problème

Toutefois, en tant que SRE, vous n'avez pas forcément une compréhension poussée de tous les systèmes dont vous êtes responsable et vous avez besoin d'aide pour étudier l'analyse des pics de logs. C'est là qu'Elastic AI Assistant peut vous aider.

Elastic crée en amont une invite qui est envoyée au LLM que vous avez configuré, ce qui vous permet d'obtenir non seulement la description et le contexte du problème, mais aussi quelques recommandations sur la marche à suivre.

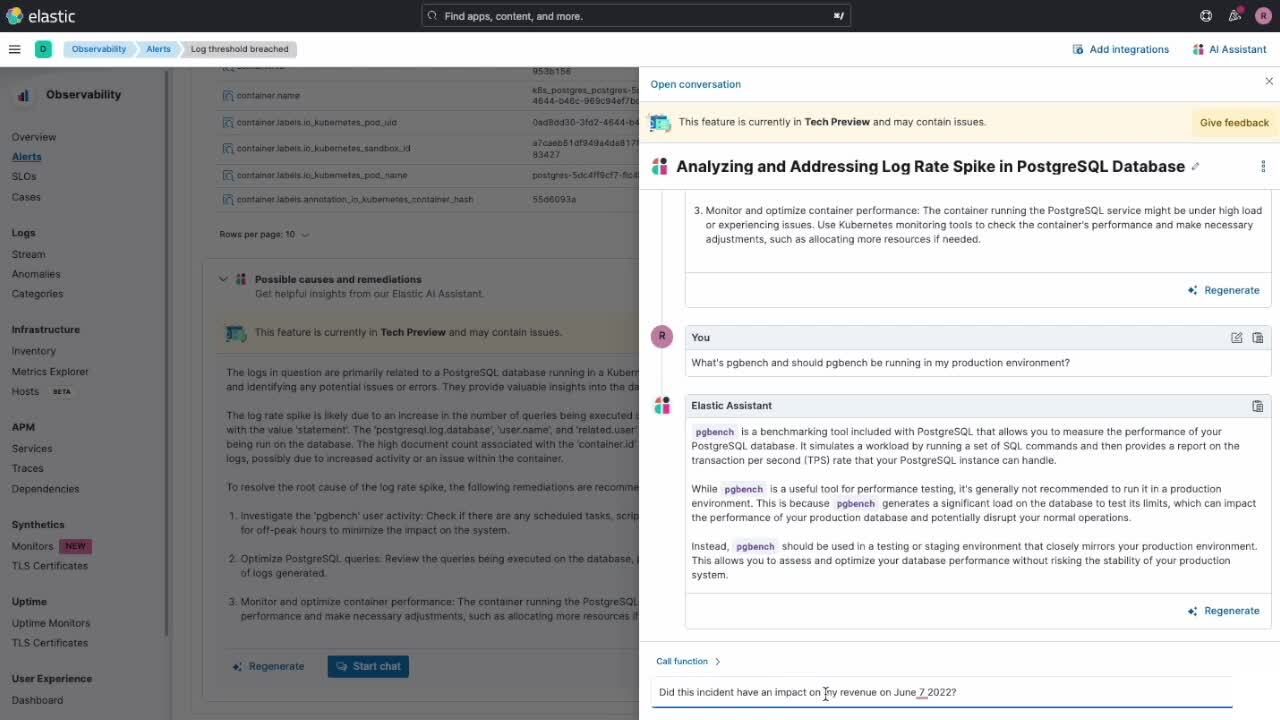

Par ailleurs, vous pouvez lancer un tchat avec Elastic AI Assistant et pousser davantage votre examen.

Comme vous pouvez le voir dans l'animation ci-dessus, non seulement vous pouvez avoir plus d'informations sur le problème "pgbench", mais vous pouvez aussi déterminer quelles sont les répercussions pour votre entreprise en obtenant des informations organisationnelles internes. Dans le cas présent, voilà ce que nous comprenons :

- Comment le changement significatif dans le débit des transactions a pu affecter notre chiffre d'affaires

- Comment le chiffre d'affaires a chuté lorsque ce pic est survenu

Nous avons pu obtenir ces deux éléments d'information grâce à ELSER, qui permet de récupérer des données organisationnelles (privées) pour répondre à des questions spécifiques sur lesquelles les LLM n'ont jamais été entraînés.

Interface conversationnelle d'Elastic AI Assistant

Quelles sont les avantages de l'interface conversationnelle d'Elastic AI Assistant ? Grâce à la fonctionnalité de tchat, vous pouvez lancer une session/conversation avec Elastic AI Assistant, ainsi que :

- utiliser une interface en langage naturel lors de la détermination du problème et de l'analyse de la cause première. Cette interface vous permet de poser des questions naturellement, par exemple : "Y a-t-il des alertes à signaler concernant ce service ?" ou "Pouvez-vous expliquer ce que signifient ces alertes ?" ;

- proposer des conclusions et du contexte, suggérer la marche à suivre et formuler des recommandations en utilisant vos propres données privées internes (à l'aide d'ELSER) et les informations disponibles dans le LLM connecté ;

- étudier les réponses aux requêtes et les résultats des analyses réalisées par Elastic AI Assistant ;

- rappeler et synthétiser les informations tout au long de la conversation ;

- générer des visualisations Lens via la conversation ;

- exécuter les API Kibana® et Elasticsearch® au nom de l'utilisateur via l'interface conversationnelle ;

- effectuer l'analyse de la cause première à l'aide de fonctions APM spécifiques telles que get_apm_timeseries, get_apm_service_summary, get_apm_error_docuements, get_apm_correlations, get_apm_downstream_dependencies, etc.

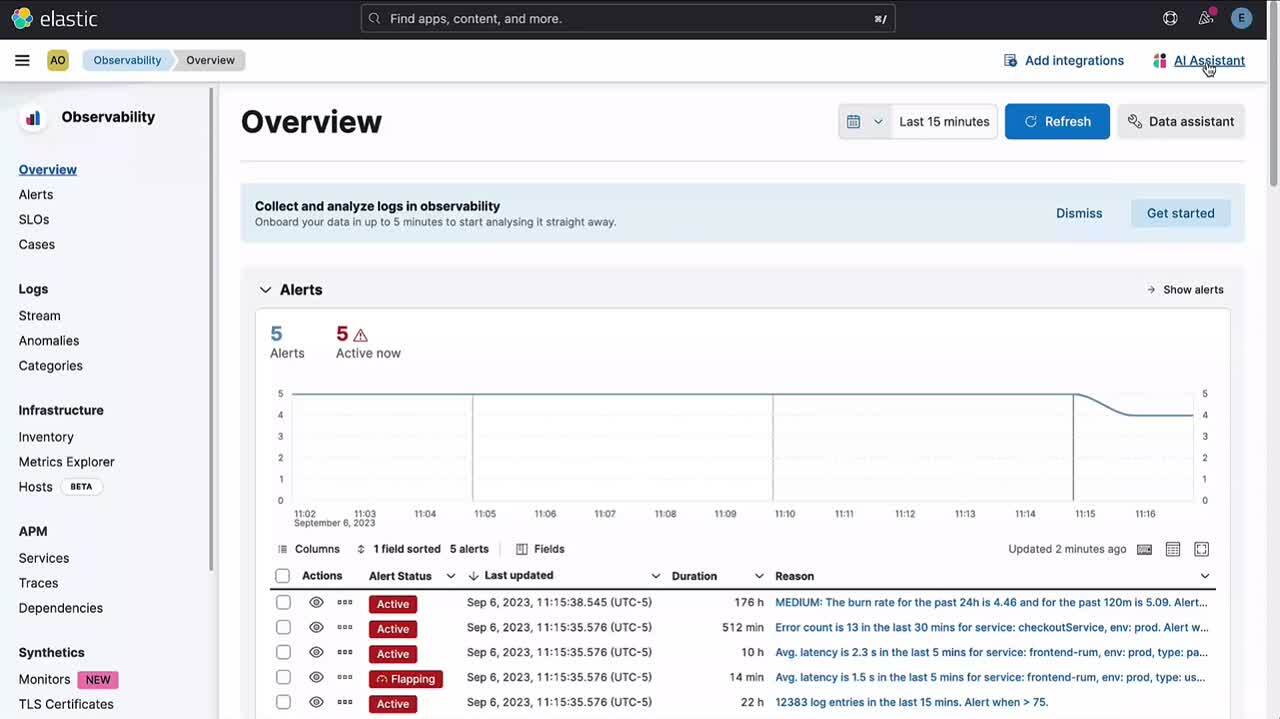

Autres emplacements pour accéder à Elastic AI Assistant

La fonctionnalité de tchat d'Elastic AI Assistant pour Elastic Observability sera accessible à partir de plusieurs emplacements dans Elastic Observability 8.10. D'autres points d'accès seront ajoutés dans les versions à venir.

- Toutes les applications d'Elastic Observability disposent d'un bouton dans le menu d'action situé en haut qui permet d'ouvrir Elastic AI Assistant et de démarrer une conversation :

- Les utilisateurs peuvent accéder aux conversations existantes et en créer de nouvelles lorsqu'ils cliquent sur le lien Go to conversations (Accéder aux conversations) dans Elastic AI Assistant.

La nouvelle fonctionnalité de tchat d'Elastic AI Assistant pour Elastic Observability vient renforcer les capacités introduites dans Elastic Observability 8.9 en offrant la possibilité de démarrer une conversation en lien avec les informations fournies concernant l'APM, le logging, les hôtes, l'alerting et le profilage.

Par exemple :

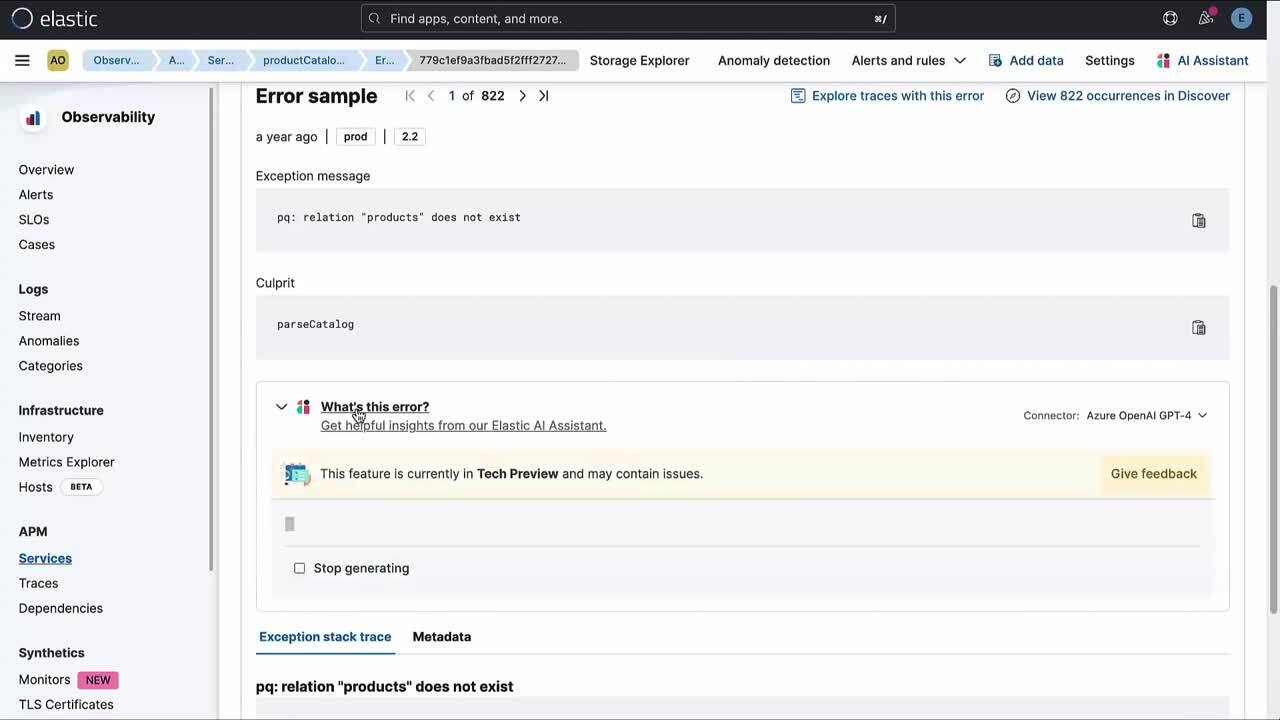

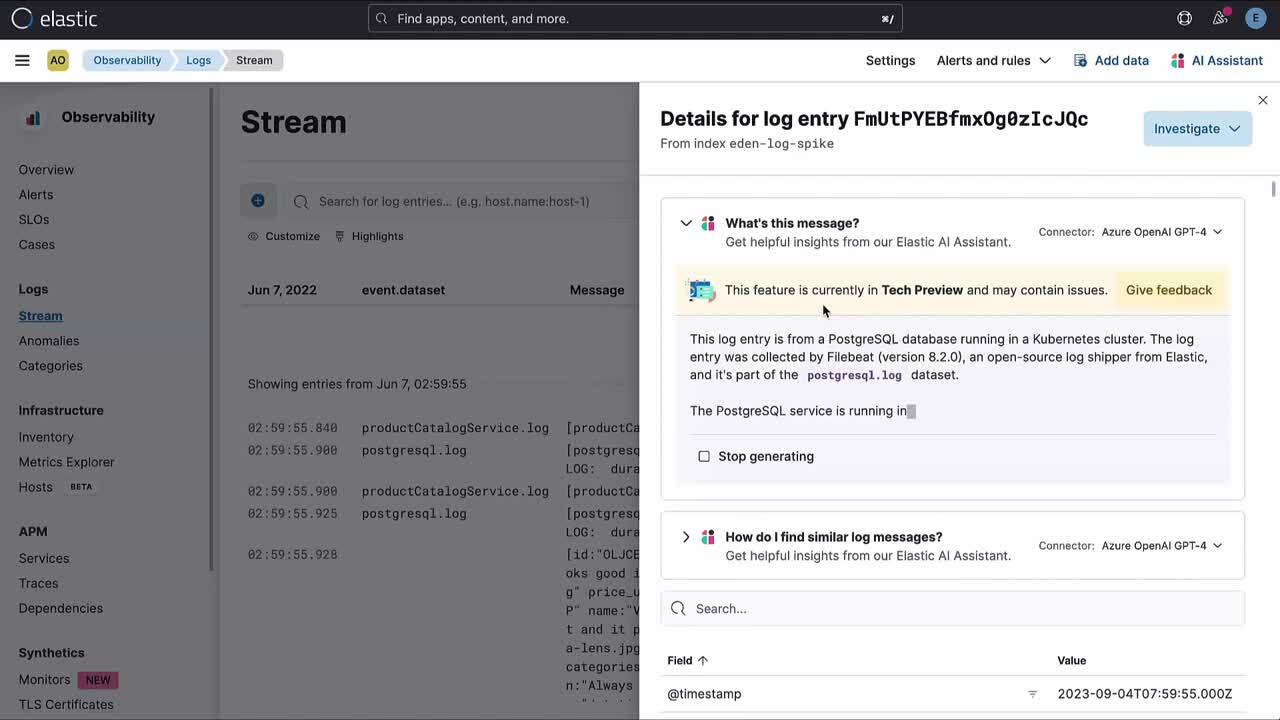

- Concernant l'APM, cette fonctionnalité explique la signification d'une erreur ou d'une exception spécifique et suggère des causes courantes et les effets possibles. Vous pouvez aller plus loin dans votre examen en lançant une conversation.

- Concernant le logging, Elastic AI Assistant lit le log et vous aide à comprendre le message grâce à des informations contextuelles. Vous pouvez aller plus loin dans votre examen en lançant une conversation.

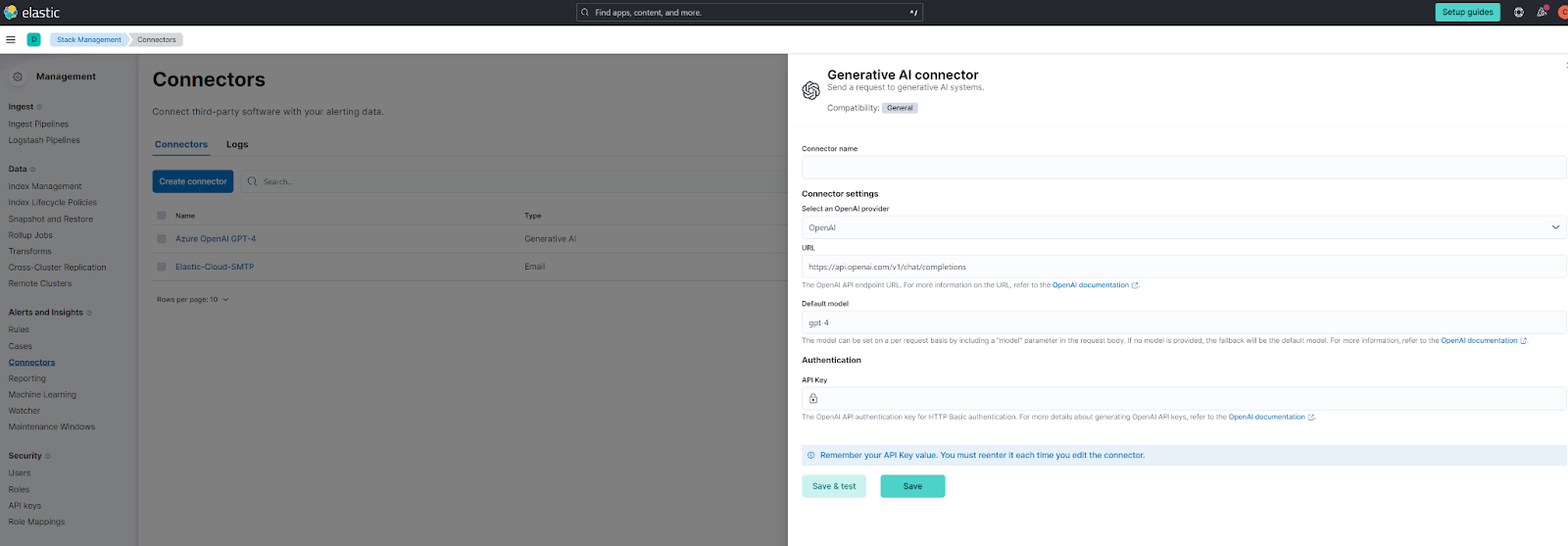

Configuration d'Elastic AI Assistant

Pour en savoir plus sur la configuration d'Elastic AI Assistant, consultez notre documentation.

La configuration se base sur un connecteur et prend initialement en charge les versions OpenAI et Azure OpenAI. Remarque : il est recommandé d'utiliser GPT-4 et il est obligatoire de prendre en charge les appels de fonctions. Si vous utilisez OpenAI directement, vous disposerez automatiquement de ces fonctionnalités. Si vous utilisez la version Azure, veillez à déployer l'un des modèles les plus récents conformément à la documentation Azure.

Vous pouvez aussi configurer cet assistant en utilisant yaml en tant que connecteur prédéfini :

xpack.actions.preconfigured:

open-ai:

actionTypeId: .gen-ai

name: OpenAI

config:

apiUrl: https://api.openai.com/v1/chat/completions

apiProvider: OpenAI

secrets:

apiKey: <myApiKey>

azure-open-ai:

actionTypeId: .gen-ai

name: Azure OpenAI

config:

apiUrl: https://<resourceName>.openai.azure.com/openai/deployments/<deploymentName>/chat/completions?api-version=<apiVersion>

apiProvider: Azure OpenAI

secrets:

apiKey: <myApiKey>Seuls les utilisateurs disposant d'une licence Enterprise peuvent accéder à cette fonctionnalité. En effet, Elastic AI Assistant pour Elastic Observability est en préversion technique et fait partie des fonctionnalités de la licence Enterprise. Si vous n'avez pas cette licence, veuillez effectuer une mise à niveau pour pouvoir utiliser Elastic AI Assistant pour Elastic Observability.

Votre avis est important pour nous ! Vous souhaitez nous faire part de vos commentaires ? Plusieurs moyens sont à votre disposition : avec le formulaire disponible dans Elastic AI Assistant, sur les forums de discussion (concernant Elastic AI Assistant ou les opérations d'IA) et/ou via le canal Slack de la communauté Elastic (#observability-ai-assistant).

Pour terminer, nous souhaitions souligner le fait que cette fonctionnalité est toujours en préversion technique. En raison de la nature des grands modèles de langage, cet assistant peut se comporter de façon inattendue par moments. Face à une même situation, il peut avoir deux réactions différentes. Il peut aussi vous indiquer qu'il est incapable de vous aider, alors qu'il devrait pouvoir répondre à la question que vous lui avez posée.

Nous mettons donc tout en œuvre pour renforcer l'assistant par rapport à ces dysfonctionnements, pour le rendre plus prévisible, et de manière générale, pour l'améliorer, donc restez à l'affût des versions à venir !

À vous de jouer !

Pour en savoir plus, rendez-vous sur notre page consacrée à Elastic AI Assistant ou consultez les notes de publication.

Les clients qui utilisent déjà Elastic Cloud peuvent accéder à la majorité de ces fonctionnalités directement depuis la console Elastic Cloud. Vous n'utilisez pas Elastic sur le cloud ? Démarrez un essai gratuit.

La publication et la date de publication de toute fonctionnalité ou fonction décrite dans le présent article restent à la seule discrétion d'Elastic. Toute fonctionnalité ou fonction qui n'est actuellement pas disponible peut ne pas être livrée à temps ou ne pas être livrée du tout.

Dans cet article, nous sommes susceptibles d'avoir utilisé ou mentionné des outils d'intelligence artificielle générative tiers appartenant à leurs propriétaires respectifs qui en assurent aussi le fonctionnement. Elastic n'a aucun contrôle sur les outils tiers et n'est en aucun cas responsable de leur contenu, de leur fonctionnement, de leur utilisation, ni de toute perte ou de tout dommage susceptible de survenir à cause de l'utilisation de tels outils. Lorsque vous utilisez des outils d'IA avec des informations personnelles, sensibles ou confidentielles, veuillez faire preuve de prudence. Toute donnée que vous saisissez dans ces solutions peut être utilisée pour l'entraînement de l'IA ou à d'autres fins. Vous n'avez aucune garantie que la sécurisation ou la confidentialité des informations renseignées sera assurée. Vous devriez vous familiariser avec les pratiques en matière de protection des données personnelles et les conditions d'utilisation de tout outil d'intelligence artificielle générative avant de l'utiliser.

Elastic, Elasticsearch, ESRE, Elasticsearch Relevance Engine et les marques associées sont des marques commerciales, des logos ou des marques déposées d'Elasticsearch N.V. aux États-Unis et dans d'autres pays. Tous les autres noms de produits et d'entreprises sont des marques commerciales, des logos ou des marques déposées appartenant à leurs propriétaires respectifs.