Nouveautés d'Elastic Observability 7.12 : corrélations APM et prise en charge native d'OpenTelemetry

Elle vient de sortir et vous allez l'adorer : la version 7.12 d'Elastic Observability est arrivée ! Les causes premières n'auront bientôt plus de secret pour vous avec les corrélations dans Elastic APM. Grâce à la prise en charge ARM dans les agents Beats et Elastic Agent, monitorez facilement les appareils à faible puissance. Simplifiez les architectures d'ingestion avec la prise en charge native d'OpenTelemetry pour les logs et les indicateurs. Et faites des économies, avec le scaling automatique d'Elastic Cloud et les snapshots interrogeables du niveau frozen. La version 7.12 a beaucoup à offrir.

Envie de voir par vous-même ? Essayez la dernière version d'Elastic Observability intégrée à l'offre officielle Elasticsearch Service sur Elastic Cloud gratuitement pendant 14 jours. Ou, si vous préférez, installez la dernière version de la Suite Elastic pour bénéficier d'une expérience autogérée et découvrir les nombreuses fonctionnalités du niveau gratuit et ouvert.

Et maintenant, sans plus attendre, voici quelques points forts de cette version :

Faites automatiquement remonter les facteurs qui ralentissent les applications et provoquent des erreurs avec les corrélations APM

Nouveauté d'Elastic APM, la fonctionnalité de corrélation permet d'analyser les transactions d'application qui présentent des latences élevées ou un grand nombre d'erreurs. Cette fonctionnalité fait automatiquement remonter certains facteurs, comme la version de service ou les métadonnées d'infrastructure, qui sont en étroite corrélation avec ces transactions peu performantes. Les utilisateurs peuvent ainsi se concentrer instantanément sur la cause du problème en cas de résolution réactive, ce qui permet d'accélérer le temps moyen de résolution. Cette fonctionnalité permet également une approche proactive : les propriétaires d'application peuvent identifier les points à améliorer et, de là, optimiser l'expérience de l'utilisateur final.

Par exemple, elle peut mettre en avant une version de service spécifique étroitement liée à des problèmes de performances, ou un client qui apparaît régulièrement dans les transactions comportant des erreurs. Toutes ces informations apparaissent dans l'interface utilisateur APM. Les ingénieurs peuvent donc affiner les étapes suivantes de leur recherche.

Les corrélations APM s'appuient sur l'agrégation de termes significatifs dans Elasticsearch. De là, elles comparent les balises des transactions présentant une latence élevée ou un nombre d'erreurs important par rapport à l'ensemble des transactions, ce qui leur permet d'identifier automatiquement les balises ou les métadonnées "extraordinairement communes" dans les transactions non optimales, c'est-à-dire les éléments bien plus présents dans les transactions non optimales que dans l'ensemble. Par défaut, le seuil de la latence est déterminé sur le 75e percentile. Mais vous pouvez le personnaliser. Les balises incluses dans l'analyse sont les suivantes : pour les services backend, il s'agit des termes sur mesure, de l'infrastructure et de la version de service ; pour les services frontend, il s'agit des termes sur mesure, du système d'exploitation et du type de client.

Pour en savoir plus sur le sujet et sur l'APM, consultez cette documentation.

Suivez la dynamique des demandes avec le scaling automatique sur Elastic Cloud

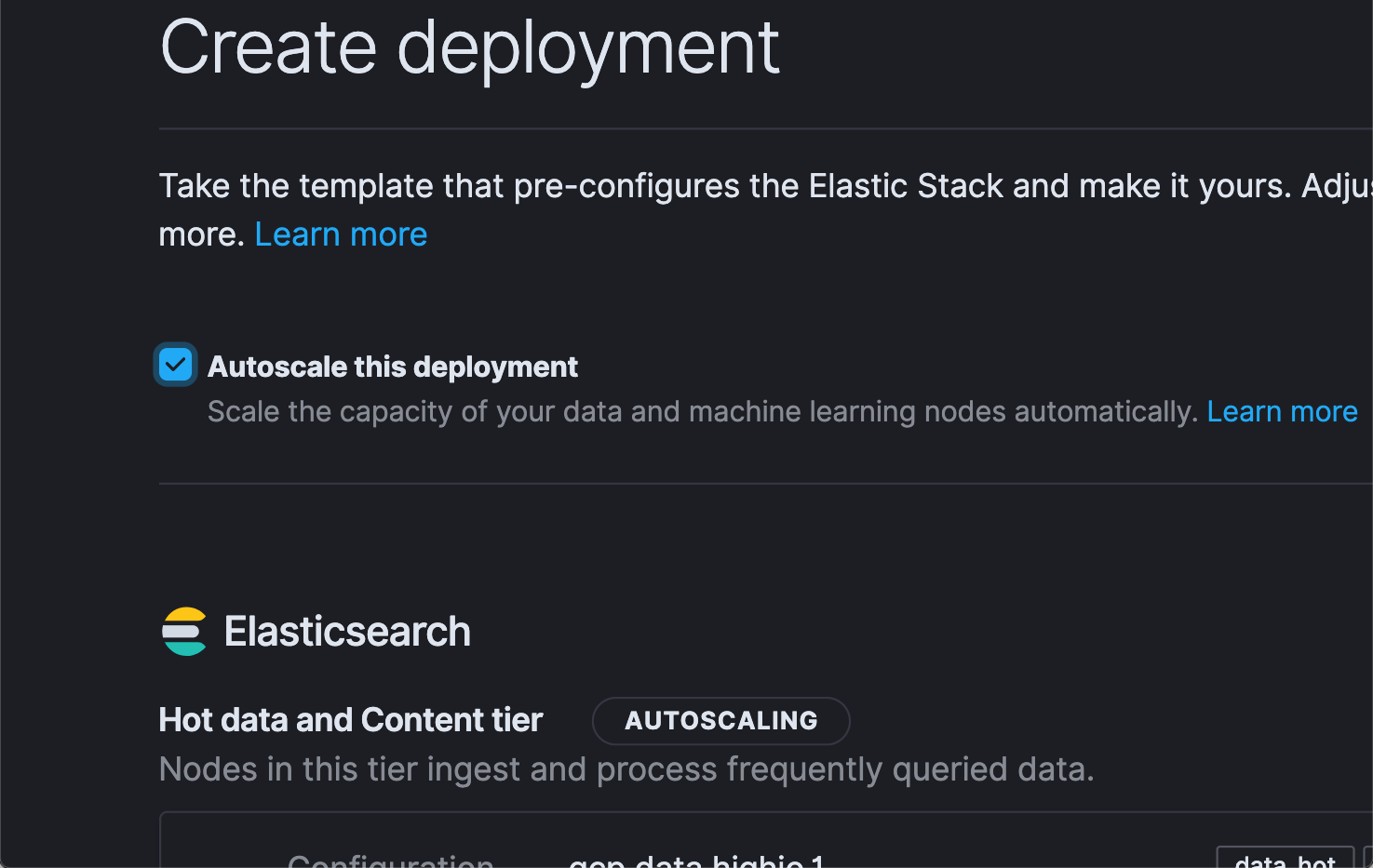

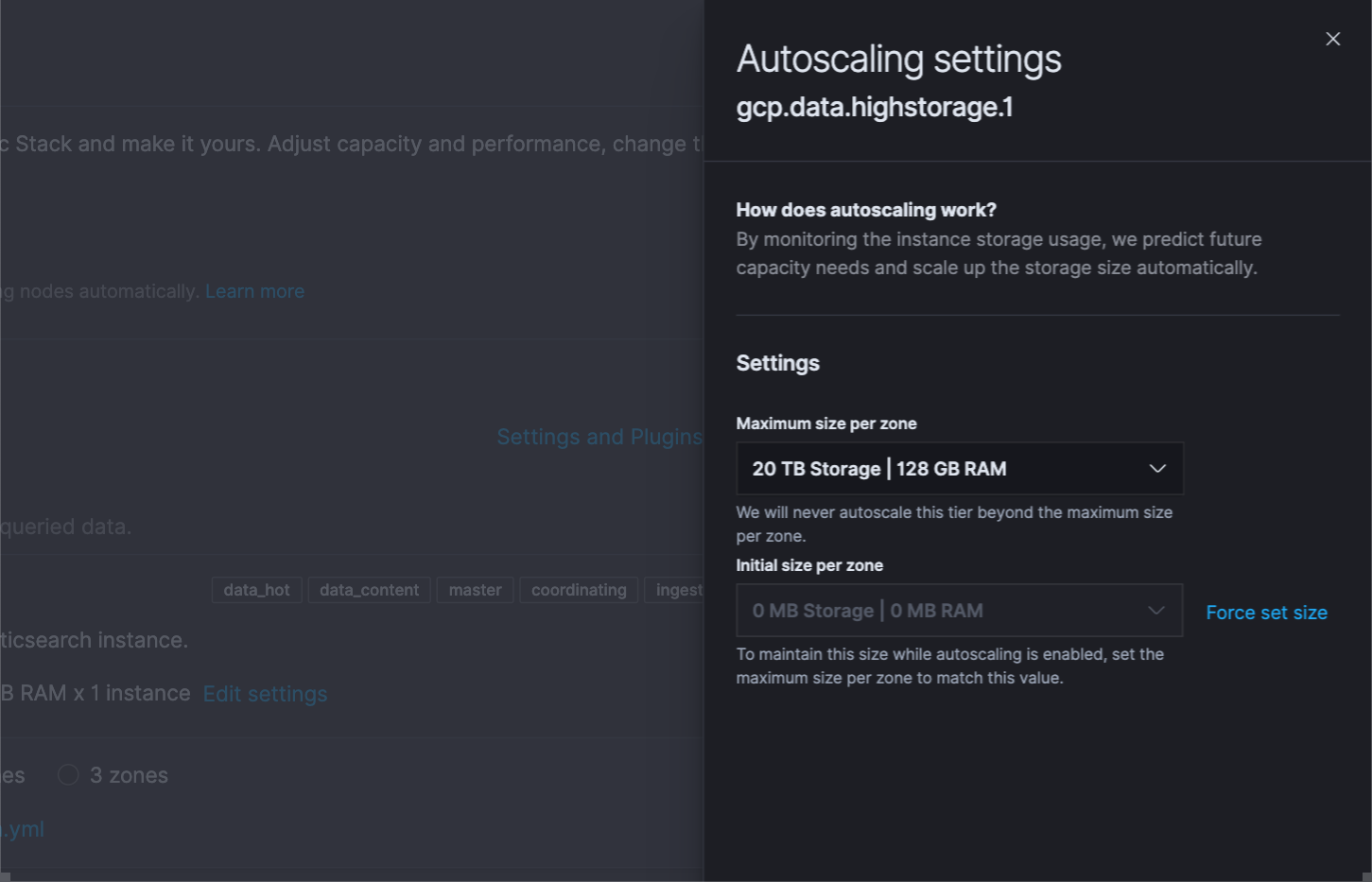

Beaucoup de clients Elastic se tournent vers Elastic Cloud pour exécuter et gérer leurs déploiements Elastic. C'est par exemple le cas d'Audi. La raison ? Elastic Cloud simplifie les opérations avec les fonctionnalités qu'il propose, comme les mises à niveau en un clic ou les modèles de déploiement. Et pour pousser notre avantage, une nouvelle fonctionnalité vient faire son entrée : le scaling automatique. C'est une petite révolution dont les organisations vont raffoler ! On peut d'ailleurs dire que cette fonctionnalité était vivement attendue par les utilisateurs de l'observabilité. Ceux-ci cherchaient en effet des méthodes simples pour suivre la dynamique des demandes, sans avoir à débourser des mille et des cents pour une capacité maximale.

Jusqu'ici, il était déjà très simple de scaler votre cluster sur Elastic Cloud. Un déplacement de curseur, un appel d'API, et le tour était joué. Avec le scaling automatique, nous allons encore plus loin dans la simplification. Activez cette fonctionnalité en cochant la case correspondante dans l'interface utilisateur ou en passant par un appel API/CLI programmé, et Elastic Cloud se chargera de scaler automatiquement la capacité pour suivre la dynamique des demandes dans le cluster. C'est aussi simple que cela. Et pour éviter les mauvaises surprises, vous pouvez même définir des seuils maximums.

Le scaling automatique est actuellement disponible pour les nœuds de stockage de données et de Machine Learning. Par la suite, il sera proposé sur d'autres types de nœuds.

Pour en savoir plus sur le sujet, consultez l'article sur les nouveautés de la Suite Elastic.

Monitorez votre infrastructure avec la prise en charge d'ARM dans les agents Beats et Elastic Agent

Pendant longtemps, les architectures ARM ont dominé le marché des appareils mobiles et IoT en raison de leur efficacité énergétique et de leur portabilité. Plus récemment, ARM a commencé à s'imposer comme une solution intéressante dans le domaine du cloud computing côté serveur. AWS a introduit plusieurs instances EC2 basées sur ARM. Microsoft et Google Cloud s'apprêtent également à suivre la tendance.

Conformément à notre philosophie d'être là où les utilisateurs se trouvent, nous sommes très heureux d'annoncer la prise en charge d'architectures basées sur ARM dans la Suite Elastic, notamment avec les agents Beats et Elastic Agent. Désormais, les clients qui possèdent des serveurs ou des appareils fonctionnant avec ARM peuvent se servir des agents Beats ou d'Elastic Agent pour collecter les données d'intégrité et de performances et, de là, monitorer leurs points de terminaison. De nombreux utilisateurs n'ont qu'un usage basique du calcul basé sur ARM et fonctionnent dans des environnements hybrides. Dorénavant, ces utilisateurs peuvent monitorer leur infrastructure ARM en plus du reste de leur infrastructure dans une pile unifiée.

Mention spéciale à la communauté IoT, qui adopté la Suite Elastic de manière organique comme plateforme flexible et scalable pour l'Edge Monitoring. Ces utilisateurs peuvent maintenant exécuter les agents Beats et Elastic Agent en périphérie, ce qui simplifie encore plus leurs architectures d'ingestion.

Prise en charge native d'OpenTelemetry

OpenTelemetry agit comme une couche de collecte normalisée pour les données d'observabilité. Elle permet aux entreprises d'instrumenter leurs applications de manière ouverte et indépendante. Nous sommes donc très heureux d'annoncer la prise en charge native d'OpenTelemetry avec Elastic Observability. Les entreprises ont désormais la possibilité d'envoyer les données collectées par les agents OpenTelemetry à leurs déploiements Elastic. Non seulement l'adoption d'OpenTelemetry se fait plus facilement dans l'architecture Elastic existante, mais en plus l'architecture s'en retrouve simplifiée.

Encore un pas de plus dans notre prise en charge d'OpenTelemetry... En juillet 2020, nous avons lancé l'exportateur Elastic sur le collecteur OpenTelemetry. Il s'agit d'une couche de traduction entre les agents OpenTelemetry et Elastic APM. Avec l'ajout de la prise en charge native (marquée comme fonctionnalité expérimentale dans la version 7.12), plus besoin d'installer et de gérer ce composant supplémentaire. Les utilisateurs peuvent désormais envoyer directement des données de leurs agents OpenTelemetry vers le serveur Elastic APM.

La prise en charge native d'OpenTelemetry est désormais disponible avec Elastic Observability sur les déploiements autonomes autogérés. Elle sera prochainement proposée sur Elastic Cloud et ECE.

Et ce n'est pas tout !

Le niveau frozen, en préversion technique, permet aux utilisateurs de faire directement des recherches sur les données stockées sur des services de stockage d'objets comme Amazon S3, Google Cloud Storage, ou encore Microsoft Azure Storage. Imaginez que vous puissiez faire des recherches sur des années de données de logs sans avoir à les réactiver... C'est ce que nous vous proposons désormais !

Et pour améliorer encore plus l'expérience utilisateur lors de l'exécution de tâches longues dans Kibana, nous ajoutons une option d'enregistrement de la recherche en arrière-plan. Vous pouvez donc envoyer vos requêtes longues en arrière-plan pour libérer Kibana et réaliser d'autres analyses et explorations.

Pour en savoir plus sur ces fonctionnalités et d'autres points forts de la Suite Elastic, lisez notre article sur le lancement d'Elastic 7.12.

La publication et la date de publication de toute fonctionnalité ou fonction décrite dans le présent document restent à la seule discrétion d'Elastic. Toute fonctionnalité ou fonction qui n'est actuellement pas disponible peut ne pas être livrée à temps ou ne pas être livrée du tout.