What is continuous profiling?

Définition du profilage continu

Le profilage continu consiste à collecter en permanence des données de performance auprès d'applications s'exécutant dans des environnements de production en direct afin d'optimiser les performances et d'améliorer l'utilisation des ressources.

Contrairement aux méthodes traditionnelles qui recueillent des échantillons de données ponctuellement ou à la demande, le profilage continu capture des indicateurs en temps réel. Cela permet de fournir une vue plus précise et actuelle des performances et du comportement des applications. En outre, le profilage se concentre particulièrement sur les environnements de production grâce au suivi de l'utilisation des ressources et à la mise à disposition d'informations exploitables au niveau du code. Cette approche s'avère utile à court terme et facilite l'analyse sur le long terme avec une surcharge minimale.

Plusieurs améliorations importantes soulignent son évolution depuis les pratiques traditionnelles de profilage. Il s'agit notamment du passage de l'analyse ponctuelle à une collecte continue des données, de la réduction drastique de l'influence des performances grâce à l'innovation d'eBPF et de son intégration aux outils d'observabilité. Par ailleurs, les systèmes modernes de profilage continu intègrent des fonctionnalités d'analyse automatisées qui utilisent l'intelligence artificielle et le Machine Learning, mais aussi peuvent prendre en charge un éventail de langages de programmation. Ils sont également conçus pour s'associer de manière idéale aux systèmes distribués comme cloud-native.

Importance du profilage continu

Identification et résolution des goulets d'étranglement des performances

Grâce au profilage continu, il est possible de détecter et de résoudre en temps réel les goulets d'étrangement des performances. En collectant en permanence des données d'utilisation des ressources (notamment sur le processeur, la mémoire et les entrées et sorties de disque), vous obtenez des informations exploitables détaillées sur les comportements des systèmes au moment où ils se manifestent. Ainsi, les équipes de développement peuvent identifier l'emplacement exact des inefficacités au sein de leur code. Ainsi, elles sont en mesure d'améliorer les performances globales des applications et de résoudre les problèmes dans ce domaine de manière proactive.

Avantages pour l'équipe de développement

Le profilage continu améliorera aussi la qualité du code en permettant aux équipes de développement d'identifier et de résoudre plus facilement les problèmes de performance qui ne surviendraient pas dans les environnements de développement ou de test. Ainsi, vous obtenez un code de production plus solide et plus efficace. Par ailleurs, le processus de résolution est optimisé grâce à la capacité à analyser des données en temps réel, ce qui accélère l'identification des problèmes intermittents. Par conséquent, le temps de débogage est diminué et la productivité est renforcée. En fournissant des informations exploitables sur le comportement et les performances des applications, le profilage continu apporte aussi de meilleures scalabilité et fiabilité aux équipes SRE. En effet, ces dernières peuvent s'assurer qu'une application est capable de gérer des charges accrues sans subir de baisse de performance.

Avantages pour les entreprises

En ayant recours au profilage continu pour optimiser l'utilisation des ressources, les entreprises peuvent réduire leurs coûts en diminuant leur consommation des ressources dans le cloud et les frais connexes. En outre, l'empreinte carbone des centres de données est réduite, ce qui aide les entreprises à améliorer leur responsabilité environnementale globale dans le secteur des technologies.

L'amélioration des performances d'une application peut indirectement générer une meilleure expérience pour les utilisateurs, ce qui renforce la satisfaction de la clientèle et optimise éventuellement sa fidélisation.

Fonctionnement du profilage continu

1re étape : collecte de données

La première étape du profilage continu consiste à collecter les données requises. En règle générale, ce processus se fonde sur des techniques d'échantillonnage à faible surcharge afin de recueillir des indicateurs, comme l'allocation de la mémoire, l'utilisation du processeur, mais aussi les opérations d'entrée et de sortie. Tout cela est possible en intégrant des outils, comme eBPF, JProfiler et Universal Profiling d'Elastic.

Ces outils sont intégrés à des systèmes, tels que des agents, des bibliothèques ou des modules de noyaux. La méthode dépend de la technologie spécifique que vous choisissez et du niveau d'accès requis. Il existe également des différences entre les approches de profilage quant à leurs exigences en matière de ressources et de conséquences.

- Systèmes de profilage légers et en perpétuelle exécution : leur surcharge est minimale, ce qui les rend adaptés à une utilisation continue dans des environnements de production.

- Systèmes de profilage d'échantillonnage : ils collectent régulièrement des données avec une surcharge faible à moyenne.

- Systèmes de profilage d'instrumentation : ils collectent des données plus détaillées, mais avec une surcharge plus élevée. Ils sont souvent utilisés dans des environnements de développement, de test ou de mise en service.

- Outils de traçage : ils mènent des collectes de données exhaustives, ce qui génère une surcharge significative. En règle générale, ils sont utilisés lors de séances de débogage précises.

2e étape : analyse

Une fois les données recueillies, elles sont analysées afin d'identifier les goulets d'étranglement des performances, les schémas d'utilisation des ressources et les optimisations éventuelles, entre autres. Souvent, ce processus implique de rassembler les informations au fil du temps, de les référencer de manière croisée avec les événements survenant dans les applications, puis d'appliquer des méthodes statistiques afin de détecter les anomalies et les tendances. L'objectif de cette étape est de transformer les données en informations exploitables.

Le profilage continu peut également être associé aux données de monitoring des performances applicatives (APM), comme des traces, afin de trouver exactement le code qui a été exécuté lorsqu'une trace spécifique est apparue. Ainsi, le temps moyen d'identification de la cause première est réduit en améliorant le contexte.

Souvent, des techniques avancées sont utilisées à cette étape afin d'optimiser l'analyse, notamment en ayant recours à des outils de Machine Learning et d'intelligence artificielle. Elles sont particulièrement performantes pour classer de manière automatique les problèmes, pour prévoir les futures performances et pour suggérer les éventuelles optimisations à apporter.

3e étape : visualisation

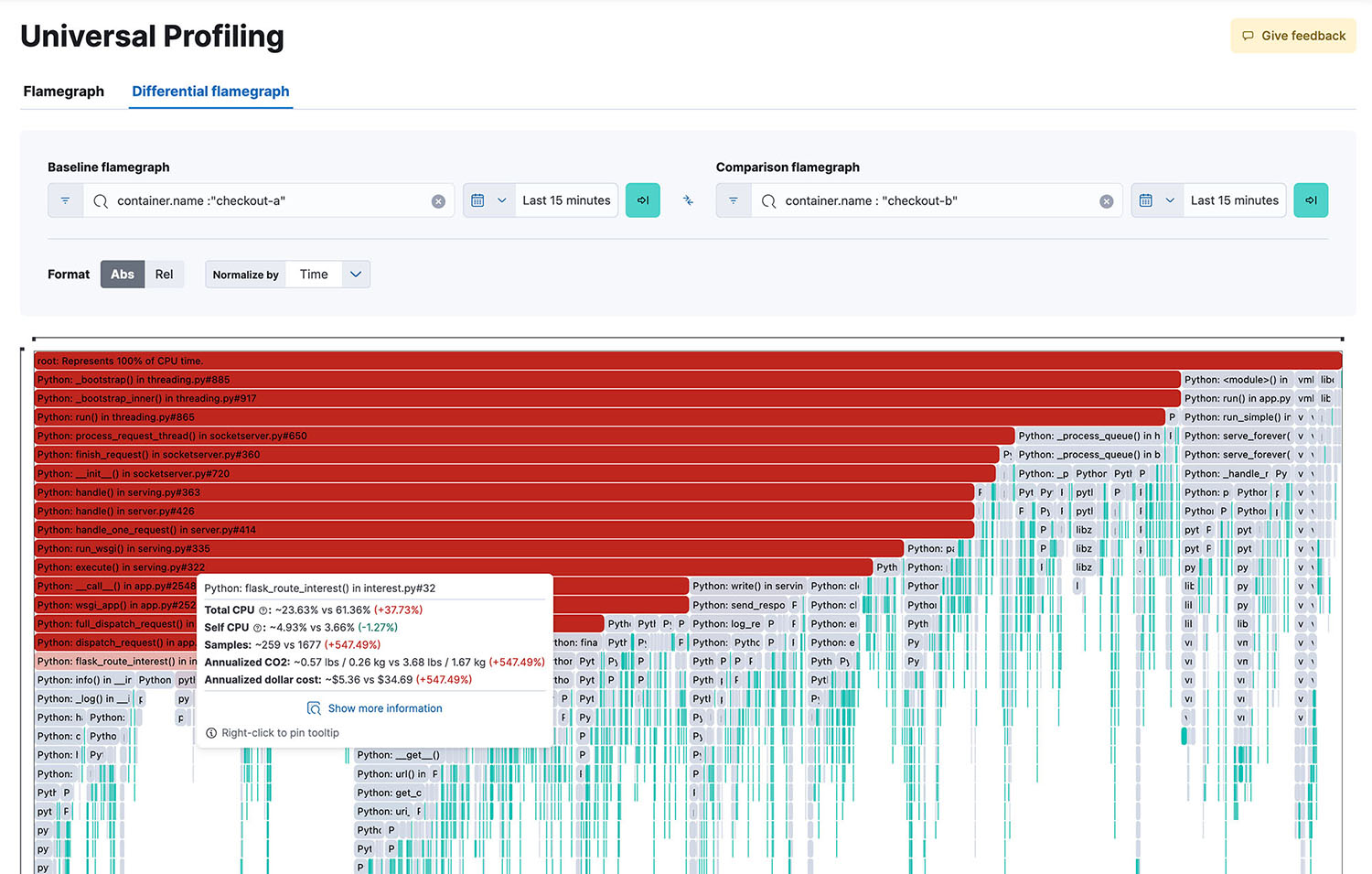

L'étape de visualisation transforme les données de performance complexes en représentations visuelles intuitives et faciles à comprendre. Elle aide les équipes de développement et chargées des opérations à identifier rapidement les goulets d'étranglement des performances, les modèles d'utilisation et les domaines à améliorer. Les techniques couramment utilisées comprennent les graphiques en flamme, ce qui facilite le repérage des chemins de code au niveau hot et des graphiques icicle. Ces derniers représentent l'utilisation du temps relatif dans différentes parties du code.

Ces visualisations sont souvent interactives, ce qui permet de zoomer, de filtrer les données et d'étudier en profondeur les fonctions ou les points problématiques spécifiques. La plupart des outils de profilage fournissent des tableaux de bord qui rassemblent plusieurs visualisations et indicateurs en un lieu unique.

Profilage continu en pratique

Cas d'utilisation

- Optimisation d'une plateforme d'e-commerce : utilisez le profilage continu afin d'identifier les requêtes lentes dans les bases de données qui influent sur le processus de paiement et de diminuer les temps de chargement des pages en optimisant les fonctions gourmandes en ressources.

- Performances d'une architecture de microservices : repérez les goulets d'étranglement spécifiques dans les communications entre les services et optimisez l'attribution des ressources au sein de tous les systèmes distribués. Optimisation des coûts du cloud : identifiez le code inefficace qui engendre une utilisation excessive de la mémoire ou du processeur et réduisez les coûts d'hébergement dans le cloud en optimisant la consommation des ressources.

- Systèmes de traitement des données en temps réel : détectez et éliminez les goulets d'étranglement de traitement des données et renforcez les pipelines de traitement des flux afin de diminuer la latence.

- Gestion et résolution des incidents : identifiez rapidement la cause première des problèmes de performance, ce qui réduit le temps moyen de résolution.

Bonnes pratiques

- Intégrez le profilage continu au début du processus de développement et utilisez des techniques d'échantillonnage à faible surcharge.

- Automatisez la collection des données, l'analyse et l'alerting afin d'obtenir des réponses rapides et de garantir la cohérence.

- Reliez le profilage aux outils d'observabilité et d'APM afin d'obtenir des informations exploitables exhaustives.

- Mettez en œuvre l'intégration de pipelines d'intégration et de livraison continues afin d'obtenir un profilage continu pour les tests des unités.

- Mettez en place des mesures régulières de révision et des boucles de rétroaction pour l'optimisation continue.

- Assurez-vous de l'actualisation et de la maintenance régulière de l'ensemble des outils de profilage.

- Formez les membres de votre équipe à l'interprétation et à l'analyse efficace des données de profilage.

Défis et limites du profilage continu

Surcharge de performances

Même avec des techniques d'échantillonnage à faible surcharge, chaque type de profilage continu générera des surcharges de performance pour les systèmes qui sont monitorés. Il pourrait influer sur les performances des applications, en particulier dans les environnements limités en ressources. Vous pouvez réduire la surcharge des performances de trois manières différentes :

- Le cas échéant, utilisez les systèmes de profilage fondés sur eBPF dont la surcharge est minimale.

- Mettez en œuvre un profilage adaptatif afin de réduire la fréquence lors des périodes très chargées.

- Concentrez-vous sur le profilage des éléments fondamentaux uniquement au lieu de systèmes entiers.

Questions liées à la confidentialité des données

À l'instar de tout processus comprenant la collecte des données, il existe un risque que les informations recueillies soient notamment sensibles, en particulier celles provenant des utilisateurs. Pour résoudre ces problèmes :

- mettez en œuvre de solides contrôles des accès et cryptage pour toutes les données de profilage ;

- anonymisez ou masquez les données sensibles avant de stocker, de partager ou de communiquer des informations ;

- respectez scrupuleusement toute réglementation pertinente en matière de protection des données.

Gestion et stockage des données

Le profilage continu peut générer de grandes quantités de données qui devront être stockées et gérées. Pour être efficace, vous pouvez avoir recours à des stratégies, notamment les suivantes :

- mise en œuvre de politiques de conservation des données qui limitent la durée de stockage ;

- compression des données ;

- exploitation du stockage dans le cloud afin d'améliorer la scalabilité.

Futures tendances, prises en charge par OpenTelemetry

La technologie évolue en permanence, ce qui peut améliorer le profilage continu, mais aussi créer des défis inattendus et inédits. Vous ne pouvez pas les anticiper de manière proactive. Toutefois, il est important de connaître les nouveaux outils ou techniques afin de déterminer s'ils représentent une bonne alternative pour votre entreprise.

Par exemple, OpenTelemetry a récemment annoncé sa prise en charge du profilage et travaille actuellement sur le profilage d'un modèle de données fondé sur les normes ouvertes. De tels changements du secteur peuvent faire une énorme différence dans l'adoption du profilage continu au sein de votre plateforme d'observabilité tout en réduisant la dépendance vis-à-vis d'un fournisseur.

Profilage continu avec Elastic

Elastic a lancé Universal Profiling, qui fournit aux entreprises une solution de profilage de l'ensemble des systèmes constamment en exécution par l'intermédiaire de leur pipeline de développement. Elle utilise le profilage eBPF pour capturer uniquement les données requises et s'intègre à OpenTelemetry afin d'améliorer l'observabilité et d'obtenir des informations exploitables plus précises. Voici les avantages qu'Elastic offre aux équipes.

- Visibilité sur l'ensemble du système : Elastic Universal Profiling capture et analyse les données provenant de vos noyaux, du code de vos applications et de bibliothèques tierces.

- Déploiement fluide : l'agent peut être déployé sans nécessiter d'opérations intrusives ni de modification du code source des applications. Ainsi, il est facile de commencer à recevoir des données de profilage en quelques minutes.

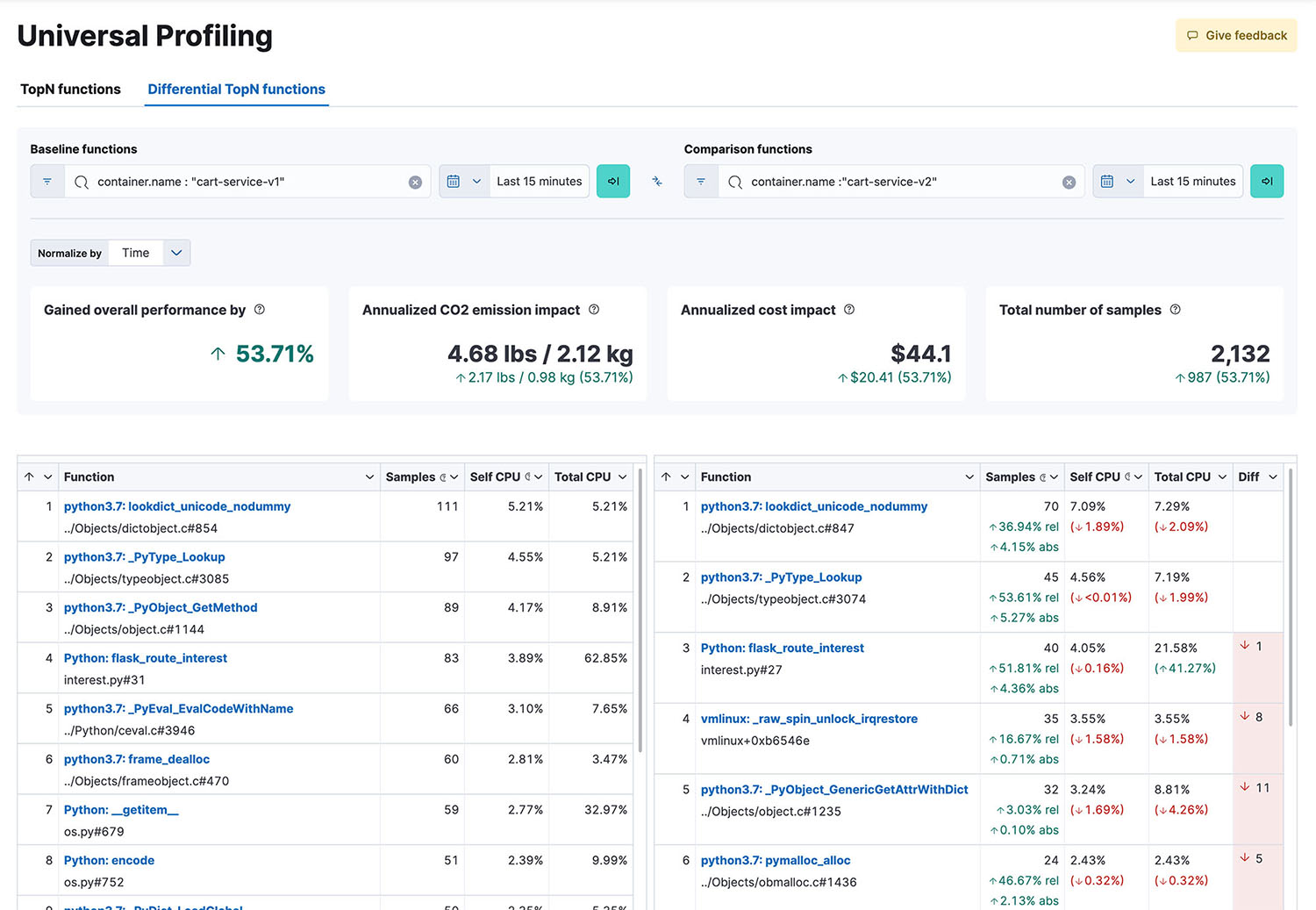

- Visualisation des données : les données de profilage peuvent être inspectées par le biais de traces de suite, de graphiques en flamme et de vues de fonction dans Kibana, ce qui facilite le filtrage et la comparaison des données au fil du temps en vue d'identifier les améliorations de performance ou de détecter les régressions.

Ressources pour le profilage continu

- Profilage continu : la condition essentielle pour obtenir des applications plus efficaces et rentables

- Pourquoi les indicateurs, les logs et les traces ne suffisent pas

- OpenTelemetry et Elastic : une collaboration pour mettre en place le profilage continu

- Agent Elastic Universal Profiling, une solution de profilage continu