検索拡張生成 — 検索の課題

Searchは、大規模言語モデル(LLM)を活用して最高の生成AIエクスペリエンスを構築するための重要なインフラストラクチャです。データを用いてLLMに正しい答えを出させる機会は一度きりですので、関連性が重要です。Elasticを使用して、検索拡張生成(RAG)で LLM を強化します。

この自習型ハンズオンラーニングを試して、RAGアプリケーションの構築方法を学びましょう。

実践的な学習を体験するRAG をアプリに組み込み、ベクトルデータベースを使用してさまざまな LLM をお試しください。

Elasticsearch Labsで詳細を確認チャットボットRAGアプリを実装するには、このガイドに従ってください。

ガイドを見るフォーチュン500企業に信頼され、生成AIイノベーションを推進

RAGに対応したデータを作成

RAGは、再トレーニングなしで関連する独自のデータにアクセスすることで、LLMのパワーを拡張します。RAGをElasticと一緒に使用すると、次のようなメリットがあります。

- 最先端の検索技術

- 簡単なモデル選択と、スムーズなモデルの交換機能

- ドキュメントとロールベースの安全なアクセスにより、データを確実に保護

検索エクスペリエンスをトランスフォーム

検索拡張生成(RAG)とは?

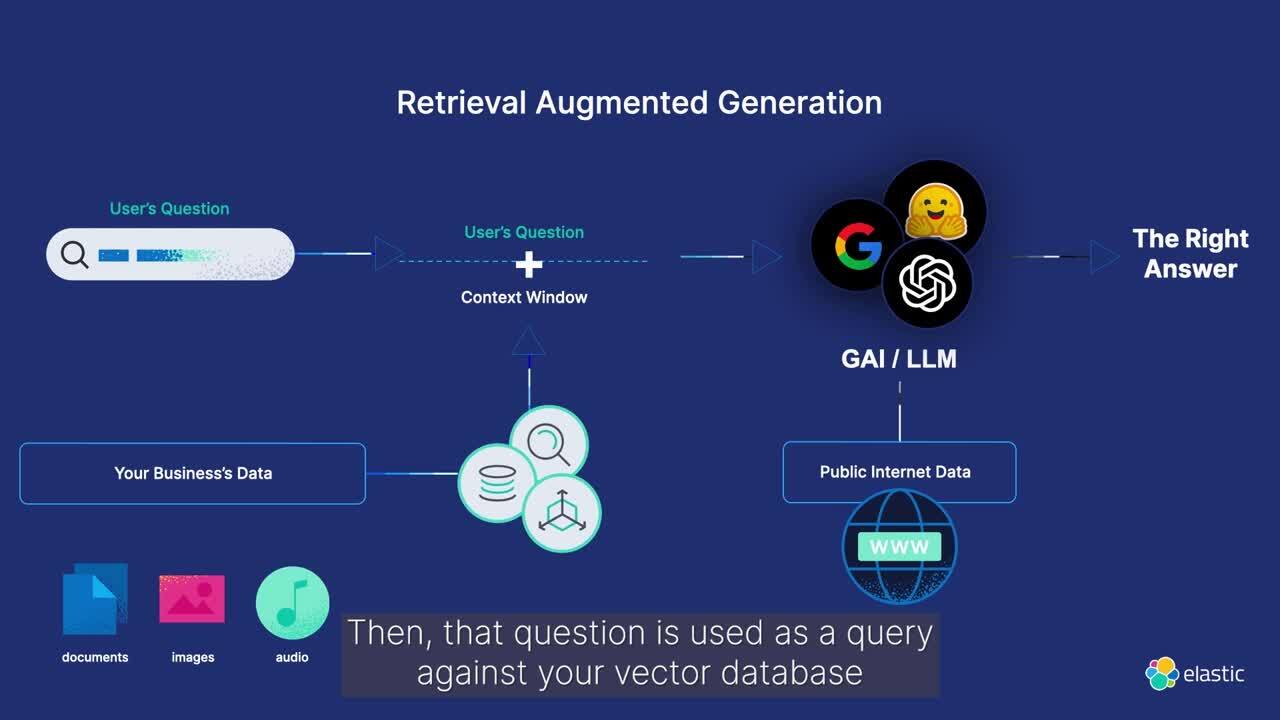

検索拡張生成(RAG)とは、独自のデータソースからの関連情報を統合してテキスト生成を強化するパターンのことです。RAGは、生成モデルにドメイン固有のコンテキストを提供することで、生成されたテキスト対応の精度と関連性を向上させます。

Elasticsearchを使用して専有データの高関連性コンテキストウィンドウを区切ることで、LLMの出力と関連性が改善され、安全かつ効率的な会話形式で情報を提供します。

RAGとElasticの連携方法

ElasticsearchでRAGワークフローを強化

RAGワークフローにElasticを利用して、生成AIエクスペリエンスを強化する方法をご確認ください。独自のデータソースを使ってリアルタイムの情報と簡単に同期し、生成AIから関連性の高い最良の回答を得ることができます。

機械学習の推論パイプラインは、Elasticsearchのインジェストプロセッサを使用して効率的に埋め込みを抽出します。テキスト(BM25と一致)とベクトル(kNN)検索をシームレスに組み合わせて、コンテキストに応じた対応生成のために、最もスコアの高いドキュメントを取得します。

ユースケース

プライベートデータセットで実行されるQ&Aサービス

Elasticsearchをベクトルデータベースとして活用し、RAGを用いたQ&Aエクスペリエンスを実装してください。

Elasticsearch — 最も広く導入されているベクトルデータベース

AI検索 — 実行中

組織がAI検索アプリケーションを構築して顧客エクスペリエンスを向上させ、ユーザーがまさに探しているものを見つけられるようにしている事例をご紹介します。

お客様事例

ConsensusはElasticの高度なセマンティック検索とAIツールで学術研究プラットフォームをアップグレード

お客様事例

DocusignはElasticを活用して世界中の顧客に生成AIのパワーを提供しています。

お客様事例

ジョージア州立大学では、AIを活用した検索で、データインサイトを強化し、学生の学資援助申請の支援を模索しています。

よくあるご質問

検索拡張生成(通称RAG)は、企業が独自のデータソースを検索し、大規模言語モデルの基盤となるコンテキストを提供する自然言語処理パターンです。これにより、生成AIアプリケーションにおいて、より正確でリアルタイムな対応が可能になります。

RAGを最適に実装すれば、関連するドメイン固有の専有データへの安全なアクセスがリアルタイムで提供されます。生成AIアプリケーションにおけるハルシネーションの発生率を低下させ、応答の精度を向上させることができます。

RAGは、以下に依存する複雑な技術です:

- 入力されるデータの品質

- 検索取得の有効性

- データセキュリティ

- 生成AIの応答のソースを引用して結果を微調整する能力

さらに、急速に変化するエコシステムにおいて、適切な生成AIまたは大規模言語モデル(LLM)を選択することは、組織に課題をもたらす可能性があります。また、RAGに関連するコスト、パフォーマンス、拡張性により、アプリケーションを本番環境に立ち上げる速度が遅くなる可能性があります。

Elasticsearch は、あらゆるソースからの構造化データと非構造化データをインデックス化および格納できる柔軟なAIプラットフォームおよびベクトルデータベースです。何十億もの文書にわたる効率的でカスタマイズ可能な情報検索と自動ベクトル化を提供します。また、ロールレベルとドキュメントレベルのアクセス制御により、エンタープライズセキュリティを提供します。Elasticは、ハイパースケーラー、モデルリポジトリ、フレームワークなど、拡大する生成AIエコシステム全体のイノベーションを活用するための標準インターフェースも提供します。しかも、Elasticは実稼働規模の環境で実証されており、フォーチュン500企業の50%以上にサービスを提供しています。Playgroundを使用してElasticでRAGシステムを構築する方法をご覧ください。

Elasticはクラスター横断検索(CCS)とクラスター横断レプリケーション(CCR)を提供し、プライベート、オンプレミス、クラウド環境全体でデータを管理および保護するのに役立ちます。CCSとCCRを使用すると、次のことができます。

- 高可用性を確保する

- グローバルなデータ保護規制への準拠を維持する

- データプライバシーと主権を実現する

- 効果的な災害復旧戦略を構築する

Elasticは、ロールベースおよびドキュメントレベルのアクセス制御も提供しています。これにより、顧客と従業員は、アクセスできるデータを含む回答のみを受け取ることができます。そして、ユーザーはあらゆるデプロイメントに対する包括的なオブザーバビリティと監視から洞察を得ることができます。