Retrieval Augmented Generation – ein Suchproblem

Search ist eine kritische Infrastruktur für die Arbeit mit großen Sprachmodellen (LLMs) zur Gewährleistung der besten generativen KI-Erlebnisse. Sie haben nur eine Chance, ein LLM dazu zu bringen, mit Ihren Daten die richtige Antwort zu liefern. Daher ist die Relevanz entscheidend. Nutzen Sie Ihre LLMs mit Retrieval Augmented Generation (RAG) mithilfe von Elastic.

Probieren Sie praktisches Lernen im eigenen Tempo aus und erfahren Sie, wie man eine RAG-Anwendung erstellt.

Probieren Sie praxisnahes Lernen ausIntegrieren Sie RAG in Ihre Apps und testen Sie verschiedene LLMs mit einer Vektordatenbank.

Erfahren Sie mehr über Elasticsearch LabsBefolgen Sie diese Anleitung, um eine Chatbot-RAG-App zu implementieren.

Erste-Schritte-Anleitung ansehenDIE FORTUNE 500 VERTRAUEN DARAUF, UM GENERATIVE KI-INNOVATIONEN ZU FÖRDERN

Bereiten Sie Ihre Daten für RAG vor

RAG erweitert die Leistungsfähigkeit von LLMs durch den Zugriff auf relevante proprietäre Daten ohne erneutes Training. Bei der Verwendung von RAG mit Elastic profitieren Sie von Folgendem:

- Hochmoderne Suchtechniken

- Einfache Modellauswahl und die Fähigkeit, Modelle mühelos auszutauschen

- Sicherer dokumenten- und rollenbasierter Zugriff zur Gewährleistung des Datenschutzes

Sucherlebnisse transformiert

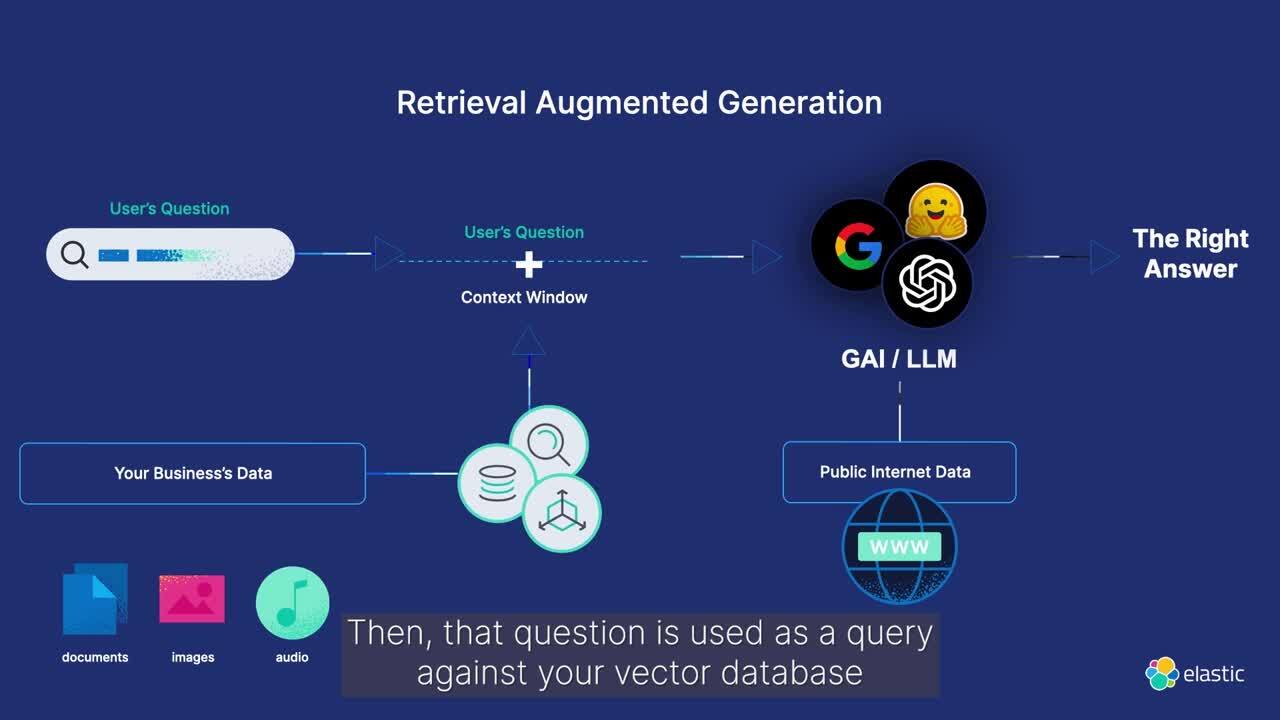

Was versteht man unter Retrieval Augmented Generation?

Retrieval Augmented Generation (RAG) ist ein Muster, das die Texterstellung durch die Integration relevanter Informationen aus proprietären Datenquellen verbessert. Durch die Bereitstellung von domänenspezifischem Kontext für das generative Modell verbessert RAG die Genauigkeit und Relevanz der generierten Textantworten.

Nutzen Sie Elasticsearch für hochrelevante Kontextfenster, die zur Verbesserung der LLM-Ausgabe und Bereitstellung von Informationen in einem sicheren und effizienten dialogorientierten Erlebnis auf Ihre proprietären Daten zurückgreifen.

SO FUNKTIONIERT RAG MIT ELASTIC

RAG-Workflows mit Elasticsearch optimieren

Erfahren Sie, wie Elastic für RAG-Workflows auf generativer KI basierende Erlebnisse verbessert. Synchronisieren Sie Ihre Daten ganz einfach anhand proprietärer Datenquellen mit Informationen in Echtzeit, um mithilfe von generativer KI die besten und relevantesten Antworten zu erhalten.

Die Inferenzpipeline für maschinelles Lernen nutzt für die effiziente Extraktion von Einbettungen die Ingest-Prozessoren von Elasticsearch. Durch die nahtlose Kombination von Text- (BM25-Match) und Vektorsuchen (kNN) werden die Dokumente mit den besten Ergebnissen für die kontextabhängige Erstellung von Antworten abgerufen.

ANWENDUNGSFALL

Q&A-Dienst, der auf Ihrem privaten Datensatz läuft.

Implementieren Sie Q&A-Erlebnisse mit RAG, unterstützt von Elasticsearch als Vektordatenbank.

Elasticsearch – die am weitesten verbreitete Vektordatenbank

Kopieren Sie, um es in zwei Minuten lokal auszuprobieren

curl -fsSL https://elastic.co/start-local | shAI Search – in Aktion

Erfahren Sie, wie Unternehmen KI-Suchanwendungen entwickeln, um das Kundenerlebnis zu verbessern und den Nutzer:innen zu helfen, genau das zu finden, was sie suchen.

Kunden-Spotlight

Consensus aktualisiert die wissenschaftliche Rechercheplattform des Unternehmens mit semantischer Suche und KI-Tools von Elastic.

Kunden-Spotlight

DocuSign bringt die Leistungsfähigkeit der generativen KI mit Elastic weltweit zu Kund:innen.

Kunden-Spotlight

Die Georgia State University verbessert ihre Dateneinblicke und untersucht, wie sie Studierenden mit einer KI-gestützten Suche bei der Beantragung finanzieller Unterstützung helfen kann.

Häufig gestellte Fragen

Retrieval Augmented Generation (allgemein als RAG bezeichnet) ist ein Muster für die Verarbeitung natürlicher Sprache, mit dem Unternehmen proprietäre Datenquellen durchsuchen und Kontext bereitstellen können, der die Grundlage für umfangreiche Sprachmodelle bildet. Somit lassen sich bei generativen KI-Anwendungen genauere Antworten in Echtzeit geben.

Bei optimaler Implementierung bietet RAG sicheren Zugriff auf relevante, domänenspezifische proprietäre Daten in Echtzeit. Es kann die Häufigkeit von Halluzinationen bei generativen KI-Anwendungen verringern und die Präzision der Antworten erhöhen.

Die RAG ist eine komplexe Technologie, die sich auf Folgendes stützt:

- Die Qualität der in das System eingespeisten Daten

- Die Effektivität der Suchabfragen

- Datensicherheit

- Die Fähigkeit, die Quellen der generativen KI-Antworten für die Optimierung der Ergebnisse zu zitieren

Darüber hinaus kann die Wahl der richtigen generativen KI oder eines großen Sprachmodells (LLM) in einem schnelllebigen Ökosystem eine Herausforderung für Unternehmen darstellen. Und die mit RAG verbundenen Kosten, die Leistung und die Skalierbarkeit können die Geschwindigkeit beeinträchtigen, mit der Unternehmen Anwendungen in Produktion bringen.

Elasticsearch ist eine flexible KI-Plattform und Vektordatenbank, die strukturierte und unstrukturierte Daten aus jeder Quelle indexieren und speichern kann. Sie bietet eine effiziente und anpassbare Informationssuche und automatische Vektorisierung über Milliarden von Dokumenten hinweg. Zudem bietet sie Sicherheit für Unternehmen mit Zugriffskontrolle auf Rollen- und Dokumentebene. Elastic stellt auch eine Standardschnittstelle für den Zugriff auf Innovationen in einem wachsenden Ökosystem der generativen KI bereit, darunter Hyperscaler, Modell- Repositorys und Frameworks. Und schließlich hat sich Elastic in Produktionsumgebungen bewährt und wird von über 50 % der Fortune 500-Unternehmen genutzt. Erfahren Sie, wie Sie RAG-Systeme mit Playground in Elastic erstellen können.

Elastic bietet clusterübergreifende Suche (CCS) und clusterübergreifende Replikation (CCR), um Ihnen bei der Verwaltung und Sicherung von Daten in privaten, On-Prem- und Cloud-Umgebungen zu helfen. Mit CCS und CCR:

- Stellen Sie Hochverfügbarkeit sicher

- Gewährleisten Sie die Einhaltung globaler Datenschutzvorschriften

- Erreichen Sie Datenschutz und Datenhoheit

- Entwickeln Sie eine effektive Strategie zur Notfallwiederherstellung

Elastic bietet auch rollenbasierte und dokumentenbasierte Zugriffskontrolle an, mit der Kunden und Mitarbeitende nur Antworten mit Daten erhalten, auf die sie Zugriff haben. Und unsere Nutzer:innen gewinnen Einblicke aus umfassender Beobachtbarkeit und Monitoring für jedes Deployment.